麻省理工研究发现,商业人工智能存在严重的性别和肤色歧视

2018年02月13日 由 yuxiangyu 发表

821148

0

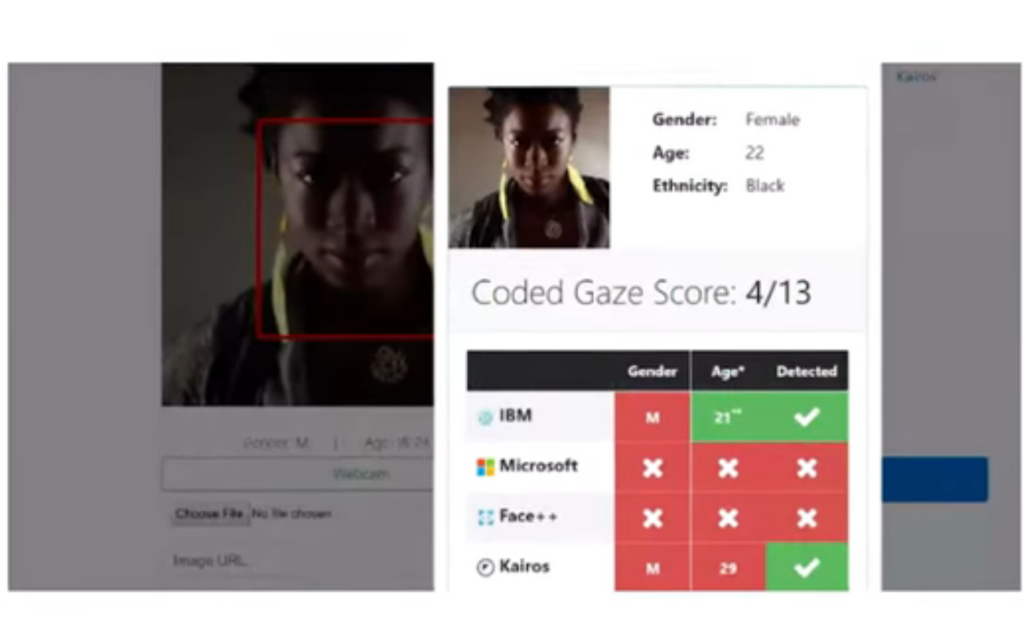

根据来自麻省理工学院和斯坦福大学将在公正,责任和透明的会议上(Fairness, Accountability, and Transparency)上发布的新论文显示,大型技术公司发布的三款商业化面部分析程序均有不同程度的肤色和性别偏见。

在研究人员的实验中,这三款程序在确定浅肤色男性的性别方面时,错误率从不低于0.8%。然而,识别肤色较深的女性时,错误率激增。其中一款程序错误率超过20%,而另外两款则超过了34%。

这些发现暴露了一些问题,即现有的神经网络如何通过在庞大的数据集中寻找模式来学习并执行计算任务,又是如何进行训练和评估的。例如,美国某家大型科技公司的研究人员宣称他们设计的脸部识别系统的准确率超过97%。但用于评估其表现的数据集中,男性比例超过77%,白人超过83%。

“这里真正重要的是方法以及该方法如何应用于其他应用程序,”麻省理工学院媒体实验室公民媒体小组的研究员,论文的第一作者Joy Buolamwini说。“这种以数据为中心的技术,既可以用来确认性别也可能会用于对特定人的识别,比如解锁手机或寻找犯罪嫌疑人。这不仅仅是计算机视觉。我真心希望这可以刺激更多的工作去考虑其他方面的偏见。“

Buolamwini加入了Timnit Gebru的论文,他在斯坦福大学完成研究生并且现在是微软研究院的博士后。

发现的原因

Buolamwini和Gebru调查的三个项目是通用面部分析系统,可以用来匹配不同照片中的人脸,以及评估性别、年龄和情绪等特征。所有三个系统都将性别分类视为二元决策(即男性或者女性),这使得他们在这项任务上的表现特别容易进行统计评估。而同种类型的偏见可能会影响程序在其他任务上的表现。

Buolamwini因为一个偶然的机会,发现了面部追踪的明显偏见,最终促使她进行了的调查。

几年前,作为媒体实验室的研究生,Buolamwini正在研究一种名为Upbeat Walls的系统,这是一种交互式多媒体艺术装置,用户可以通过移动头部来控制投射在白板上的彩色图案。而为了追踪用户的动作,这个系统使用了商业面部分析程序。

Buolamwini为这个项目组成的团队,各种肤色都有,但研究人员发现,在向公众展示该设备的时候,他们只能让肤色较浅的成员来展示它。这个系统似乎并不适用于黑皮肤的用户。

出于好奇,身为黑人的Buolamwini将自己的照片提交给商业面部识别项目。在某些情况下,程序无法从照片中识别出人脸特征。并且在这种情况下,还会将Buolamwini的性别错误归类。

定量标准

为了开始系统地调查这些程序的偏见,Buolamwini首先汇集了一组图像,其中女性和黑皮肤的人的比例,比面部分析系统评估的数据集要平衡很多。数据集包含超过1200个图像。

接下来,她与皮肤科外科医生合作,根据皮肤色调的菲氏量表(Fitzpatrick)编码图像,从浅到深分为六级。然后,她将她新构建的数据集输入上述三个分析系统。在这三个系统中,女性的性别分类错误率始终高于男性,而深色皮肤的错误率比浅色皮肤的错误率更高。

颜色较深的女性(菲氏量表末尾的三级),错误率分别为20.8%,34.5%和34.7。有两个系统中,数据集中最黑皮肤女性的错误率(分数为VI)甚至为:46.5%和46.8%。从本质上来说,对于这些女性来说,系统可能是在随机猜测性别!

Buolamwini说:“在一个商业系统中,到二元分类任务竟然有三分之一的错误率。你必须问,如果这些失败率是在不同的群体中,是否能被容忍?”Buolamwini说。“另外一个重要的问题在于我们的标准。我们衡量成功的标准本身就可能给我们一种错觉。”

“这个领域数据集对模型影响很大,”IBM的沃森人工智能系统首席架构师Ruchir Puri表示。“我们现在有了一个新的模型,它的准确性更加平衡。而且我们研发了一个不同的底层神经网络,这个网络更强大。”

“我们需要花些时间来做这些事情,”他补充道。“我们一直在研究这个,已经用了接近九个月的时间。这个模型并不是对她的论文的回应,而是我们自己解决了她直接提出的问题。她提出了一些非常重要的观点,我们应该看看我们的新工作是如何经得起考验的。

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消