深度学习研究:微软认知转移神经元(CSN)技术,创建适应性元学习模型

2018年05月22日 由 浅浅 发表

803145

0

适应性是将我们定义为人类的关键认知能力之一。即使我们没有事先对婴儿进行训练,也可以在相似的任务之间直观地切换。与大多数人工智能系统的传统训练和测试方法对比,无需在掌握特定任务之前通过大量训练。根据定义,训练和测试系统不具有很强的适应性,因此它们不适用于在真实环境中运行。提高人工智能系统的适应性一直是越来越受欢迎的核心研究领域之一,这被称为元学习,其重点在于提高智能体的学习能力。

在神经科学文献中,认知灵活性或适应性通常归功于大脑前额叶皮层(PFC)和工作记忆。神经科学证据表明,这些领域使用传入的信息来支持任务特定的时间进行适应和计划。最近,来自蒙特利尔微软人工智能实验室的研究人员发表了一篇研究论文,在一种被称为认知转移神经元(CSN)的新技术中,模仿这些神经科学原理。

正如其名所示,CSN根据来自连接权值调制的神经元输入产生激活值。此外,他们有能力根据辅助调节信息即时调整激活值。这些有条件的转变使模型行为适应当前的任务。将CSN视为一种元学习模式,可以利用先前知识的特点来学习新知识,而无需接受充分的训练。

CSN如何工作?

从概念上讲,CSN模型存储的移位向量对应于显示的类标签,并将它们与相应的输入表征相对应。然后该模型使用建立的不可见的表征形式来查看内存中与之最相似的表征键相对应的标签移位。根据任务和记忆的内容,附加的条件转换可以随时启动或停用神经元。在分析任何数据集时,CSN与先前知识的相似向量相关联,以提高其学习能力。

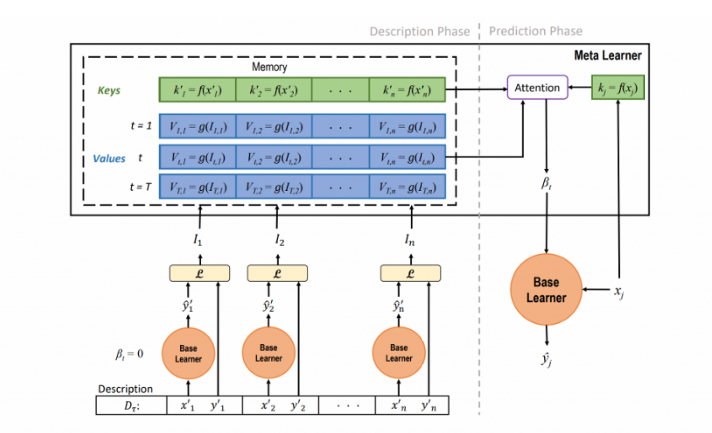

在架构上,CSN由两个主要部分组成:基础学习者和元学习者。基础学习者是对数据进行预测的神经模型,其节点通过条件变化进行修改。元学习者从基础学习者中提取信息,计算条件转换值,并将它们存储在存储器中供基础学习者稍后使用,以使其适应新的任务。

就执行模式而言,CSN可以分为两个主要阶段:描述阶段和预测阶段。为了理解CSN的这个概念,让我们将初始数据集设想为可以从中抽样的相关任务的分布,并且每个任务都带有描述。最简单的情况下,描述是一组示例数据点和他们相应的分类标签。在描述阶段,模型处理任务描述并尝试正确分类其数据点。根据其性能,它会提取相应的调节信息,用于生成激活位移以适应所描述的任务,然后将这些信息存储在键值内存模块中。

经过描述阶段之后,模型进入预测阶段。在那个页面中,CSN模型根据来自同一任务的不可见的数据点来预测他们的类标签。为了改善这些预测,该模型使用软注意机制从内存中检索变化,并将其应用于单个神经元的激活。下图说明了这个概念:

应用CSN

微软研究团队测试了多种视觉和语言人工智能场景下的CSN,如少量图像分类,少量语言建模或着名的ablation study。结果表明CSNs模型比传统的元学习算法更灵活,同时保持计算上的可比性。

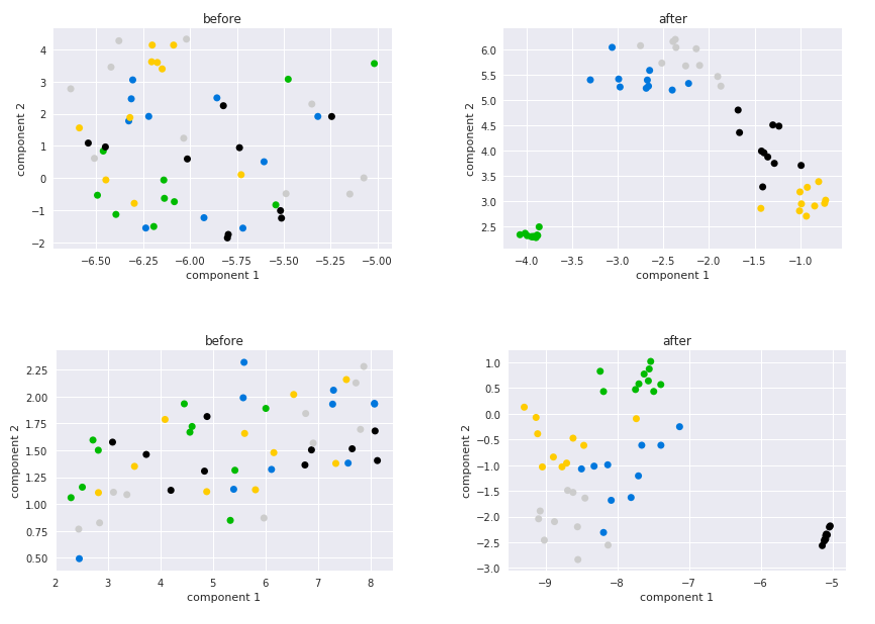

在阅读研究报告后,有一张图清楚地显示了CSN与其他模型相比之下的表现。下图显示了一个图像分类模型,用于比较应用任务特定移位之前和之后的神经元激活。CSN模型创建了更接近的神经元集群,这通常是强大学习能力的标志。

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消