研究人员开发新型AI系统,转移技术能以假乱真

2018年08月17日 由 浅浅 发表

912730

0

有没有听说过“deepfakes”?用AI生成的视频会将一个人的脸部叠加到另一个人的身体上,这些视频已被用于无数电影剪辑中,以及更具恶意的目的,如假名人宣传。现在,无论好坏,卡内基梅隆大学的研究人员开发出了一种比以前的尝试更强大,更为通用的新AI系统。

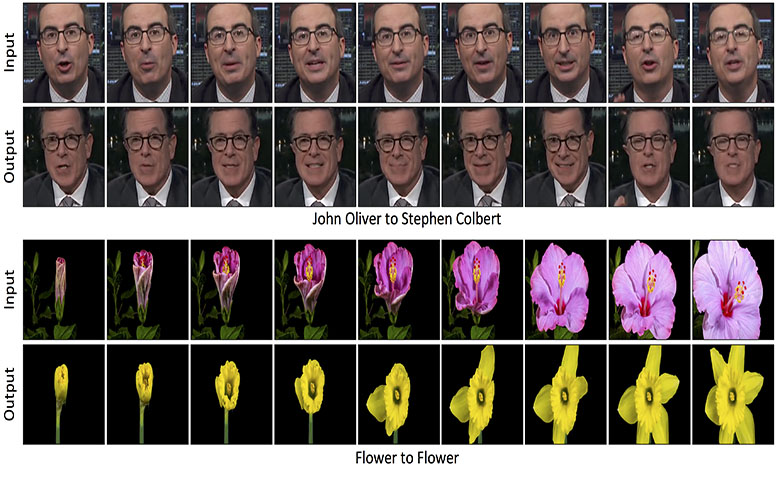

它被称为“Recycle-GAN”,团队将其描述为“无监督的,数据驱动的方法”,用于将一个视频或照片的内容传递到另一个视频或照片。“这样的内容翻译和风格保存任务有很多应用,包括人体运动和面部翻译,用人类演示教授机器人,或者将黑白视频转换为彩色。”

到目前为止,大多数最先进的转移技术都针对人脸,研究人员称这些技术“缺乏对其他领域的概括”和“应用于遮挡面部时失败”。其他则依赖于配对的图像到图像的翻译,这需要手动进行数据标记和对齐。

相比之下,Recycle-GAN利用条件生成对抗网络(GAN)和“时空线索”来学习两个图片或视频之间的关联。(GAN是由两部分模型组成的,它通过从输入数据中产生越来越逼真的输出来试图“欺骗”鉴别器。)当训练人类主体的镜头时,它能够生成捕捉微妙表情的视频,比如微笑时形成的酒窝和面部表情的动态。

团队表示,“在没有任何人工监督和特定领域知识的情况下,我们的方法通过网络上公开可用的视频数据,从一个领域到另一个领域进行重新定位。”

Recycle-GAN不仅可以捕捉面部动态。研究人员使用它来修改视频中的天气状况,将无风的日子转变为刮风的日子。他们对着鲜花和垂死的花朵进行了对齐,他们通过网络上的视频合成了可以以假乱真的日出。

[video width="640" height="360" mp4="https://www.atyun.com/uploadfile/2018/08/flower-to-flower-via-Recycle-GAN.mp4"][/video]

结果非常好,可以以28.3%的几率欺骗15名测试对象,但团队认为,如果他们学会了“生成输出”的速度,就像人们说话的不同速度一样,系统的未来可以更加准确。

“真正的风格概念应该能够产生甚至是传递语音/内容所需的时间变化,我们相信更好的时空神经网络架构可以在不久的将来解决这个问题。”

不出所料,deepfakes仍然是一个热门话题。公开可用的工具使它们相对容易创建,并且对于恶意AI生成的视频的受害者没有法律追索权。

Reddit,Pornhub,Twitter和其他平台采取了反对他们的立场,研究人员继续寻找检测deepfakes的方法。

更多图像识别数据集点击“这里”下载

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消