谷歌推出开源强化学习框架Dopamine

2018年08月28日 由 浅浅 发表

885047

0

强化学习研究在过去几年取得了许多重大进展。这些进步使得智能体以超越人类的级别玩游戏,值得注意的例子包括DeepMind的DQN玩Atari游戏,AlphaGo,AlphaGo Zero,以及Open AI Five。具体而言,在DQN中引入重播记忆,智能体可以利用以前的经验,大规模分布式训练,实现跨多个工作分配学习过程,以及分配方法允许智能体模拟完整的分布,而不仅仅是他们的期望值,以便更全面地了解它们所处的情况。这种类型的进展很重要,因为产生这些进步的算法还适用于其他领域,例如机器人技术。

通常,开发这些进步需要快速迭代设计(通常没有明确的方向),打破既定方法的结构。然而,大多数现有的RL框架不具有灵活性和稳定性,研究人员不能有效地迭代RL方法,从而探索新研究方向可能没有直接而明显的收益。此外,从现有框架再现结果通常太耗时,这可能导致科学的再现性问题。

今天,谷歌推出了一个新的基于Tensorflow的框架,旨在为新的和经验丰富的RL研究人员提供灵活性,稳定性和可重复的工具。这一平台的灵感来自于大脑中奖赏动机行为的一个主要组成部分,反映了神经科学与强化学习研究之间的强烈联系,该平台旨在推动一种能够推动重大发现的投机性研究。此版本还包括一组阐明如何使用框架的colabs:github.com/google/dopamine/blob/master/dopamine/colab/README.md

易用性

清晰度和简洁性是设计该框架的两个关键因素。谷歌提供的代码是紧凑的(大约15个Python文件),并且有详细记录。这是通过专注于街机学习环境(一个成熟的,易于理解的基准)和四个基于价值的智能体来实现的:DQN,C51,一个精心策划的Rainbow代理的简化版本,以及Implicit Quantile Network智能体(上个月刚在国际机器学习会议上发布)。这种简单性使研究人员能够轻松了解智能体的内部运作并快速尝试新的想法。

再现性

再生性在强化学习研究中非常重要。为此,谷歌为代码提供完整的测试,这些测试在文档附表里。此外,我们的实验框架遵循Machado等人给出的建议,将经验评估与街机学习环境标准化。

基准测试

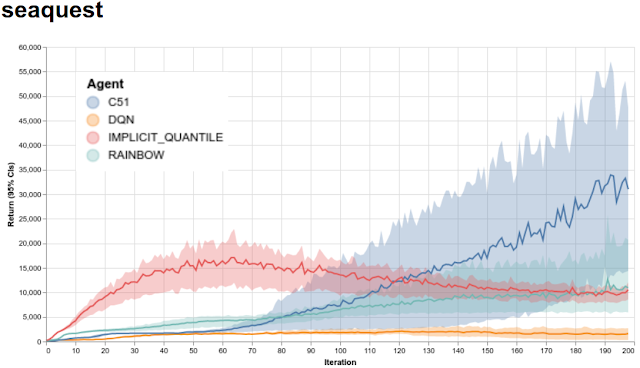

对于新的研究人员而言,能够根据既定方法快速对其思想进行基准测试非常重要。因此,谷歌谷歌提供四个提供的代理的完整训练数据,包括Arcade学习环境支持的60个游戏,可用作Python pickle文件(用于使用谷歌框架训练的智能体)和JSON数据文件(与受过其他框架训练的智能体进行比较);谷歌另外提供一个网站(google.github.io/dopamine/baselines/plots.html),可以快速查看所有60场比赛中所有提供的智能体的训练运行。下面展示的是在Seaquest上的4个智能体的训练,这是由Arcade学习环境支持的Atari 2600游戏之一。

4个智能体在Seaquest中训练。x轴代表迭代,每个迭代都有100万个游戏帧(4个半小时的实时游戏);y轴是每个游戏获得的平均分数。阴影部分显示了5个独立运行的置信区间。

谷歌还提供利用这些智能体训练的深度网络,原始统计日志以及用于Tensorboard可视化的Tensorflow事件文件:google.github.io/dopamine/baselines/plots.html

谷歌希望其框架的灵活性和易用性将使研究人员能够尝试新的想法。谷歌已经积极地将它用于研究,并发现它能够快速迭代许多想法,灵活性高。

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消