谷歌赞同“数据为王”并且拥有比原来100倍的数据量!

2017年07月13日 由 nanan 发表

110167

0

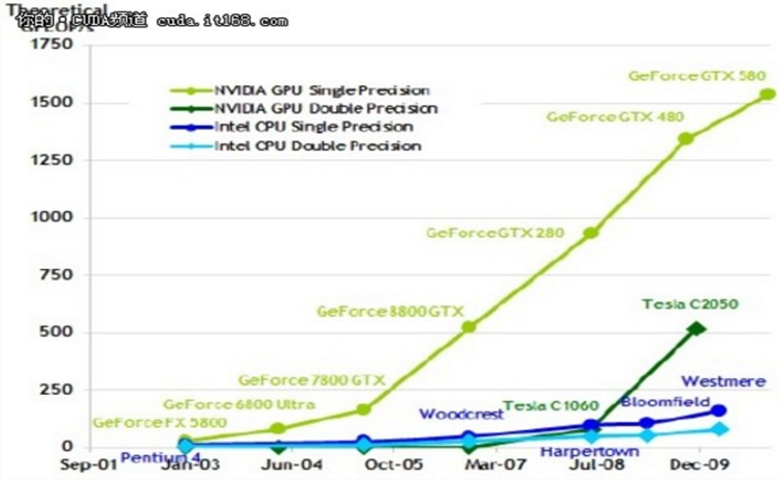

在过去将近十年的时间里,研究人员在计算机视觉领域取得了巨大的成功,而深度学习在其中有着至关重要的作用。但自从2012年以来,深度学习的计算能力的提升、可用标记数据的增加和复杂程度的不断提高,导致系统的能力也在不断的提高。不过,从这三方面来看,可用标记数据的发展速度并没有跟上其计算能力和复杂程度的提高速度。为此,相关人员一直有个想法,如果是将训练的数据扩大10倍、100倍甚至500倍,那么准确率会提升吗?到时会是什么样的一个结果?是否可以有更多的突破?

在论文《重新审视深度学习时代数据的非理性效果》中,研究人员所追寻的目标是:

(1)在计算机视觉的应用中,大规模学习技术是否被应用到了可以应对一切问题的模型中?

(2)如果不断地给现有算法添加图片,那么其现有能力是否会得到提高呢?

(3)在类似图像检测和分割图片等的相关应用中,那么其本质是什么呢?

在相关人员考虑以上的问题的同时,先要考虑去哪找这个比 ImageNet 大 300 倍的数据集。其实,谷歌一直在致力于完成这样的一个数据集。真要说起来的话,谷歌的数据集 JFT-300M 已经有 3 亿张图片,它们被分为 18291 个大类,并且用到了网络信号、用户反馈等一系列的信息。

从3亿张图片中所添加的标签就有10亿之多,而被精短算法选出的大约只有3.75亿而已,尽管如此,但在这些标签中还是存在着噪声。数据初步显示,被选出的标签图片差不多有20%都是噪声,但研究人员还是无法确定是否将这些图片取消。

研究人员对其进行了一番论证实验,还是得出了意想不到的结果:

- 性能会随着训练数据数量级实现线性增长:实验表明它们之间居然存在异常线性的关系,即使图片多达3亿张,但是还是没有起到相应的效果。

- 容量非常重要:研究人员还在试验中发现,若要充分的利用这个数据集,那么所需要的容量必须要足够大才可以。

- 更好的表征学习辅助效果:研究人员做的实验显示,大规模数据集的使用能提升学习的效果,反过来还提高了视觉任务的表现,不仅如此,实验还显示出无监督和半监督表征学习前途无量。

- 新成果:研究人员在此次试验中还发现了很多的新成果,例如单个模型已经可以达到 37.4AP,但在此前确实达不到的。

值得我们注意的是,在试验中所用的学习制度、学习计划和参数设置都是在对 ConvNets 训练的理解的基础上而设定的。但在工作当中,还是没有用到最优的数据模型,所以得到的结果可能还不是最好的。而研究人员相信,未来获取的特定数据将会成为研究的核心,虽然此次实验并没有把将精力集中在特定任务上。

除此之外,谷歌所搭建的那个数据集并不是终极目标,而随着技术的发展,将会变得越来越好。

(论文地址:https://arxiv.org/abs/1707.02968)

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消