MIT新AI模型揭开黑匣子:使用透明的、类似人类的推理解决问题

2018年09月12日 由 浅浅 发表

168400

0

如果向孩子呈现各种形状的图片,并要求他们找到大的红色圆圈,为了得出答案,可能经历几个推理步骤:首先,找到所有大的东西;接下来,找到大的红色的形状;最后,挑选出一个的大的红色圆圈。

我们通过理性学习如何解读世界。那么,神经网络也是如此。现在,麻省理工学院林肯实验室的情报和决策技术小组的一个研究团队开发了一个神经网络,它可以执行类似人类的推理步骤来回答有关图像内容的问题。该模型被命名为Transparency by Design Network(TbD-net),在解决问题时可视化地呈现其思维过程,使人类分析师能够解释其决策过程。该模型比当今最好的视觉推理神经网络表现更好。

了解神经网络如何做出决策一直是AI研究人员长期面临的挑战。正如他们的名字的神经部分所暗示的那样,神经网络是大脑启发的AI系统,旨在复制人类学习的方式。它们由输入和输出层以及介于两者之间的层组成,将输入转换为正确的输出。一些深度神经网络变得如此复杂,以至于几乎不可能遵循这种转换过程。这就是为什么它们被称为“黑匣子”系统,它们在不透明的内部甚至是建造它们的工程师。

使用TbD-net,开发人员的目标是使这些内部工作透明化。透明度很重要,因为它允许人类解释AI的结果。

重要的是要知道,例如,在自动驾驶汽车中使用的神经网络究竟是什么认为行人和停车标志之间存在差异,并且在其推理链的哪一点上看到了这种差异。这些见解允许研究人员教导神经网络纠正任何不正确的假设。但TbD-net开发人员表示,目前最好的神经网络缺乏一种有效的机制,使人们能够理解他们的推理过程。

“提高视觉推理性能的进展是以可解释性为代价的,”Ryan Soklaski说道,他与研究员Arjun Majumdar,David Mascharka和Philip Tran建立了TbD-net。

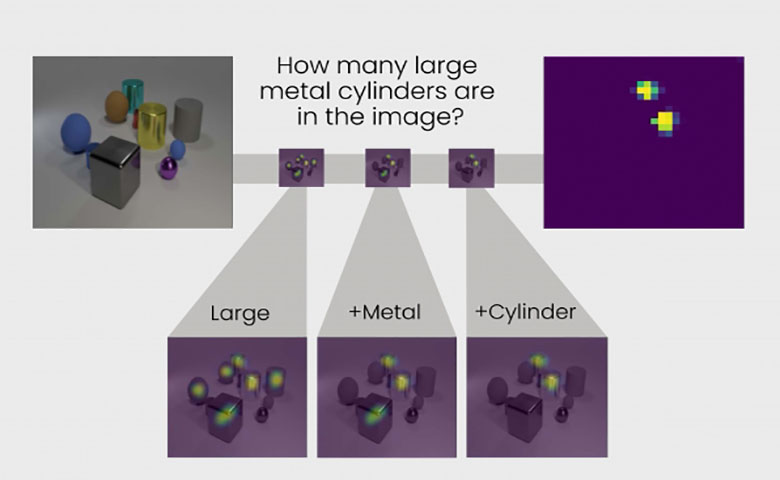

林肯实验室小组能够缩小与TbD-net的性能和可解释性之间的差距。他们系统的一个关键是“模块”的集合,这些小型神经网络专门用于执行特定的子任务。当TbD-net被问到关于图像的视觉推理问题时,它将问题分解为子任务并分配适当的模块以实现其部分。就像装配线上的工人一样,每个模块都会在模块出现之前构建出最终产生最终正确答案的模块。总的来说,TbD-net利用一种AI技术来解释人类语言问题,并将这些句子分解为子任务,然后是多种解释图像的计算机视觉AI技术。

Majumdar说:“将一系列复杂的推理分解为一系列较小的子问题,每个子问题都可以独立解决并组成,是一种强大而直观的推理手段。”

每个模块的输出在视觉上以组称为“注意掩码”的方式描绘。注意掩码显示模块识别为其答案的图像中的对象上的热图。这些可视化使人类分析师能够看到模块如何解释图像。

举例来说,对TbD-net提出以下问题:“在这张图片中,大型金属立方体是什么颜色?”为了回答这个问题,第一个模块仅定位大对象,产生一个注意掩码,突出显示那些大对象下一个模块接受这个输出并找出前一个模块中识别为大的那些对象中的哪一个也是金属的。该模块的输出被发送到下一个模块,该模块识别哪些大金属对象也是一个立方体。最后,这个输出被发送到一个可以确定对象颜色的模块。TbD-net的最终输出是“红色”,这是问题的正确答案。

经过测试,TbD-net取得的成绩超过了性能最佳的视觉推理模型。研究人员使用视觉问答数据集评估了该模型,该数据集包括70000个训练图像和700000个问题,以及15000个图像和150000个问题的测试和验证集。初始模型在数据集上实现了98.7%的测试精度,据研究人员称,这远远优于其他神经模块网络方法。

重要的是,研究人员能够改善这些结果,因为他们的模型的关键优势,即透明度。通过查看模块产生的注意掩码,他们可以看到出现问题的地方并改进模型。最终结果是最先进的99.1%准确度。

“我们的模型在视觉推理过程的每个阶段都提供了直观,可解释的输出,”Mascharka说。

如果要将深度学习算法与人类一起部署以帮助解决复杂的现实世界任务,那么可解释性尤其有用。为了在这些系统中建立信任,用户需要能够检查推理过程,以便他们能够理解模型为何以及如何做出错误的预测。

智能与决策技术集团的负责人Paul Metzger表示,这项研究“是林肯实验室致力于成为应用机器学习研究和AI的世界领导者,促进人机协作的一部分。”

论文:arxiv.org/abs/1803.05268

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消