谷歌翻译区分性别,进一步减少AI偏见

2018年12月07日 由 浅浅 发表

34018

0

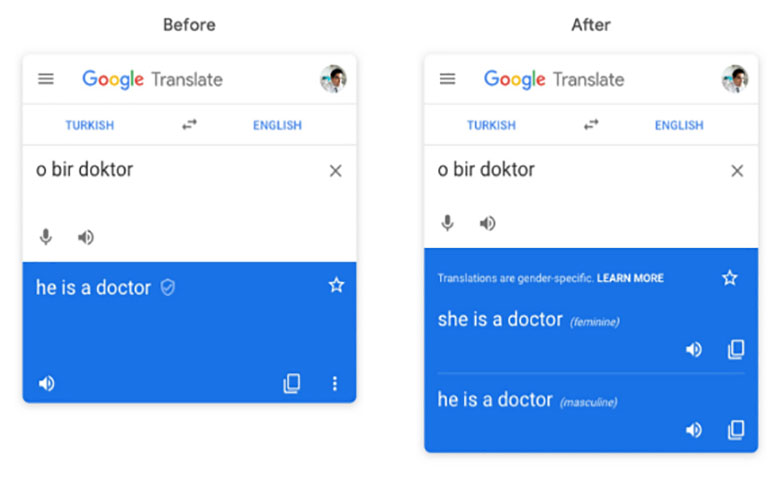

谷歌正在努力减少翻译中的性别偏见,从本周开始,用户获得的翻译将女性和男性区分开来,例如,土耳其语中的“o bir doktor”翻译成英语,会分为“她是医生”和“他是医生”。

谷歌正在努力减少翻译中的性别偏见,从本周开始,用户获得的翻译将女性和男性区分开来,例如,土耳其语中的“o bir doktor”翻译成英语,会分为“她是医生”和“他是医生”。目前,这一区分支持从英语到法语,意大利语,土耳其语,葡萄牙语或西班牙语的翻译。

谷歌翻译产品经理James Kuczmarski表示,团队已经开始解决非二元性别翻译问题。

他指出,“谷歌一直在努力促进公平,减少机器学习的偏见,将来,我们计划将性别特定的翻译扩展到更多语言,在我们的iOS和Android应用程序等其他翻译界面上发布,并解决查询自动完成等功能中的性别偏见。”

这一消息发布前不久,谷歌停用了Smart Compose,这是一种Gmail功能,可以在建议基于性别的代词时自动为用户提供句子。

在此之前,社交媒体上发布了一些据称显示自动翻译应用程序存在性别偏见的帖子。用户注意到某些外语中的“工程师”和“强者”等词语更可能与英语中相应的男性词汇相关联。如谷歌将“o bir muhendis”翻译为“他是工程师”,而“o bir hemsire”翻译为“她是一名护士”。

Kuczmarski解释说,这是AI训练的问题。词嵌入不可避免地拾取并放大源文本和对话中隐含的偏差。一个2016年的研究发现,在谷歌新闻文章字嵌入物往往表现出男性和女性的性别定势观念。

Kuczmarski表示:“谷歌翻译从网上已有数亿个已翻译的例子中学习。从历史上看,它只为查询提供了一种翻译,即使翻译可能具有女性化或男性化形式。”

因此,当模型产生一个翻译时,它无意中复制了已经存在的性别偏见。例如,像“强壮”或“医生”这样的词语,它会偏向男性化,对于其他词语,如“护士”或“美丽”,它会倾向于女性化。

性别中立的语言翻译方法是谷歌为减轻AI系统偏见而做出的努力。谷歌一直在用其AI道德团队开发的测试来发现偏见,禁止咒骂,种族歧视等言论。

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消