MIT与IBM开发新的集体学习策略,加快智能体学习速度

2019年02月02日 由 浅浅 发表

455195

0

第一个打败世界上最优秀棋手的AI,至少得到了人类的一些指导,而它们无法与完全靠自己、通过反复试验和错误学习的新一代AI匹敌。

第一个打败世界上最优秀棋手的AI,至少得到了人类的一些指导,而它们无法与完全靠自己、通过反复试验和错误学习的新一代AI匹敌。深度学习和强化学习算法的结合,使得计算机在诸如国际象棋和围棋,包括Ms. Pac-Man在内的越来越多的视频游戏以及扑克等纸牌游戏中占据主导地位。

尽管取得了这么多进展,但随着游戏与现实生活越来越接近,电脑仍会陷入困境,而游戏中隐藏着信息、多名玩家组合、持续不断的游戏以及短期和长期奖励,这一切都让计算变得极其复杂。

为了克服这些障碍,AI研究人员正在探索辅助技术,以帮助机器人智能体学习,不仅模仿人类自身,而且从周围的人,报纸,书籍和其他媒体获取新信息。

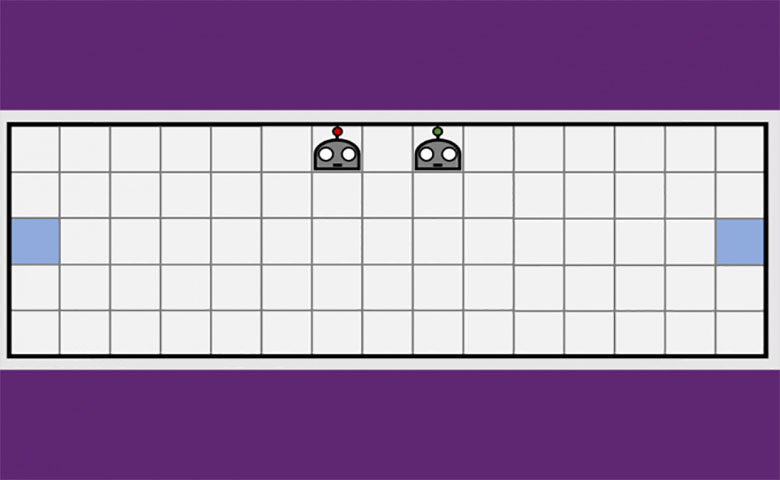

由MIT-IBM Watson AI Lab开发的集体学习策略提供了一个有前途的新方向。研究人员表明,当智能体学会利用彼此不断增长的知识体系时,一对智能体可以将学习简单导航任务所需的时间缩短50%,甚至更多。

该算法教会智能体何时寻求帮助,以及如何根据此前学到的内容调整自己的建议。该算法的独特之处在于,两种智能体都不是专家,每个人都可以自由地作为学生或教师来请求和提供更多信息。研究人员将于本周在夏威夷AAAI人工智能会议上展示该成果。

加拿大皇家银行研究部门Borealis AI的研究主管Matthew E. Taylor认为,“用提供行动来改善学生的学习,而不仅仅是告诉学生该做什么,这可能非常强大。虽然论文中的描述侧重于相对简单的场景,但我相信学生-教师框架可以在Dota 2,机器人足球或灾难救援中发挥作用。”

目前,职业玩家仍然在Dota2以及其他支持团队合作和快速战略思考的游戏方面具有优势(虽然DeepMind最近在实时战略游戏“星际争霸”中击败了职业玩家),但随着机器对动态环境的操控能力的提高,它们可能很快就能完成现实世界中的任务,比如管理大城市的交通,或协调地面和空中的搜救队伍。

机器缺乏常识性知识,它们需要观看数百万个视频帧,并花费大量的计算时间,学会很好地玩游戏。即便如此,它们缺乏有效的方式将它们的知识转移到团队中,或将它们的技能迁移到新游戏。如果可以训练机器人向他人学习,并将他们的学习推广到其他任务,我们就可以开始更好地协调彼此之间以及与人类的互动。

团队的关键洞见是,在这种情况下,一个团队通过各个击破的方法来学习一项新任务会学得更快,比如在一个房间的两端进行操作,同时触碰墙壁。

他们的教算法在两个阶段之间交替:首先,学生和老师在每一步都要基于他们对下一步的信心,或者他们即将给出的建议,来决定是要求还是给出建议,这会让他们离目标更近。因此,学生只会寻求建议,老师只会在增加的信息有可能提高他们的表现时才给出建议。在每一步中,智能体都更新各自的任务策略,流程将继续,直到达到目标或超时为止。

通过每次迭代,算法记录学生的决定,教师的建议以及通过游戏的最终得分衡量的学习进度。在第二阶段,深度强化学习技术使用先前记录的教学数据来更新建议策略。每次更新都会让教师更好地在合适的时间提供正确的建议。

在 AAAI研讨会上讨论的后续论文中,研究人员改进了算法跟踪智能体学习基本任务的能力的能力,他们用的是一个推箱子的任务提高智能体给出和接受建议的能力。这使该团队朝着进入机器人世界杯RoboCup的长期目标又迈进了一步,即AI学术研究人员发起的年度机器人竞赛。

IBM研究人员Tesauro表示,“在我们进行足球比赛之前,我们需要扩展到11名智能体,这将需要更多的工作,但我们充满希望。”

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消