对抗性攻击研究:图片中可被操纵的细微特征会欺骗AI

2019年05月15日 由 深深深海 发表

399765

0

对抗性攻击对于AI来说可能是致命的,最近研究发现,在停车标志上放置一个贴纸实际上可以欺骗AI,使其对标志进行错误分类,这可能会导致自动驾驶汽车不会停下。

对抗性攻击对于AI来说可能是致命的,最近研究发现,在停车标志上放置一个贴纸实际上可以欺骗AI,使其对标志进行错误分类,这可能会导致自动驾驶汽车不会停下。因此AI需要找到一种方法来进行防御。上周,MIT研究人员在“学习表征国际会议”上发表报告称,他们发现了一种赋予人工智能防御优势的新方法。

这项工作不仅可以保护公众。计算机科学家Zico Kolter说,这也有助于揭示为什么人工智能最先成为此类攻击的受害者。研究表明,由于一些人工智能过于聪明,因此发现人类无法识别的图像模式,它们很容易受到这些模式的影响,所以需要针对这一点接受训练。

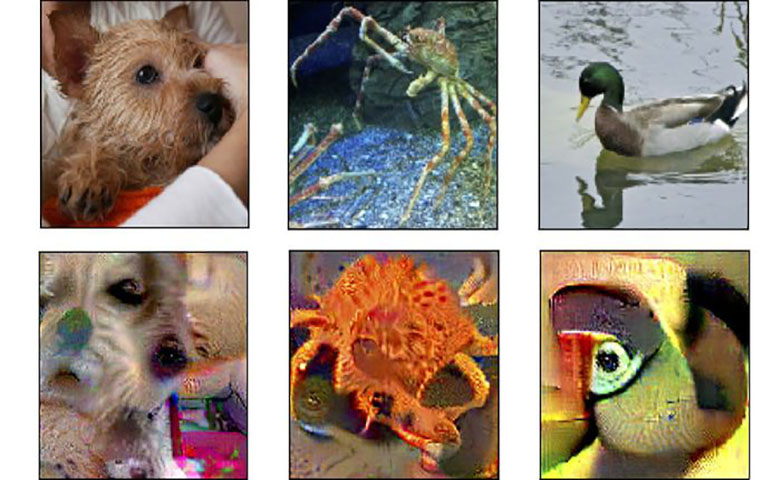

为了识别这个漏洞,研究人员创建了一组特殊的训练数据:在我们和机器眼里完全不同的图像,例如,狗的图片经过计算机的仔细检查有猫的毛皮。然后,团队错误地标记了图片,将狗的图片标记为猫,并训练算法来学习。

一旦人工智能学会将具有猫的细微特征的狗视为猫,他们就会让狗识别新鲜的、未经修改的图像,从而对其进行测试。尽管人工智能是以这种奇怪的方式训练的,但它几乎有一半的时间能正确识别真实的狗、猫等。从本质上讲,无论明显的特征是什么,它都学会了将精妙的特征与标记相匹配。

训练实验表明AI使用两种类型的特征:明显的,宏观的,如人们可以识别的耳朵和尾巴,以及我们只能猜测的微观特征。

这进一步表明,对抗性攻击不仅仅是将人工智能与无意义的图像调整混为一谈。在这些调整中,人工智能看到了其他东西的痕迹。例如,人工智能可能会将停车标志视为限速标志,因为贴纸上的某些东西实际上使它微妙地类似于限速标志,而人类对此却一无所知。

有一篇研究论文证明了这一点是件好事。将明显特征与隐藏特征区分开来是一个有用的研究方向,但要有效地做到这一点,还有很长的路要走。

那么现在研究人员已经更清楚地知道为什么AI犯了这样的错误,那么这可以用来帮助它们超越对抗性攻击吗?麻省理工学院计算机科学家Andrew Ilyas是该论文的作者之一,他说工程师可以改变他们训练人工智能的方式。

目前保护算法免受攻击的方法是缓慢而困难的。但是,如果修改训练数据,使其只具有明显的人类特征,那么任何在此基础上训练的算法都不会识别,并可能被附加的特征所欺骗。

实际上,研究人员在一份报道中表示,当团队训练一个没有微妙特征的图像算法时,他们的图像识别软件只有50%的概率被对抗性攻击所欺骗。相比之下,当AI在具有明显和微妙模式的图像上进行训练时,概率为95%。

总体而言,研究结果表明AI的漏洞存在于其训练数据中,而不是其编程。

论文:

arxiv.org/abs/1905.02175

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消