基于慢速脑动力,新型超速人工智能算法的学习效率超过现有算法

2019年08月12日 由 深深深海 发表

132232

0

70年前引入的机器学习基于大脑学习动力学。利用现代计算机和大型数据集的速度,深度学习算法产生的结果可在不同领域与人类专家相媲美,但具有与当前神经科学学习知识相悖的不同特征。

70年前引入的机器学习基于大脑学习动力学。利用现代计算机和大型数据集的速度,深度学习算法产生的结果可在不同领域与人类专家相媲美,但具有与当前神经科学学习知识相悖的不同特征。以色列巴伊兰大学的科学家利用神经元的文化和大规模模拟进行实验,展示了一种新型的超速人工智能算法,基于非常缓慢的脑动力,它的学习效率超过了目前最先进的学习算法。

脑动力学

在Scientific Reports上的一篇文章中,研究人员重建了神经科学和先进人工智能算法之间的桥梁,而这些算法在近70年来几乎毫无用处。

“目前的科学和技术观点是,神经生物学和机器学习是两个独立发展的学科,”该研究的主要作者,巴伊兰大学物理系和Gonda多学科脑研究中心的Ido Kanter教授说,“缺乏预期的相互影响令人费解。”

大脑中的神经元数量比现代个人电脑典型磁盘大小的比特数还少,大脑的计算速度就像时钟上的秒针,甚至比70多年前发明的第一台电脑还要慢。此外,大脑的学习规则非常复杂,远离当前人工智能算法学习步骤的原则。

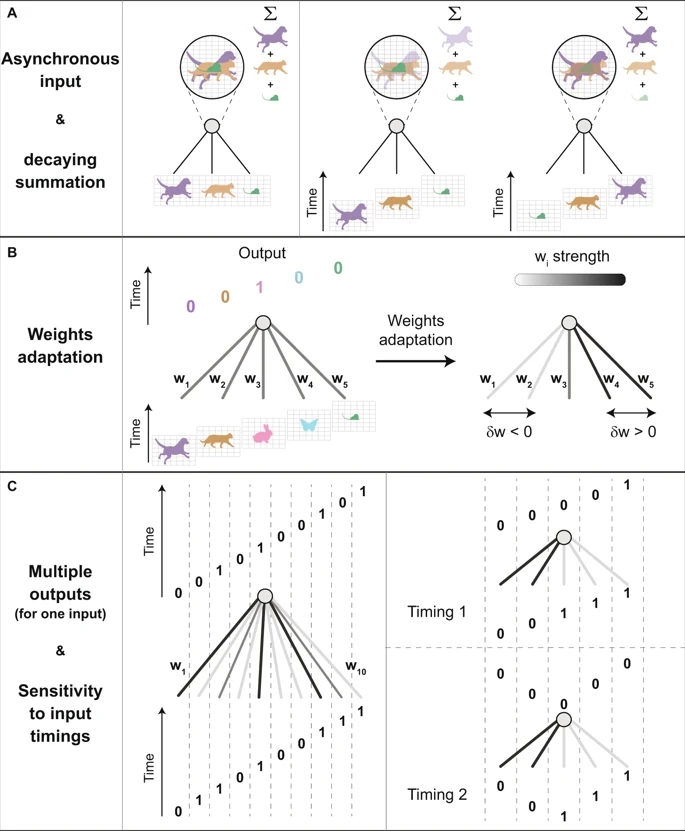

脑动力学不符合为所有神经细胞同步的明确定义的时钟,因为随着物理现实的发展,生物学方案必须应对异步输入。

当向前看时,人们立即观察到一个有多个物体的框架。例如,当一个人开车时,他会观察汽车、人行横道和路标,并能很容易地识别它们的时间顺序和相对位置,生物硬件(学习规则)旨在处理异步输入并改进其相关信息。

当向前看时,人们立即观察到一个有多个物体的框架。例如,当一个人开车时,他会观察汽车、人行横道和路标,并能很容易地识别它们的时间顺序和相对位置,生物硬件(学习规则)旨在处理异步输入并改进其相关信息。相反,传统的人工智能算法基于同步输入,因此通常忽略构成相同帧的不同输入的相对时间。

超速学习

这项新研究表明,对于小型和大型网络而言,超速学习率惊人的相同。

因此,研究人员表示,“复杂的大脑学习方案的缺点实际上是一个优势。”

另一个重要的发现是,学习可以在没有根据异步输入的情况下,通过自适应学习步骤的情况下发生。这种类型的学习发生在树突中,如最近的实验观察到的那样。此外,树突状学习下的网络动力学受到弱权值的支配,这在以前被认为使微不足道的。

这种基于慢速的大脑动力学的高效深度学习算法,为实现基于快速计算机的新型高级人工智能提供了机会。它要求重新启动从神经生物学到人工智能的桥梁,“我们大脑基本原理的见解必须再次成为未来人工智能的核心。”

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消