OpenAI 发布 Safety Gym以进行强化学习

2019年11月22日 由 sunlei 发表

280437

0

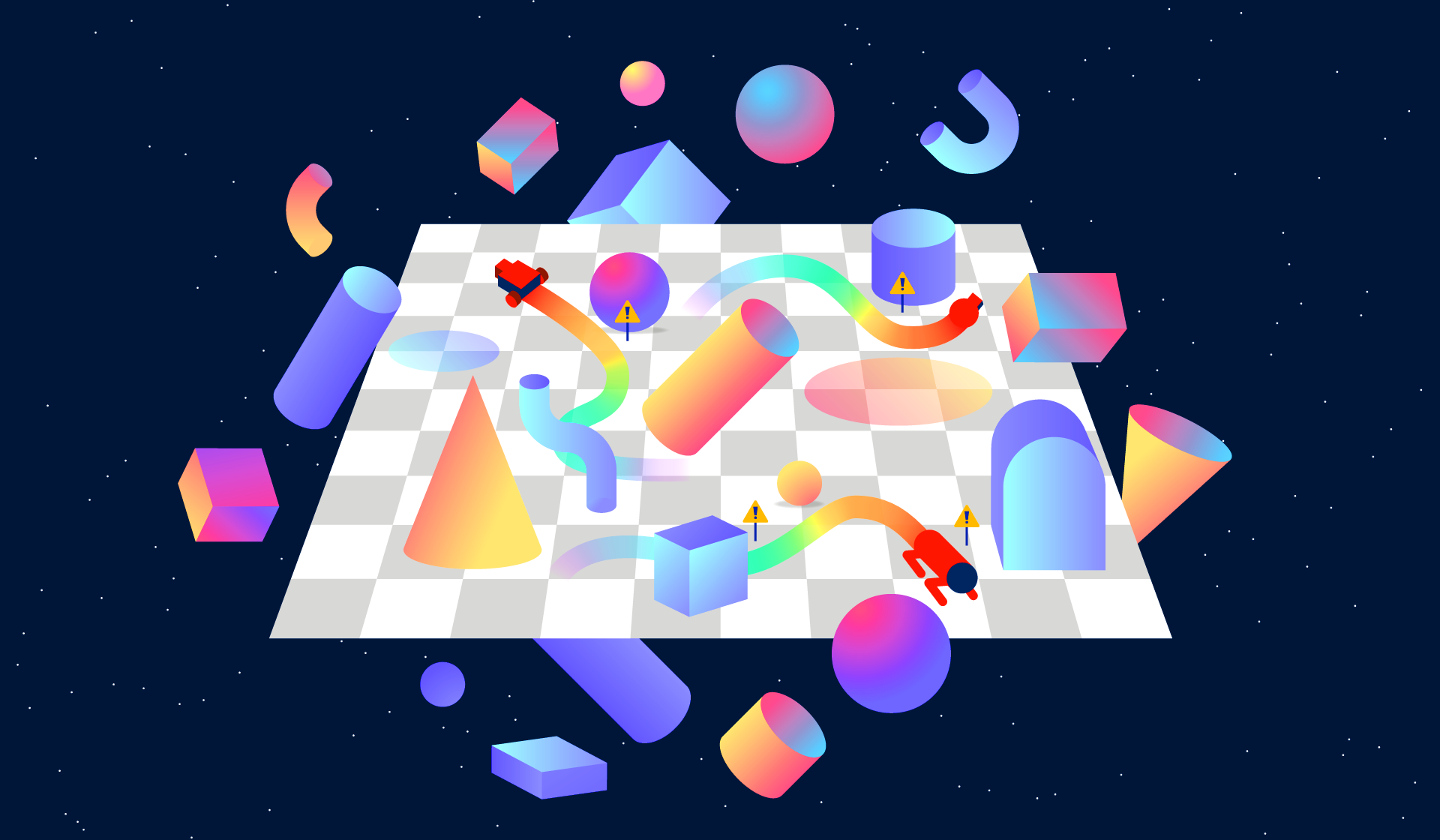

11月21日报道,OpenAI 发布 Safety Gym,用于评价智能体在强化学习训练过程中对安全约束的执行变化情况,例如自驾车如何在训练阶段学习如何避免事故发生。

迄今为止,尽管数据科学领域的许多工作都集中在算法的规模和复杂性上,但是安全(即防止伤害的保障)仍然是一个值得追求的领域。在无人驾驶汽车等应用中尤其如此,因为机器学习系统的错误判断可能会导致事故。

这就是为什么像Intel的Mobileye和Nvidia这样的公司都提出了框架来保证安全和合理的决策制定,也是为什么OpenAI(由首席技术官Greg Brockman,首席科学家Ilya Sutskever等人共同创立的旧金山研究公司)11月21日发布了Safety Gym。OpenAI将其描述为用于开发AI的工具套件,该AI在训练时遵守安全约束,并用于比较算法的“安全性”以及这些算法在学习中避免错误的程度。

Safety Gym是为强化学习代理设计的,或者是通过奖励(或惩罚)逐步刺激目标的人工智能。他们通过尝试和错误来学习,这可能是一个冒险的尝试——代理人有时会尝试导致错误的危险行为。

作为一种补救措施,OpenAI提出了一种增强学习的形式,称为约束增强学习,它实现了AI必须约束的成本函数。与通常的做法相反,代理人的行为由为实现目标而量身定制的功能来描述,而受约束的代理人则要找出实现某些确定结果的折衷方案。

OpenAI在博客中解释道:“在正常的[强化学习]中,您会在训练开始时就选择好碰撞并将其永久固定,”。“这里的问题是,如果按次计费足够高,那么座席可能就不会在意是否会遇到很多冲突(只要它仍然能够完成其行程)……[但是]在[强化学习]中,您将在训练开始时选择可接受的碰撞率,并调整碰撞精细度,直到代理满足该要求为止。”

为此,Safety Gym引入了需要AI代理(Point,Car,Doggo或自定义设计)的环境,以在混乱的环境中导航以实现目标,按钮或推动任务。难度分为两个级别,每次代理执行不安全的操作(即陷入混乱)时,红色警告灯会在座席周围闪烁,并且会产生成本。

Safety Gym除了提供用于运行实验的代码外,还提供了标准且受约束的强化学习算法,OpenAI表示,初步结果证明了Safety Gym环境中的难度范围。最简单的环境相对容易解决,并且允许快速迭代,而最困难的环境对于当前技术而言可能太具有挑战性。

OpenAI的未来工作是改善当前Safety Gym环境下的性能,使用Safety Gym研究安全的AI训练技术,并将受限的强化学习与隐性规范(如人类喜好)相结合。它还希望有助于制定可衡量AI系统安全性的指标。

OpenAI写道:“ [安全指标]可能可以集成到开发人员用来测试其系统的评估方案中,并且有可能被政府用来创建安全标准。” “我们……希望像Safety Gym这样的系统能让人工智能开发者更容易通过开放、共享的系统,就整个人工智能领域的安全进行合作。”

原文链接:https://venturebeat.com/2019/11/21/openai-safety-gym/

迄今为止,尽管数据科学领域的许多工作都集中在算法的规模和复杂性上,但是安全(即防止伤害的保障)仍然是一个值得追求的领域。在无人驾驶汽车等应用中尤其如此,因为机器学习系统的错误判断可能会导致事故。

这就是为什么像Intel的Mobileye和Nvidia这样的公司都提出了框架来保证安全和合理的决策制定,也是为什么OpenAI(由首席技术官Greg Brockman,首席科学家Ilya Sutskever等人共同创立的旧金山研究公司)11月21日发布了Safety Gym。OpenAI将其描述为用于开发AI的工具套件,该AI在训练时遵守安全约束,并用于比较算法的“安全性”以及这些算法在学习中避免错误的程度。

Safety Gym是为强化学习代理设计的,或者是通过奖励(或惩罚)逐步刺激目标的人工智能。他们通过尝试和错误来学习,这可能是一个冒险的尝试——代理人有时会尝试导致错误的危险行为。

作为一种补救措施,OpenAI提出了一种增强学习的形式,称为约束增强学习,它实现了AI必须约束的成本函数。与通常的做法相反,代理人的行为由为实现目标而量身定制的功能来描述,而受约束的代理人则要找出实现某些确定结果的折衷方案。

OpenAI在博客中解释道:“在正常的[强化学习]中,您会在训练开始时就选择好碰撞并将其永久固定,”。“这里的问题是,如果按次计费足够高,那么座席可能就不会在意是否会遇到很多冲突(只要它仍然能够完成其行程)……[但是]在[强化学习]中,您将在训练开始时选择可接受的碰撞率,并调整碰撞精细度,直到代理满足该要求为止。”

为此,Safety Gym引入了需要AI代理(Point,Car,Doggo或自定义设计)的环境,以在混乱的环境中导航以实现目标,按钮或推动任务。难度分为两个级别,每次代理执行不安全的操作(即陷入混乱)时,红色警告灯会在座席周围闪烁,并且会产生成本。

Safety Gym除了提供用于运行实验的代码外,还提供了标准且受约束的强化学习算法,OpenAI表示,初步结果证明了Safety Gym环境中的难度范围。最简单的环境相对容易解决,并且允许快速迭代,而最困难的环境对于当前技术而言可能太具有挑战性。

OpenAI的未来工作是改善当前Safety Gym环境下的性能,使用Safety Gym研究安全的AI训练技术,并将受限的强化学习与隐性规范(如人类喜好)相结合。它还希望有助于制定可衡量AI系统安全性的指标。

OpenAI写道:“ [安全指标]可能可以集成到开发人员用来测试其系统的评估方案中,并且有可能被政府用来创建安全标准。” “我们……希望像Safety Gym这样的系统能让人工智能开发者更容易通过开放、共享的系统,就整个人工智能领域的安全进行合作。”

原文链接:https://venturebeat.com/2019/11/21/openai-safety-gym/

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消