谷歌解释了Pixel 4在夜空摄影方面为何表现出色

2019年11月30日 由 KING 发表

303823

0

迄今为止,在夜间拍摄室外场景一直是大型相机(例如DSLR)才能做的事情,虽然手机摄像头的夜间拍摄技术有了一定进步,但是它还不足以让人们满意。

Google去年推出的Night Sight是Google Pixel 3的相机应用的一部分,它使摄影师可以在黑暗的环境中拍摄出漂亮的图片。而普通的相机模式会产生颗粒状污点,严重曝光不足的现像。Google在一篇博客中描述了Night Sight是如何做到这一点的,并在SIGGRAPH Asia 2019上进行了技术讨论 。

夜视的简要概述

手机相机的图像传感器检测到的光量固有地具有一些不确定性,称为“ 散粒噪声 ”,导致图像显得有颗粒感。散粒噪声的可见性随光量的增加而降低;因此,相机最好收集尽可能多的光线以产生高质量的图像。

在给定的时间内,有多少光到达图像传感器受相机镜头光圈的限制。延长照片的曝光时间会增加捕获的光线总量,但是如果曝光时间较长,则拍摄场景中的运动以及手持相机的不稳定会导致模糊。为了克服这一问题,Night Sight将曝光分为多个帧,这些帧具有较短的曝光时间和相应较少的运动模糊。首先对齐帧,以补偿相机抖动和场景内运动,然后将其平均,并仔细处理无法完美对齐的情况。尽管各个帧可能相当粗糙,但合并后的平均图像看起来要清晰得多。

实验曝光时间

Night Sight发布后不久,他们开始在非常黑暗的室外环境中拍摄星星。他们意识到,就像之前的实验一样,高质量的图片需要几分钟的曝光时间。显然,这不适用于手机拍摄。

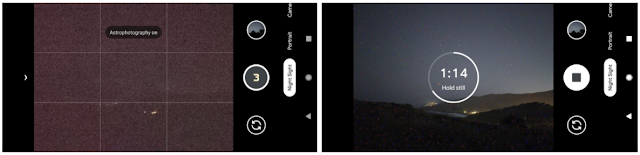

同时,夜间景观拍摄必须考虑到运动的场景。观看者可以忍受照片中模糊的云朵和树枝,但是看起来像短线段的模糊的星星看起来是非常糟糕的。为了减轻这种情况,他们将曝光分为几帧,曝光时间短到足以使星星看起来像光点。拍摄夜空照片时,我们发现每帧曝光时间不应超过16秒。

16秒的曝光能够捕获足够的光以生成可识别的图像,但是一个夜视相机应用程序必须处理低光摄影所特有的其他问题。

场景合成

手机将其屏幕用作电子取景器来捕获连续的帧流,这些帧显示为实时视频,以帮助进行镜头合成。相机的自动对焦,自动曝光和自动白平衡系统同时使用这些帧。

为了帮助在极低的光线下构图,Night Sight显示了“快门后取景器”。按下快门按钮后,每个长时间曝光的画面都会在拍摄后立即显示在屏幕上。这些框架的曝光时间高达16秒,比普通的取景器框架收集的光线多出近250倍,因此,拍摄第一帧图像后,摄影师可以轻松查看图像细节。然后可以在曝光持续的同时通过移动手机来调整构图。一旦构图正确,就可以停止初始拍摄,并在所有帧都具有所需构图的情况下捕获第二张照片。

自动

自动对焦可确保相机拍摄的图像清晰。在正常操作中,将分析入射的取景器镜架以确定镜头必须距传感器多远才能产生聚焦图像,但是在非常弱的光线下,取景器镜架可能太暗且颗粒状,以至于由于缺乏自动对焦而无法自动对焦可检测的图像细节。发生这种情况时,Pixel 4上的Night Sight会切换为“快门后自动对焦”。用户按下快门按钮后,相机将捕获两个自动对焦帧,其曝光时间长达一秒,即使在弱光下也足以检测图像细节。这些框仅用于聚焦镜头,并不直接构成最终图像。

天空处理

当在屏幕上查看非常黑暗的环境图像时,它们的显示比原始场景要明亮得多。这可以改变观看者对一天中拍摄照片的感觉。到了晚上,我们期望天空是黑暗的。如果在夜间拍摄的照片显示出明亮的天空,则我们将其视为白天的场景,也许会有轻微的异常照明。

在Night Sight中,可以通过在昏暗的场景中选择性地使天空变暗来抵消这种效果。为此,我们使用机器学习来检测图像的哪些区域代表天空。一个设备上的卷积神经网络经过训练,通过跟踪天空区域的轮廓对10万张图像进行了人工标记,从而将照片中的每个像素标识为“天空”或“非天空”。

天空检测还可以执行特定于天空的降噪,并有选择地增加对比度以使诸如云,颜色渐变或银河系等特征更加突出。

结果

当然,手机的功能不是无限的,并且总有改进的空间。尽管夜间场景总体较暗,但它们通常包含明亮的光源,例如月亮,遥远的路灯或著名的星星。尽管我们可以捕获月光下的风景或月球表面上的细节,但到目前为止,亮度范围非常大(可以超过500000:1),这使我们无法同时捕获同一图像。另外,当星星是唯一的照明源时,我们可以拍摄清晰的天空照片,但是风景只能作为轮廓看到。

对于Pixel 4,我们一直使用银河系中最亮的部分,靠近人马座,作为无月天空图像质量的基准。按照该标准,Night Sight做得很好。尽管银河系的照片显示出一些残留的噪音,但它们却令人赏心悦目,它们显示出比人看到真实夜空更多的星星和更多的细节。