亚马逊的研究人员用多种语言训练了一个人工智能模型来改进产品搜索

2020年01月10日 由 TGS 发表

381080

0

亚马逊在全球14个国家开展业务,其中9个国家有资格享受其Prime年度订阅服务。基于此,该公司有一个宏大的愿望,那就是使其购物体验不会因为语言而有任何折扣。

亚马逊在全球14个国家开展业务,其中9个国家有资格享受其Prime年度订阅服务。基于此,该公司有一个宏大的愿望,那就是使其购物体验不会因为语言而有任何折扣。为了寻找一种高效的翻译多种语言的方法,亚马逊的研究人员设计了一种名为“多任务”的购物模型,在这种模型中,不同任务的功能相互重叠,而且往往相互强化。这个人工智能同时针对几种不同语言的数据进行训练,使用其中任何一种语言都能获得更好的结果。

正如亚马逊应用科学家Nikhil Rao在博客中解释的那样,这种改进的原理,是因为一种语言能够填补另一种语言的空白。例如,在法语中容易混淆的短语,在德语中可能就会泾渭分明,因此多语言培训可以帮助增强几个产品查询之间的区别。

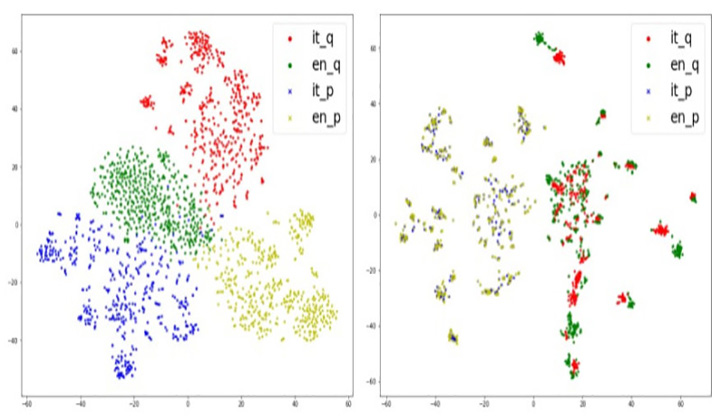

团队的系统将与产品和产品描述相关的查询映射到表示空间的同一区域,而不考虑语言,这主要是为了帮助模型将它在一种语言中学到的知识推广到其他语言,让搜索结果在空间的一个区域相互接近。

团队的系统将与产品和产品描述相关的查询映射到表示空间的同一区域,而不考虑语言,这主要是为了帮助模型将它在一种语言中学到的知识推广到其他语言,让搜索结果在空间的一个区域相互接近。系统会接收两个输入,一个查询和一个产品标题,然后输出单个位,指示产品是否与查询匹配。一个编码器组件利用了谷歌的Transformer架构,研究人员说它的可伸缩性比其他架构更好,而模型的分类器结合了查询和产品编码。该团队通过随机选择一种输入语言并“教”它用这种语言对查询产品对进行分类来训练系统。然后再用它的每种输入语言对带注释的样例查询进行一系列epoch从头到尾的训练。对齐阶段通过最小化产品名称编码和查询之间的距离,确保为不同语言定制的输出共享一个表示空间。

亚马逊表示,在涉及10种不同双语模式、10种三语模式和1种五语模式的实验中,他们取得了“强有力的结果”。F1分数是人工智能中一个常见的绩效衡量指标,它会将假阳性和假阴性的比率考虑在内。根据F1分数,一个同时接受法语和德语训练的多语言模型比一个只会法语的模型高出11%,比一个只会德语的模型高出5%。

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

下一篇

来自神经网络的物理学见解

热门企业

热门职位

写评论取消

回复取消