亚马逊Alexa耳语模式背后的AI

2020年01月18日 由 KING 发表

322126

0

在简短披露后的几个月,2018年10月,亚马逊带来了Whisper Mode,以选择第三方和第一方Alexa设备。它将在2019年11月将功能扩展到所有地区,以便由Alexa支持的所有智能家电现在都通过耳语回音来回应耳语。

亚马逊最初对技术细节不太了解,但“耳语模式”使用神经网络(人脑神经元松散地建模的数学功能层)来区分正常和低语单词。但是在2020年1月发表的一篇学术论文中,它详细介绍了导致扩展的研究。 亚马逊语音研究小组的应用科学家马里乌斯·科特斯库(Marius Cotescu)解释说,主要的挑战是将正常语音转换为低语语音,同时保持自然和说话者身份。他和他的同事研究了几种不同的转换技术,包括基于对低声语音的声学分析的手工数字信号处理(DSP),但他们最终选择了两种机器学习方法,因为它们的鲁棒性(它们很容易推广到陌生的说话者)和性能(它们的性能优于手工信号处理器)。

亚马逊语音研究小组的应用科学家马里乌斯·科特斯库(Marius Cotescu)解释说,主要的挑战是将正常语音转换为低语语音,同时保持自然和说话者身份。他和他的同事研究了几种不同的转换技术,包括基于对低声语音的声学分析的手工数字信号处理(DSP),但他们最终选择了两种机器学习方法,因为它们的鲁棒性(它们很容易推广到陌生的说话者)和性能(它们的性能优于手工信号处理器)。

两种方法都基于高斯混合模型(GMM)和深层神经网络(DNN),它们都涉及训练算法,以将普通语音的声学特征映射到低声语音的声学特征。GMM尝试为每个输出特征识别与输入值的相关分布相对应的值范围,而DNN(简单处理节点的密集算法)通过网络尝试预测相关输出的过程来调整其内部设置,具有特定的输入。

研究人员的系统将声学特征表示传递给声码器,然后将其转换为连续信号。虽然实验版本依赖于称为WORLD的开源声码器,但部署给客户的Whisper Mode版本却利用了神经声码器,可以进一步提高低语语音质量。

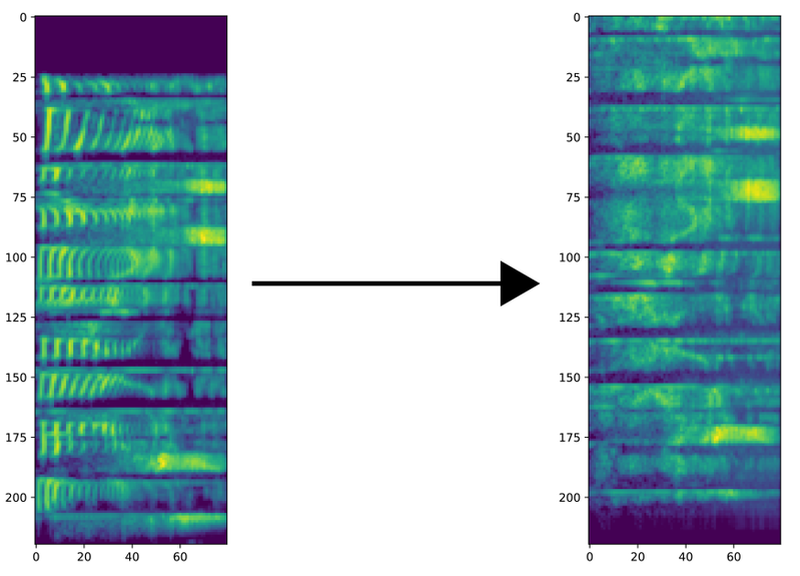

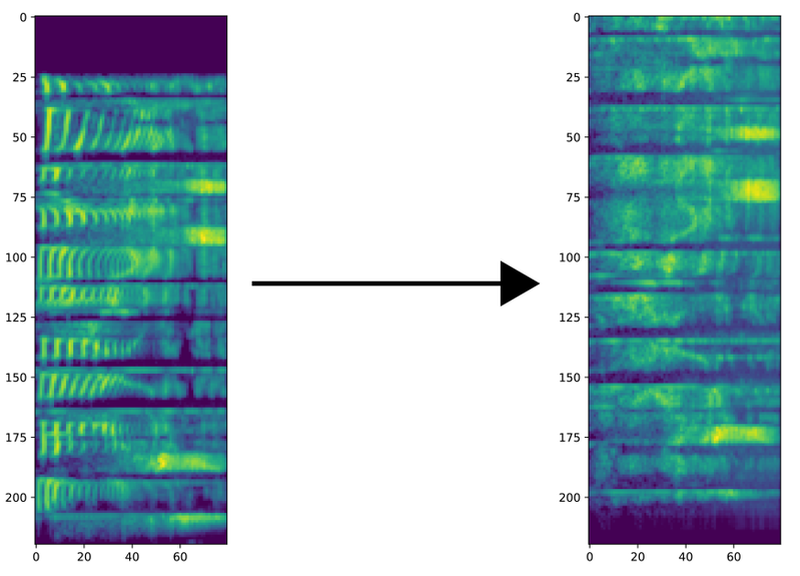

上图:正常语音语音的声谱图(左)以及对其应用耳语语音转换模型的结果。

该团队使用了两个数据集来训练他们的语音转换系统:一个是使用来自澳大利亚,加拿大、德国、印度和美国的五名专业语音演员制作的,另一个是该领域的流行基准。(这两个语料库都包括许多说话者的成对说话,一个完整的声音,一个低声说话)为了评估他们的系统,他们将输出与自然语音录音和通过声码器输入的语音录音进行了比较。

在第一组实验中,团队对语音转换系统进行了基于单个扬声器数据的培训,并对来自相同扬声器的数据进行了测试。他们发现,虽然原始录音听起来最自然,但模型合成的耳语听起来比“语音编码”人类语音更自然。

最先进的文本语音转换模型可以生成在初次收听时听起来几乎和人声一样的片段。实际上,它们支持通过Google Assistant提供的神经语音,以及最近出现在Alexa和亚马逊Polly服务中的新闻播音员语音,以及去年12月可用的Samuel L. Jackson名人Alexa语音技能。