ChatGPT 为何独树一帜,无法被模仿?

2023年05月29日 由 Susan 发表

126735

0

自从发布了 ChatGPT,《大型语言模型》(LLM)聊天机器人就备受关注。有用户、讨论者,还有正在努力构建自己版本的开发人员和其他人工智能公司。虽然 OpenAI 的模型是封闭源代码的,但很多开源模型给开发者带来了希望,让他们能够构建类似于市场上最佳聊天机器人的东西。

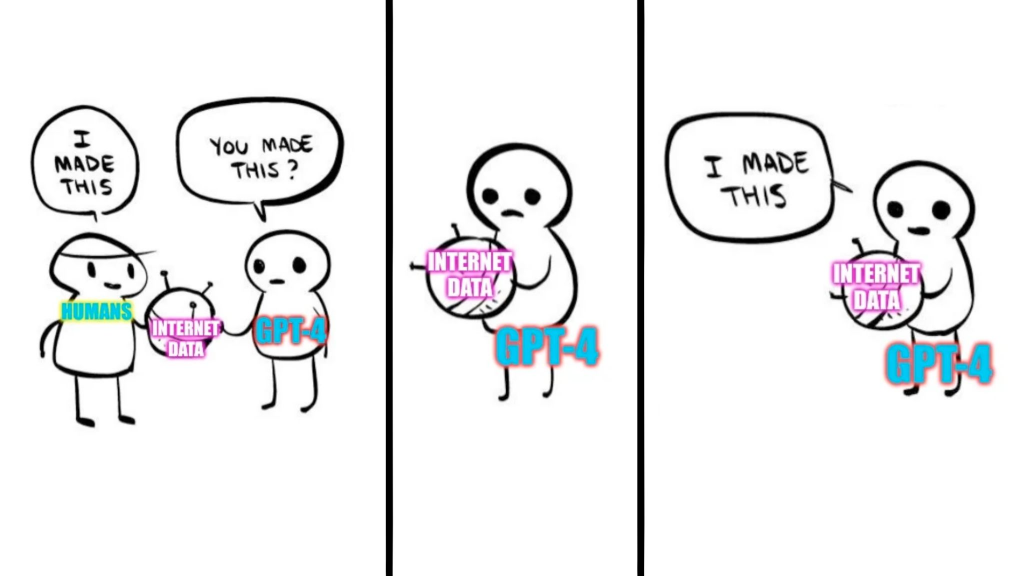

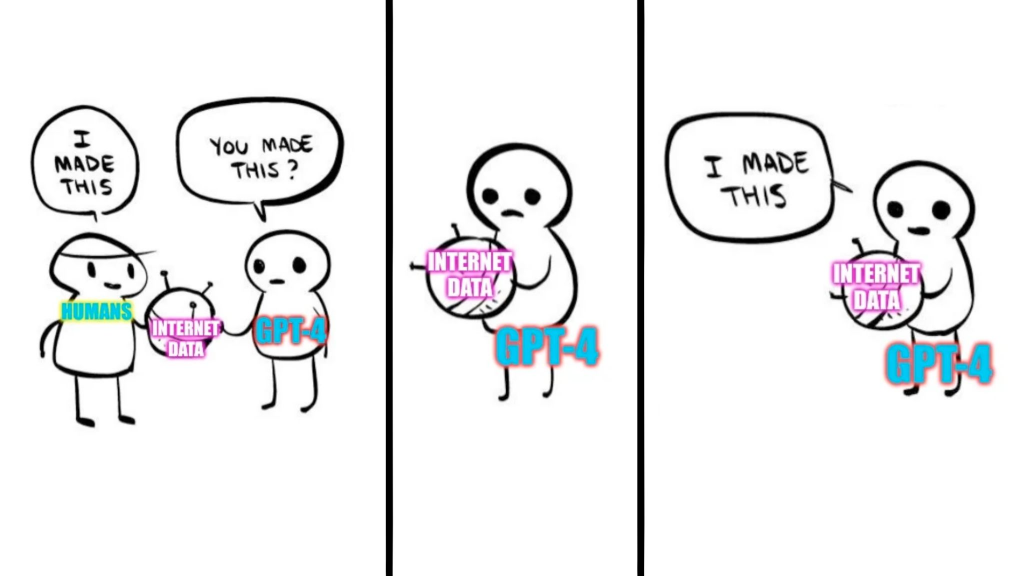

提高开源语言模型(例如 LLaMa、Alpaca 或 Self-Instruct)的一种新兴的廉价方法之一是在像 ChatGPT 这样更强大的专有系统输出上进行微调。这似乎是一种有效的方式,来模仿和建立较弱模型的能力,以达到与更强模型相媲美的水平,但这种方法实际上失败了。

继承上的缺陷

UC 伯克利的研究人员最近发表了一篇论文——《模仿专有 LLM 的虚假承诺》,对这种模仿方法的有效性进行了批判性分析。研究人员解释了使用专有语言模型进行训练模型会引发各种法律和理论上的问题。

说起这种方法所实现的技术改进也是微不足道的。根据这篇论文,微调较弱的模型以提高其知识能力对语言模型的影响很小,几乎没有影响。

预训练是提高语言模型能力的主要来源。因此,将像 LLaMa、Vicuna、Alpaca 和 Self-Instruct 这样的较小模型微调到像 ChatGPT 和 Bard 这样的大模型的输出上,并没有提高模型的知识,因为基础数据保持不变。这只会改变模型的样式,而不会提高其知识。

此外,试图通过模仿 ChatGPT 等大型模型的输出来模仿它们的知识和能力时,较弱的模型也会继承它们的缺陷和偏见。

通过模仿微调这些模型也削弱了直接改进关闭的 AI 模型(例如 ChatGPT)的设计决策的能力,从而使这些模型的表现甚至不如 AI 公司直接提供的模型。模型未能在重要方面如事实性、编码和解决问题等方面进行改进。

拥有像 GPT-4 或谷歌的 PaLM 这样大型基础模型的大公司,没有理由担心模仿,因为它们与试图模仿它们的模型之间存在巨大的差距。获取大量数据、计算和算法的公司更可能保持其竞争优势。

试图通过利用像 LLaMa 或其他开源语言模型(LLMs)来建立自己的“护城河”的较小公司更容易遭受模仿的风险。正如前面所解释的那样,使用 ChatGPT 数据微调模型并没有像由公司自己构建和改进预训练数据那样显著地提高语言模型的性能。

然而,像 OpenAI 这样的公司从未公开披露它们训练模型所用的数据。可以肯定的是,其中很大一部分是来自公开的互联网数据,而非它们自有的专有数据。根据 Hacker News 上的用户指出的 UC 伯克利的研究论文,使用这些数据可能是非法的,但这可能并不正确。

该论文得出的结论并不基于当前开源软件的发展情况。在 LLaMa 发布之前,人们认为模型越大,性能越好。但是,构建在像 LLaMa 这样较小模型基础之上的各种模型都表现超过了 GPT-4 和 PaLM。

在谷歌泄露的文件中,谷歌表示他们自己和 OpenAI 在 AI 领域没有“护城河”。该文件赞扬了开源社区,并在很多方面提到了 Meta 的 LLaMa。尽管谷歌和 OpenAI 没有对他们所训练的数据拥有专有权利,但语言模型的未来可能不会保持不变,而变得比较可怕。

最近,美国企业家和人工智能爱好者马克·库班表示,大公司的基于 LLM 的聊天机器人的下一步是拥有可购买的私有数据,以构建专有的大型知识模型,而非使用 LLMs。这些模型将能够表现得更好,并且对公司而言,它们就像是护城河,因为没有人能够访问这些数据。

我们已经有一个例子,即首席推特官伊隆·马斯克如何阻止OpenAI访问其数据,并威胁称将对其和微软提起诉讼,禁止其继续使用。现在,他的新聊天机器人也在其中,可能是训练于Twitter数据,这些数据是他独有的,即使开源社区也无法访问。

对于开源社区而言,这意味着如果开发者依赖于 LLaMa 等现成的语言模型,他们将无法在由大公司构建的任何其他模型上进行微调。

目前,使用 ChatGPT 或 Bard 的数据微调模型并没有涉及法律或道德问题,因为这些数据不仅属于公司。但如果库班是正确的,并且公司开始购买独占数据访问权,那么开源社区将停止繁荣。

这些公司可能不想允许任何人竞争,而开源社区正在崛起,限制数据访问可能是它们的最大一步。目前,较小的模型的重要之处在于其特定的用例能力。但如果大公司获得其他公司数据的独占权,并将其保密,他们可能轻松超越较小的模型。

没有人会公开或发布他们的数据来源,但它显然是互联网。如果这些巨头开始获取其他公司数据的知识产权,他们将成为社区中最具知识的模型,并且开源社区可能会消亡。

来源:https://analyticsindiamag.com/why-you-can-never-imitate-chatgpt/

提高开源语言模型(例如 LLaMa、Alpaca 或 Self-Instruct)的一种新兴的廉价方法之一是在像 ChatGPT 这样更强大的专有系统输出上进行微调。这似乎是一种有效的方式,来模仿和建立较弱模型的能力,以达到与更强模型相媲美的水平,但这种方法实际上失败了。

继承上的缺陷

UC 伯克利的研究人员最近发表了一篇论文——《模仿专有 LLM 的虚假承诺》,对这种模仿方法的有效性进行了批判性分析。研究人员解释了使用专有语言模型进行训练模型会引发各种法律和理论上的问题。

说起这种方法所实现的技术改进也是微不足道的。根据这篇论文,微调较弱的模型以提高其知识能力对语言模型的影响很小,几乎没有影响。

预训练是提高语言模型能力的主要来源。因此,将像 LLaMa、Vicuna、Alpaca 和 Self-Instruct 这样的较小模型微调到像 ChatGPT 和 Bard 这样的大模型的输出上,并没有提高模型的知识,因为基础数据保持不变。这只会改变模型的样式,而不会提高其知识。

此外,试图通过模仿 ChatGPT 等大型模型的输出来模仿它们的知识和能力时,较弱的模型也会继承它们的缺陷和偏见。

通过模仿微调这些模型也削弱了直接改进关闭的 AI 模型(例如 ChatGPT)的设计决策的能力,从而使这些模型的表现甚至不如 AI 公司直接提供的模型。模型未能在重要方面如事实性、编码和解决问题等方面进行改进。

数据模仿不是唯一的方法

拥有像 GPT-4 或谷歌的 PaLM 这样大型基础模型的大公司,没有理由担心模仿,因为它们与试图模仿它们的模型之间存在巨大的差距。获取大量数据、计算和算法的公司更可能保持其竞争优势。

试图通过利用像 LLaMa 或其他开源语言模型(LLMs)来建立自己的“护城河”的较小公司更容易遭受模仿的风险。正如前面所解释的那样,使用 ChatGPT 数据微调模型并没有像由公司自己构建和改进预训练数据那样显著地提高语言模型的性能。

然而,像 OpenAI 这样的公司从未公开披露它们训练模型所用的数据。可以肯定的是,其中很大一部分是来自公开的互联网数据,而非它们自有的专有数据。根据 Hacker News 上的用户指出的 UC 伯克利的研究论文,使用这些数据可能是非法的,但这可能并不正确。

该论文得出的结论并不基于当前开源软件的发展情况。在 LLaMa 发布之前,人们认为模型越大,性能越好。但是,构建在像 LLaMa 这样较小模型基础之上的各种模型都表现超过了 GPT-4 和 PaLM。

如果数据变得私密怎么办?

在谷歌泄露的文件中,谷歌表示他们自己和 OpenAI 在 AI 领域没有“护城河”。该文件赞扬了开源社区,并在很多方面提到了 Meta 的 LLaMa。尽管谷歌和 OpenAI 没有对他们所训练的数据拥有专有权利,但语言模型的未来可能不会保持不变,而变得比较可怕。

最近,美国企业家和人工智能爱好者马克·库班表示,大公司的基于 LLM 的聊天机器人的下一步是拥有可购买的私有数据,以构建专有的大型知识模型,而非使用 LLMs。这些模型将能够表现得更好,并且对公司而言,它们就像是护城河,因为没有人能够访问这些数据。

“我们忽略了创造我们的东西;我们喜欢我们创造的东西“——阿莱斯特·克劳利,《谎言之书》

我们已经有一个例子,即首席推特官伊隆·马斯克如何阻止OpenAI访问其数据,并威胁称将对其和微软提起诉讼,禁止其继续使用。现在,他的新聊天机器人也在其中,可能是训练于Twitter数据,这些数据是他独有的,即使开源社区也无法访问。

对于开源社区而言,这意味着如果开发者依赖于 LLaMa 等现成的语言模型,他们将无法在由大公司构建的任何其他模型上进行微调。

目前,使用 ChatGPT 或 Bard 的数据微调模型并没有涉及法律或道德问题,因为这些数据不仅属于公司。但如果库班是正确的,并且公司开始购买独占数据访问权,那么开源社区将停止繁荣。

这些公司可能不想允许任何人竞争,而开源社区正在崛起,限制数据访问可能是它们的最大一步。目前,较小的模型的重要之处在于其特定的用例能力。但如果大公司获得其他公司数据的独占权,并将其保密,他们可能轻松超越较小的模型。

没有人会公开或发布他们的数据来源,但它显然是互联网。如果这些巨头开始获取其他公司数据的知识产权,他们将成为社区中最具知识的模型,并且开源社区可能会消亡。

来源:https://analyticsindiamag.com/why-you-can-never-imitate-chatgpt/

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消