如何用新工具评估AI模型的性能

2023年06月01日 由 Neo 发表

627985

0

当机器学习模型部署在现实世界中时,就像是标记X射线中的潜在疾病以供放射科医生检查,人类用户也需要知道何时信任模型的预测。

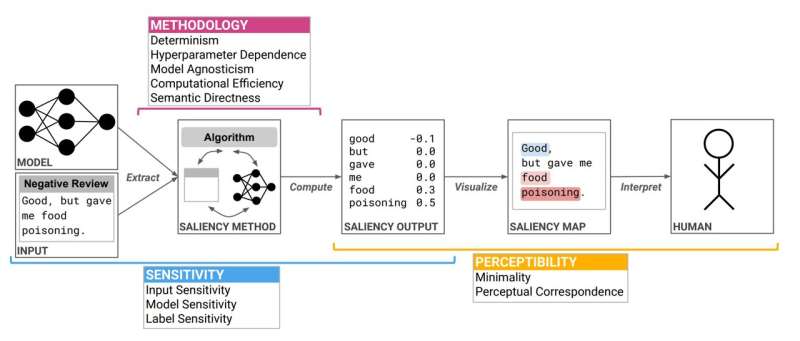

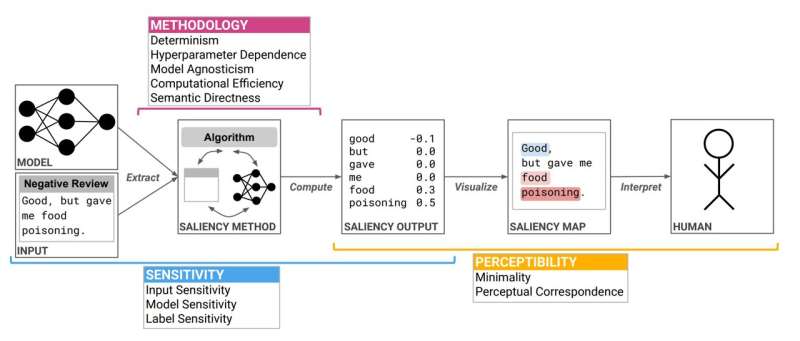

但机器学习模型如此庞大和复杂,以至于即使是设计它们的科学家也无法准确理解这些模型是如何进行预测的。因此,他们创造了被称为显着性方法的技术,试图解释模型行为。

随着新方法不断发布,麻省理工学院和IBM研究机构的研究人员创建了一种工具,以帮助用户选择最适合其特定任务的显著性方法。他们开发了显著性卡,提供一份标准化的文档,介绍方法的操作方式,包括其优点和缺点,并提供解释,帮助用户正确解释它。

麻省理工学院和人工智能实验室(CSAIL)可视化组的研究生、合作主席之一安吉·博格斯特解释说,借助这些信息,他们希望用户能够有针对性地选择适合其所使用的机器学习模型和该模型执行的任务的合适的显著性方法。

与人工智能研究人员和其他领域专家的访谈表明,这些卡片有助于人们快速地比较不同方法,并选择合适的技术。选择正确的方法可以让用户更准确地了解其模型的行为,因此他们更能够正确地解释其预测。

博格斯特表示:“显著性卡旨在快速地提供显著性方法的简洁摘要,并将其分解为最关键的、以人为本的属性。它们真的是为所有人设计的,从机器学习研究人员到首次尝试的非专业用户。”

除博格斯特外,本文的另一位合作主席是麻省理工学院的博士后Harini Suresh;IBM研究机构的高级研究科学家Hendrik Strobelt;麻省理工学院计算机科学和电气工程杰出教授John Guttag;以及麻省理工学院计算机科学副教授Arvind Satyanarayan,他们领导着CSAIL的可视化组。这项研究将在ACM公平性、问责性和透明度会议上展示。

选择正确的方法

研究人员先前使用忠实度的概念评估了显著性方法。在这种情况下,忠实度反映了一种模型决策过程的准确程度。

但是,博格斯特解释说,忠诚度并不是非黑即白的。一种方法可能在忠实度的一个测试下表现良好,但在另一个测试下失败。由于有如此多的显著性方法和许多可能的评估方法,用户通常会选择一种流行的方法或同事所使用的方法。

然而,选择“错误”的方法会产生严重的后果。例如,一种称为集成梯度的显着性方法将图像中特征的重要性与无意义的基线进行比较。此方法通常使用全 0 作为基线,但如果应用于图像,则全 0 等同于黑色。

博格斯特说:“它会告诉你图像中的任何黑色像素都不重要,即使它们是有意义的,因为它们与那个无意义的基准相同。如果你正在看X射线,这可能是个大问题,因为医生可能会关注黑色。”

显着性卡片可以根据 10 个以用户为中心的属性总结显着性方法的工作原理,从而帮助用户避免此类问题。这些属性捕获显着性的计算方式、显着性方法与模型之间的关系,以及用户如何感知其输出。

例如,其中一个属性是超参数依赖性,它衡量了该显著性方法对用户指定参数的敏感性。综合梯度的显著性卡将描述它的参数以及它们如何影响其性能。借助该卡,用户可以迅速了解默认参数(全0基准线)在评估X射线时可能会产生误导性的结果。

这些卡也可能对科学家有用,因为它们揭示了研究领域中的空缺。例如,麻省理工学院的研究人员无法确定一种既具有计算效率,又可应用于任何机器学习模型的显著性方法。

博格斯特说:“我们能否填补这个空白?是否有一种显著性方法可以同时完成这两件事?或者这两个想法在理论上存在冲突。”

亮出他们的卡片

在他们创建了几张卡片后,该团队与八位领域专家进行了用户研究,从计算机科学家到不熟悉机器学习的放射科医生。在采访中,所有参与者都表示简洁的描述有助于他们确定属性的优先级并比较方法。博格斯特说,即使他不熟悉机器学习,放射科医生也能够理解卡片并使用它们参与选择显着性方法的过程。

采访还透露了一些惊喜。研究人员通常期望临床医生需要一种清晰的方法,这意味着它可以专注于医学图像中的特定对象。但是在这项研究中,这位临床医生实际上更喜欢医学图像中的一些噪点,以帮助他们减少不确定性。

她说:“当我们将其分解为不同的属性并询问人们时,研究中没有一个人的优先事项与其他人相同,即使他们扮演相同的角色。”

未来,研究人员希望探索一些评估不足的属性,并设计特定任务的显著性方法。他们还希望更好地了解人们如何感知显著性方法输出,这可能会导致更好的可视化。此外,博格斯特表示,他们将通过公共库来托管工作,以便其他人提供反馈,推动未来的工作。

她说:“我们真的希望这些不断发展的卡片,会随着新的显著性方法和评估的开发而不断壮大。最终,这关于显著性方法属性及其在不同任务中的作用的对话将成为一个好的开始。”

来源:https://techxplore.com/news/2023-05-tool-people-method-ai.html

但机器学习模型如此庞大和复杂,以至于即使是设计它们的科学家也无法准确理解这些模型是如何进行预测的。因此,他们创造了被称为显着性方法的技术,试图解释模型行为。

随着新方法不断发布,麻省理工学院和IBM研究机构的研究人员创建了一种工具,以帮助用户选择最适合其特定任务的显著性方法。他们开发了显著性卡,提供一份标准化的文档,介绍方法的操作方式,包括其优点和缺点,并提供解释,帮助用户正确解释它。

麻省理工学院和人工智能实验室(CSAIL)可视化组的研究生、合作主席之一安吉·博格斯特解释说,借助这些信息,他们希望用户能够有针对性地选择适合其所使用的机器学习模型和该模型执行的任务的合适的显著性方法。

与人工智能研究人员和其他领域专家的访谈表明,这些卡片有助于人们快速地比较不同方法,并选择合适的技术。选择正确的方法可以让用户更准确地了解其模型的行为,因此他们更能够正确地解释其预测。

博格斯特表示:“显著性卡旨在快速地提供显著性方法的简洁摘要,并将其分解为最关键的、以人为本的属性。它们真的是为所有人设计的,从机器学习研究人员到首次尝试的非专业用户。”

除博格斯特外,本文的另一位合作主席是麻省理工学院的博士后Harini Suresh;IBM研究机构的高级研究科学家Hendrik Strobelt;麻省理工学院计算机科学和电气工程杰出教授John Guttag;以及麻省理工学院计算机科学副教授Arvind Satyanarayan,他们领导着CSAIL的可视化组。这项研究将在ACM公平性、问责性和透明度会议上展示。

选择正确的方法

研究人员先前使用忠实度的概念评估了显著性方法。在这种情况下,忠实度反映了一种模型决策过程的准确程度。

但是,博格斯特解释说,忠诚度并不是非黑即白的。一种方法可能在忠实度的一个测试下表现良好,但在另一个测试下失败。由于有如此多的显著性方法和许多可能的评估方法,用户通常会选择一种流行的方法或同事所使用的方法。

然而,选择“错误”的方法会产生严重的后果。例如,一种称为集成梯度的显着性方法将图像中特征的重要性与无意义的基线进行比较。此方法通常使用全 0 作为基线,但如果应用于图像,则全 0 等同于黑色。

博格斯特说:“它会告诉你图像中的任何黑色像素都不重要,即使它们是有意义的,因为它们与那个无意义的基准相同。如果你正在看X射线,这可能是个大问题,因为医生可能会关注黑色。”

显着性卡片可以根据 10 个以用户为中心的属性总结显着性方法的工作原理,从而帮助用户避免此类问题。这些属性捕获显着性的计算方式、显着性方法与模型之间的关系,以及用户如何感知其输出。

例如,其中一个属性是超参数依赖性,它衡量了该显著性方法对用户指定参数的敏感性。综合梯度的显著性卡将描述它的参数以及它们如何影响其性能。借助该卡,用户可以迅速了解默认参数(全0基准线)在评估X射线时可能会产生误导性的结果。

这些卡也可能对科学家有用,因为它们揭示了研究领域中的空缺。例如,麻省理工学院的研究人员无法确定一种既具有计算效率,又可应用于任何机器学习模型的显著性方法。

博格斯特说:“我们能否填补这个空白?是否有一种显著性方法可以同时完成这两件事?或者这两个想法在理论上存在冲突。”

亮出他们的卡片

在他们创建了几张卡片后,该团队与八位领域专家进行了用户研究,从计算机科学家到不熟悉机器学习的放射科医生。在采访中,所有参与者都表示简洁的描述有助于他们确定属性的优先级并比较方法。博格斯特说,即使他不熟悉机器学习,放射科医生也能够理解卡片并使用它们参与选择显着性方法的过程。

采访还透露了一些惊喜。研究人员通常期望临床医生需要一种清晰的方法,这意味着它可以专注于医学图像中的特定对象。但是在这项研究中,这位临床医生实际上更喜欢医学图像中的一些噪点,以帮助他们减少不确定性。

她说:“当我们将其分解为不同的属性并询问人们时,研究中没有一个人的优先事项与其他人相同,即使他们扮演相同的角色。”

未来,研究人员希望探索一些评估不足的属性,并设计特定任务的显著性方法。他们还希望更好地了解人们如何感知显著性方法输出,这可能会导致更好的可视化。此外,博格斯特表示,他们将通过公共库来托管工作,以便其他人提供反馈,推动未来的工作。

她说:“我们真的希望这些不断发展的卡片,会随着新的显著性方法和评估的开发而不断壮大。最终,这关于显著性方法属性及其在不同任务中的作用的对话将成为一个好的开始。”

来源:https://techxplore.com/news/2023-05-tool-people-method-ai.html

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消