MosaicML发布开源MPT-30B LLM,为生成式AI应用提供动力

2023年06月30日 由 Samoyed 发表

27142

0

MosaicML宣布推出MPT-30B Base、Instruct和Chat,这是他们MPT(MosaicML Pretrained Transformer)系列开源大型语言模型中最先进的模型。这些最先进的模型已经用8k标记上下文窗口进行训练,并且超过了最初的GPT-3的质量,可以直接用于推理或作为建立专有模型的起点。它们在MosaicML平台上接受训练,其中部分使用了NVIDIA最新一代H100加速器,现在MosaicML的客户可以使用该加速器。通过在MPT-30B的基础上进行构建,企业可以在不损害安全性或数据隐私的情况下利用生成式人工智能的力量。

MosaicML MPT系列模型是当今最强大、最流行的开源语言模型,可用于商业用途。自2023年5月5日发布以来,MPT-7B模型(Base, Instruct, Chat, StoryWriter)已被下载超过330万次。新版本扩展了MPT系列与更大,更高质量的MPT- 30b模型,解锁了更多的应用程序。与往常一样,MosaicML的MPT模型针对高效的训练和推理进行了优化。

值得注意的是,当使用标准的学术基准测量时,MPT-30B超过了最初发布的GPT-3。

此外,GPT-3有1750亿个参数,而MPT-30B只有300亿个参数,也就是说MPT-30B在使用约1/6的参数数量的情况下实现了这一质量目标。这意味着MPT-30B更容易在本地硬件上运行,而且部署推理的成本更低,让开发者和企业可以建立和部署自己的商业上可行的企业级GPT-3质量模型。它的训练成本也比原始GPT-3的估计值低几个数量级,使企业有能力训练定制的GPT-3模型。

最后,MPT-30B是在比GPT-3、流行的LLaMA系列模型和最近的Falcon模型更长的序列上进行训练的。它的设计是为了在实践中处理甚至更长的序列,使其成为数据量大的企业应用的完美选择。

得益于MosaicML平台领先的灵活性和可靠性,MPT-30B是第一个公开的在NVIDIA H100 GPU上训练的LLM。在硬件交付后的几天内,MosaicML团队就能够将MPT-30B的训练运行从原来的A100集群无缝转移到新的H100集群上,这使得每GPU的吞吐量增加了2.4倍以上,从而加快了完成时间。MosaicML致力于将硬件和软件的最新进展带给所有企业,让他们能够以比以前更快、更低的成本训练模型。

H100的时间是从256xH100系统中推断出来的。成本基于截至2023年6月22日MosaicML保留集群定价2.50美元/A100-40GB/小时和5.00美元/H100-80GB/小时。成本可能会有所变化。

成本截至2023年6月22日的MosaicML保留集群定价2.50美元/A100-40GB/小时和5.00美元/H100-80GB/小时。成本可能会有所变化。

企业正在为代码完成和对话生成等用例部署MPT模型,并使用自己的专有数据对这些模型进行微调。

Replit是世界领先的基于web的IDE,能够在短短三天内使用他们的专有数据和MosaicML的培训平台构建新的代码生成模型。他们的定制MPT模型,replit-code-v1-3b,在速度、成本和代码质量方面显著提高了GhostWriter产品的性能。

尖端人工智能初创公司Scatter Lab正在打造“社交人工智能聊天机器人”,能够实现引人入胜的、类似人类的对话,他们从头开始训练自己的MPT模型,为定制聊天机器人提供动力。该模型是可以同时理解英语和韩国语的多语言生成人工智能模型之一,为150万名用户提供了新的聊天体验。

全球旅行和费用管理软件公司Navan正在MPT的基础上建立他们的定制LLM。

“在Navan,我们在我们的产品和服务中使用生成式人工智能,为我们的虚拟旅行社和会话式商业智能代理等体验提供动力。MosaicML的基础模型提供了最先进的语言功能,同时在大规模微调和服务推理方面非常有效。我们很高兴看到这项有前途的技术如何发展,”Navan联合创始人兼首席技术官Ilan Twig说。

MPT-30B旨在为那些希望为聊天、问答、摘要、提取和其他语言应用程序构建自己的语言模型的企业加速模型开发。

来源:https://insidebigdata.com/2023/06/28/generative-ai-report-mosaicml-releases-open-source-mpt-30b-llms-trained-on-h100s-to-power-generative-ai-applications/

自5月以来,MPT下载量超过300万次

MosaicML MPT系列模型是当今最强大、最流行的开源语言模型,可用于商业用途。自2023年5月5日发布以来,MPT-7B模型(Base, Instruct, Chat, StoryWriter)已被下载超过330万次。新版本扩展了MPT系列与更大,更高质量的MPT- 30b模型,解锁了更多的应用程序。与往常一样,MosaicML的MPT模型针对高效的训练和推理进行了优化。

MPT-30B超过GPT-3

值得注意的是,当使用标准的学术基准测量时,MPT-30B超过了最初发布的GPT-3。

此外,GPT-3有1750亿个参数,而MPT-30B只有300亿个参数,也就是说MPT-30B在使用约1/6的参数数量的情况下实现了这一质量目标。这意味着MPT-30B更容易在本地硬件上运行,而且部署推理的成本更低,让开发者和企业可以建立和部署自己的商业上可行的企业级GPT-3质量模型。它的训练成本也比原始GPT-3的估计值低几个数量级,使企业有能力训练定制的GPT-3模型。

最后,MPT-30B是在比GPT-3、流行的LLaMA系列模型和最近的Falcon模型更长的序列上进行训练的。它的设计是为了在实践中处理甚至更长的序列,使其成为数据量大的企业应用的完美选择。

现在可以为MosaicML客户提供H100 GPU上的培训

得益于MosaicML平台领先的灵活性和可靠性,MPT-30B是第一个公开的在NVIDIA H100 GPU上训练的LLM。在硬件交付后的几天内,MosaicML团队就能够将MPT-30B的训练运行从原来的A100集群无缝转移到新的H100集群上,这使得每GPU的吞吐量增加了2.4倍以上,从而加快了完成时间。MosaicML致力于将硬件和软件的最新进展带给所有企业,让他们能够以比以前更快、更低的成本训练模型。

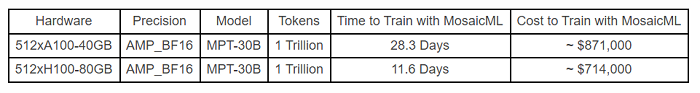

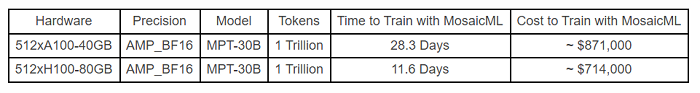

在1万亿token上从头预训练MPT-30B的时间和成本

H100的时间是从256xH100系统中推断出来的。成本基于截至2023年6月22日MosaicML保留集群定价2.50美元/A100-40GB/小时和5.00美元/H100-80GB/小时。成本可能会有所变化。

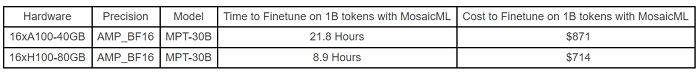

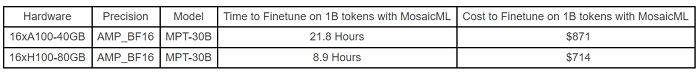

MPT-30B在小型系统上的微调时间和成本

成本截至2023年6月22日的MosaicML保留集群定价2.50美元/A100-40GB/小时和5.00美元/H100-80GB/小时。成本可能会有所变化。

MosaicML MPT:推动新一代人工智能应用

企业正在为代码完成和对话生成等用例部署MPT模型,并使用自己的专有数据对这些模型进行微调。

Replit是世界领先的基于web的IDE,能够在短短三天内使用他们的专有数据和MosaicML的培训平台构建新的代码生成模型。他们的定制MPT模型,replit-code-v1-3b,在速度、成本和代码质量方面显著提高了GhostWriter产品的性能。

尖端人工智能初创公司Scatter Lab正在打造“社交人工智能聊天机器人”,能够实现引人入胜的、类似人类的对话,他们从头开始训练自己的MPT模型,为定制聊天机器人提供动力。该模型是可以同时理解英语和韩国语的多语言生成人工智能模型之一,为150万名用户提供了新的聊天体验。

全球旅行和费用管理软件公司Navan正在MPT的基础上建立他们的定制LLM。

“在Navan,我们在我们的产品和服务中使用生成式人工智能,为我们的虚拟旅行社和会话式商业智能代理等体验提供动力。MosaicML的基础模型提供了最先进的语言功能,同时在大规模微调和服务推理方面非常有效。我们很高兴看到这项有前途的技术如何发展,”Navan联合创始人兼首席技术官Ilan Twig说。

MPT-30B旨在为那些希望为聊天、问答、摘要、提取和其他语言应用程序构建自己的语言模型的企业加速模型开发。

来源:https://insidebigdata.com/2023/06/28/generative-ai-report-mosaicml-releases-open-source-mpt-30b-llms-trained-on-h100s-to-power-generative-ai-applications/

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消