加速Segment Anything!这一AI方法提升了SAM模型的速度

2023年07月19日 由 daydream 发表

314412

0

长期以来,计算机视觉领域一直在进行图像中的物体检测任务。物体检测算法尝试通过在物体周围画框来定位物体,而分割算法则试图完美地确定物体的边界。图像分割旨在基于语义含义或视觉特征将图像划分为不同的区域或物体。它在许多应用中至关重要,包括物体识别、场景理解、自动驾驶、医学影像等等。

多年来,已经开发出了许多方法和算法来解决这个具有挑战性的问题。最近的进展为我们带来了由深度学习模型驱动的模型。这些现代方法已经取得了显着的进步,实现了最先进的性能,并为图像理解和分析提供了新的可能性。

然而,这些模型存在一个根本性的限制。它们受到训练集中观察到的物体的限制,无法分割其他物体。

然后出现了全新的Segment Anything Model(SAM),彻底改变了图像分割的方式。它作为一种突破性的视觉模型,能够根据用户交互提示,对图像中的任何物体进行分割。它是基于Transformer架构构建的,在广泛的SA-1B数据集上训练,展示了显著的性能,并为一项新颖而令人兴奋的任务“Segment Anything”开辟了新的可能性。凭借其泛化能力和潜力,它有望成为未来广泛视觉应用的基石。

然而,SAM并非完美无缺的。这种强大的能力是以复杂性为代价的,对计算资源要求过高,这使得在实际场景中应用SAM变得具有挑战性。与SAM架构的核心部分相对应,计算资源需求与Transformer模型特别是Vision Transformers(ViTs)相关。

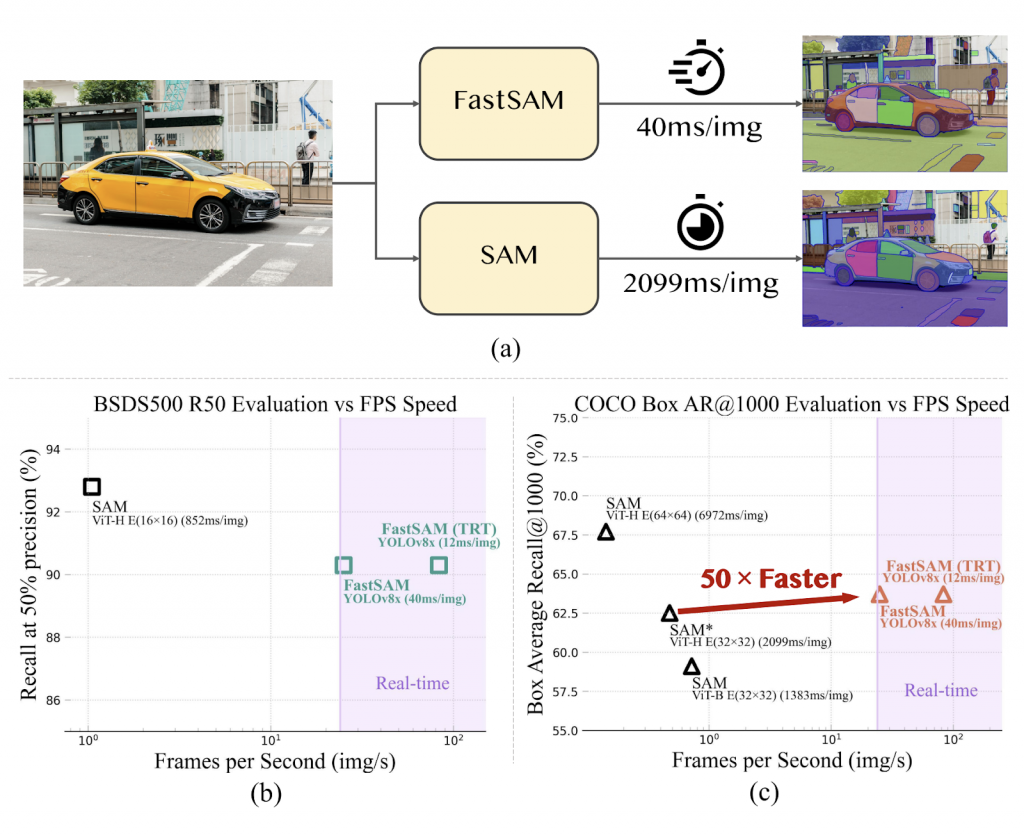

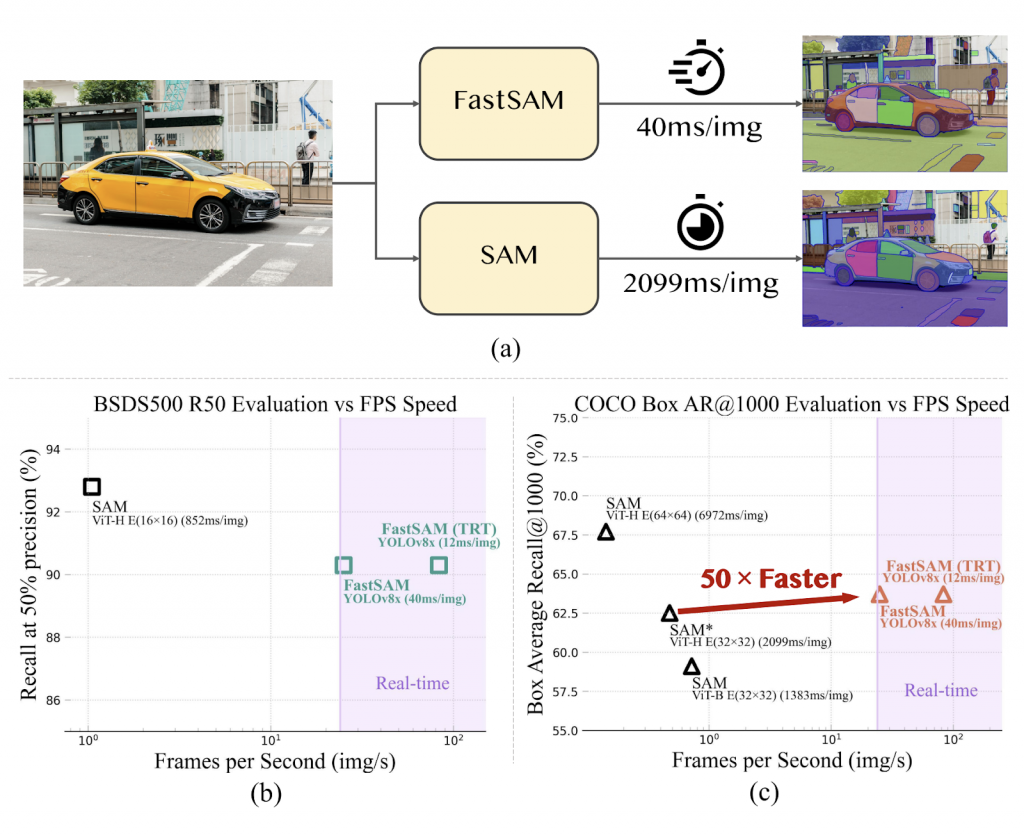

那有没有办法让SAM更快?答案是肯定的,那就是FastSAM。

FastSAM旨在满足SAM模型在工业应用方面的高需求。它成功地大幅提高了SAM的执行速度,并使其能够在实际场景中应用。

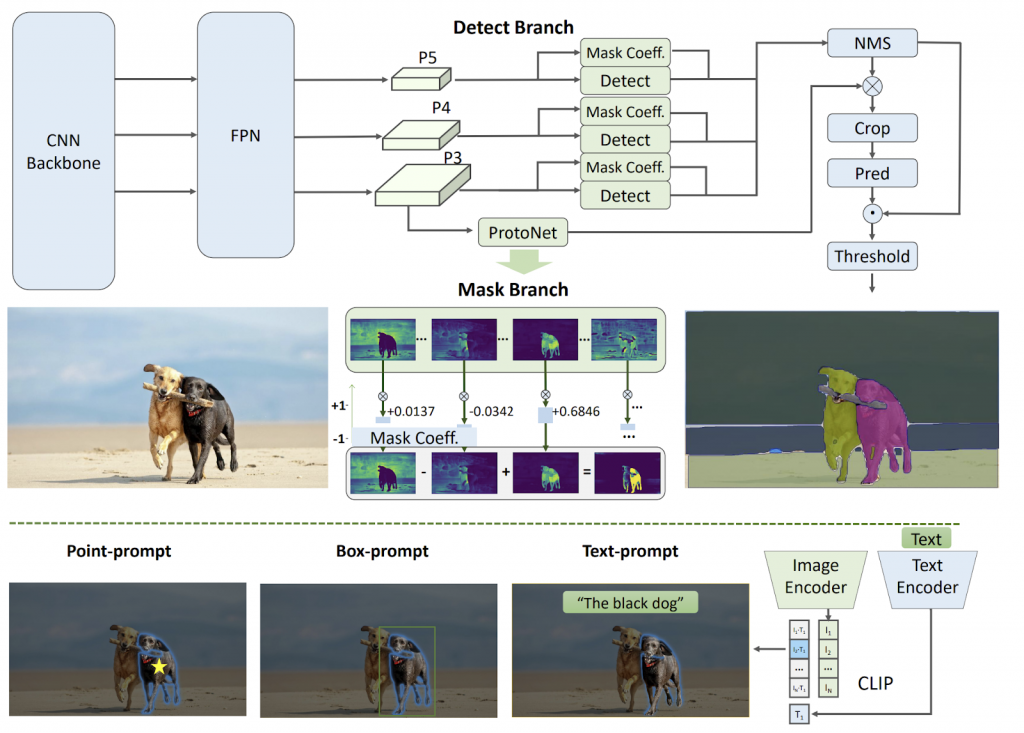

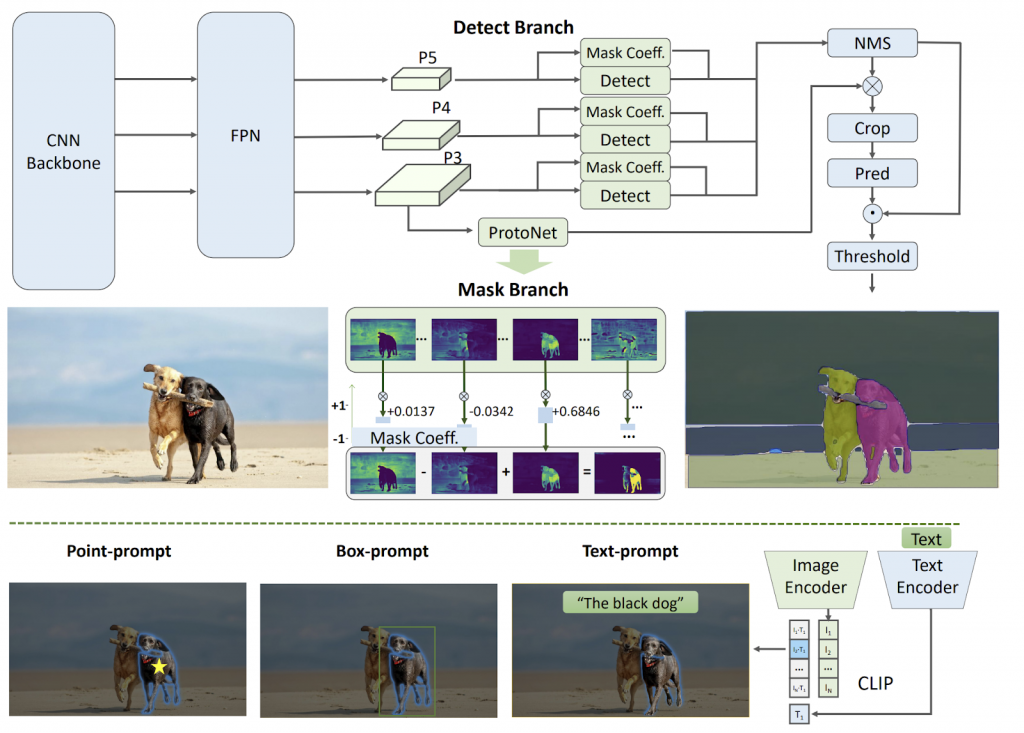

FastSAM将“segment anything”任务分为两个顺序阶段:全实例分割和基于提示的选择。第一阶段利用基于卷积神经网络(CNN)的检测器为图像中的所有实例生成分割掩码。在第二阶段,它输出与用户提示相对应的感兴趣区域。借助CNN的计算效率,FastSAM展示了实时“segment anything”模型的可行性,同时不会牺牲性能质量。

FastSAM基于YOLOv8-seg,这是一个带有实例分割分支的目标检测器,灵感来自于YOLACT方法。通过仅在SA-1B数据集的2%上训练这个CNN检测器,FastSAM在大大降低计算需求的同时,实现了与SAM可比较的性能。该方法在多个下游分割任务中证明了其有效性,包括在MS COCO上的物体提议,其中FastSAM在1000个提议的平均召回率方面优于SAM,同时在单个NVIDIA RTX 3090上的运行速度快了50倍。

来源:https://www.marktechpost.com/2023/07/18/segment-anything-but-faster-this-ai-approach-speeds-up-the-sam-model/

多年来,已经开发出了许多方法和算法来解决这个具有挑战性的问题。最近的进展为我们带来了由深度学习模型驱动的模型。这些现代方法已经取得了显着的进步,实现了最先进的性能,并为图像理解和分析提供了新的可能性。

然而,这些模型存在一个根本性的限制。它们受到训练集中观察到的物体的限制,无法分割其他物体。

然后出现了全新的Segment Anything Model(SAM),彻底改变了图像分割的方式。它作为一种突破性的视觉模型,能够根据用户交互提示,对图像中的任何物体进行分割。它是基于Transformer架构构建的,在广泛的SA-1B数据集上训练,展示了显著的性能,并为一项新颖而令人兴奋的任务“Segment Anything”开辟了新的可能性。凭借其泛化能力和潜力,它有望成为未来广泛视觉应用的基石。

然而,SAM并非完美无缺的。这种强大的能力是以复杂性为代价的,对计算资源要求过高,这使得在实际场景中应用SAM变得具有挑战性。与SAM架构的核心部分相对应,计算资源需求与Transformer模型特别是Vision Transformers(ViTs)相关。

那有没有办法让SAM更快?答案是肯定的,那就是FastSAM。

FastSAM旨在满足SAM模型在工业应用方面的高需求。它成功地大幅提高了SAM的执行速度,并使其能够在实际场景中应用。

FastSAM将“segment anything”任务分为两个顺序阶段:全实例分割和基于提示的选择。第一阶段利用基于卷积神经网络(CNN)的检测器为图像中的所有实例生成分割掩码。在第二阶段,它输出与用户提示相对应的感兴趣区域。借助CNN的计算效率,FastSAM展示了实时“segment anything”模型的可行性,同时不会牺牲性能质量。

FastSAM基于YOLOv8-seg,这是一个带有实例分割分支的目标检测器,灵感来自于YOLACT方法。通过仅在SA-1B数据集的2%上训练这个CNN检测器,FastSAM在大大降低计算需求的同时,实现了与SAM可比较的性能。该方法在多个下游分割任务中证明了其有效性,包括在MS COCO上的物体提议,其中FastSAM在1000个提议的平均召回率方面优于SAM,同时在单个NVIDIA RTX 3090上的运行速度快了50倍。

来源:https://www.marktechpost.com/2023/07/18/segment-anything-but-faster-this-ai-approach-speeds-up-the-sam-model/

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消