优化机器学习:打破数据障碍

介绍

在当今瞬息万变的世界中,技术每天都在进步,机器学习和人工智能通过流程自动化和提高效率的力量彻底改变了各种行业。然而,与传统的机器学习算法相比,人类仍然具有明显的优势,因为这些算法需要数千个样本来响应潜在的相关性并识别对象。

在本文中,我们将探索这些算法背后的概念,并提供对这些学习技术如何工作的全面理解,同时还将揭示实现它们时面临的一些挑战。

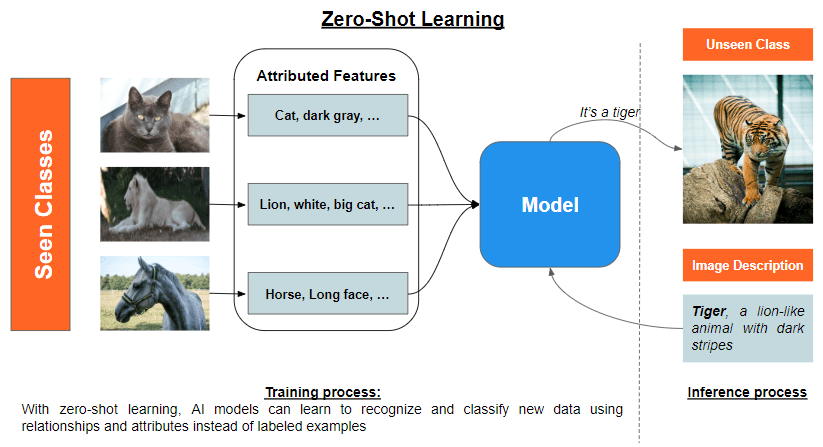

零样本学习是如何工作的?

零样本学习是训练一个模型对它以前从未见过的物体进行分类的概念。核心思想是利用另一个模型的现有知识来获得新类的有意义的表示。

它使用语义嵌入或基于属性的学习以有意义的方式利用先验知识,从而提供对已知和未知类之间关系的高级理解。两者可以一起使用,也可以单独使用。

语义嵌入是单词、短语或文档的向量表示,它在连续的向量空间中捕获潜在的含义和关系。这些嵌入通常是使用无监督学习算法生成的,例如Word2Vec、GloVe或BERT。目标是创建语言信息的紧凑表示,其中相似的含义用相似的向量编码。通过这种方式,语义嵌入允许对文本数据进行有效和准确的比较和操作,并通过将实例投射到连续的共享语义空间中来推广到未见过的类。

基于属性的学习可以对未见过的类中的对象进行分类,而无需访问这些类的任何标记示例。它将对象分解为它们有意义的和明显的属性,这些属性作为中间表示,允许模型在可见类和不可见类之间建立对应关系。这个过程通常包括属性提取、属性预测和标签推段。

1. 属性提取涉及为每个对象类派生有意义的和可区分的属性,以弥合低级特征和高级概念之间的差距。

2. 属性预测包括学习实例的低级特征和高级属性之间的对应关系,使用机器学习技术识别特征之间的模式和关系,以推广到新的类。

3. 标签推断涉及使用新实例的预测属性以及属性与未见的类标签之间的关系来预测新实例的类标签,而不依赖于标记的示例。

尽管零样本学习有很大的潜力,但仍然存在一些挑战,例如:

领域适应:目标领域中的实例分布可能与源领域中的实例分布有很大不同,从而导致为可见类和未见类学习的语义嵌入之间存在差异。这种域转移可能会损害性能,因为模型可能无法在跨域的实例和属性之间建立有意义的对应关系。为了克服这一挑战,人们提出了各种领域自适应技术,如对抗性学习、特征解缠和自监督学习,旨在使源域和目标域中的实例和属性的分布保持一致。

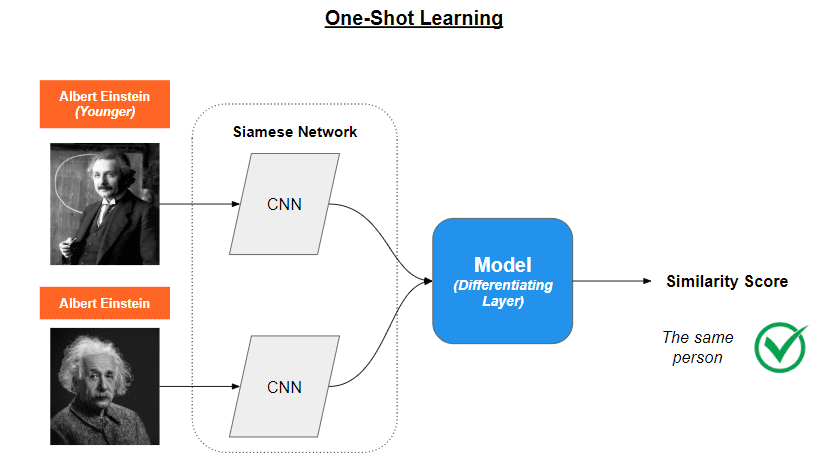

一次性学习是如何工作的?

在开发传统神经网络的过程中,例如识别汽车,模型需要从不同角度和不同对比度捕获数千个样本,才能有效地区分它们。一次性学习采用了不同的方法。该方法不是识别有问题的汽车,而是确定图像A是否等同于图像b。这是通过推广模型从以前的任务中获得的信息来获得的。单次学习主要用于计算机视觉。

用于实现这一目标的技术包括记忆增强神经网络(MANNs)和暹罗网络。通过独立利用这些技术,一次性学习模型可以快速适应新任务,并且即使数据非常有限也能表现良好,这使得它们适用于获取标记数据可能昂贵或耗时的现实场景。

记忆增强神经网络(MANNs)是一类高级神经网络,旨在从很少的例子中学习,类似于人类如何从一个新对象的实例中学习。人工神经网络通过拥有一个额外的内存组件来实现这一点,该组件可以随时间存储和访问信息。

想象MANN是一个带着笔记本的智能机器人。机器人可以用它的笔记本来记住它以前见过的东西,并利用这些信息来理解它遇到的新事物。这有助于机器人比常规的人工智能模型更快地学习。

另一方面,连体网络旨在通过使用两个或多个具有共享权重的相同子网络来比较数据样本。这些网络学习一种特征表示,捕捉数据样本之间的本质差异和相似性。

把暹罗网络想象成一对总是一起工作的双胞胎侦探。他们分享相同的知识和技能,他们的工作是比较两个项目,决定它们是相同的还是不同的。这些侦探观察每件物品的重要特征,然后比较他们的发现来决定。

暹罗网络的训练分为两个阶段:验证阶段和泛化阶段。

1. 在验证过程中,网络判断两个输入的图像或数据点是否属于同一类。该网络使用双子网分别处理两个输入。

2. 在泛化过程中,模型通过有效地学习可以区分不同类别的特征表示来泛化其对输入数据的理解。

一旦这两个阶段完成,该模型就能够确定图像A是否与图像B相对应。

一次性学习是非常有前途的,因为它不需要再训练来检测新的类。然而,它面临着挑战,比如高内存需求和对计算能力的巨大需求,因为学习需要两倍的操作。

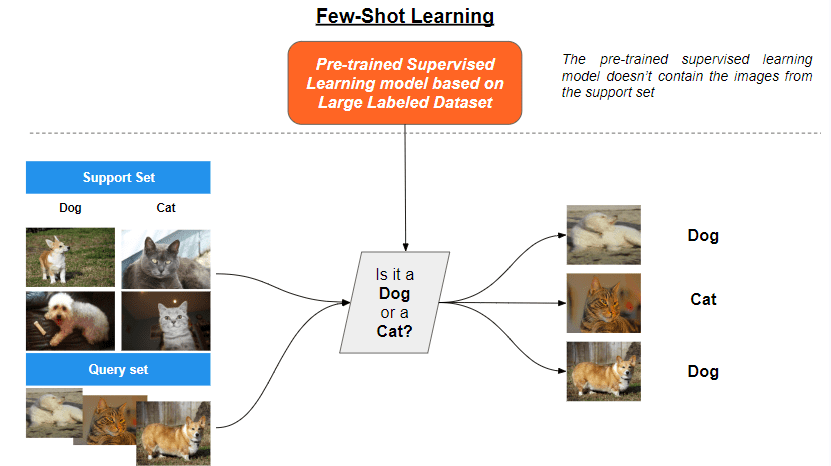

少样本学习是如何工作的?

最后要介绍的学习方法是少样本学习,这是元学习的一个子领域,旨在开发能够从几个标记示例中学习的算法。

在这种背景下,原型网络和模型无关元学习(MAML)是两种突出的替代技术,已经在少量的学习场景中证明了成功。

原型网络

原型网络是一类针对少量分类任务而设计的神经网络。核心思想是为特征空间中的每个类学习一个原型,或一个代表性的例子。原型通过比较新输入和学习原型之间的距离作为分类的基础。

主要包括三个步骤:

1. 嵌入:网络使用神经网络编码器计算每个输入的嵌入,例如卷积神经网络(CNN)或循环神经网络(RNN)。嵌入是捕获输入数据显著特征的高维表示。

2. 原型计算:对于每个类,网络通过对支持集的嵌入取平均值来计算原型,支持集是每个类的标记示例的一个小子集。原型代表了类在特征空间中的“中心”。

3. 分类:给定一个新的输入,网络计算其嵌入,并计算输入嵌入与原型之间的距离(如欧几里得距离)。然后将输入分配给具有最接近原型的类。

学习过程涉及最小化损失函数,该损失函数鼓励原型更接近其各自类的嵌入,而远离其他类别的嵌入。

与模型无关元学习(MAML)

MAML是一种元学习算法,旨在找到模型参数的最佳初始化,这样它就可以通过几个梯度步骤快速适应新的任务。MAML是模型不可知的,这意味着它可以应用于任何用梯度下降训练的模型。

MAML包括以下步骤:

1. 任务抽样:在元训练过程中,任务从任务分布中抽样,其中每个任务都是带有几个标记示例的少量学习问题。

2. 特定于任务的学习:对于每个任务,使用任务的训练数据(支持集)通过一些梯度步骤对模型的参数进行微调。这将产生具有更新参数的特定于任务的模型。

3. 元学习:元目标是最小化所有任务的验证数据(查询集)上特定于任务的损失总和。通过梯度下降更新模型的初始参数来实现这一目标。

4. 元测试:在元训练之后,可以利用学习到的初始化,通过几个梯度步骤快速调整模型以适应新的任务。

MAML需要大量的计算资源,因为它涉及多个嵌套的梯度更新,这带来了挑战。其中一个挑战就是任务多样性。在许多少量的学习场景中,模型必须适应广泛的任务或类,每个任务或类只有几个例子。这种多样性使得开发一种能够有效处理不同任务或类而无需大量微调或调整的单一模型或方法变得具有挑战性。

结论

机器学习世界给我们带来了突破性的技术,比如零样本学习、单样本学习和少样本学习。这些方法允许人工智能模型只需要少量的例子就能学习和识别物体或模式,就像人类一样。这为医疗保健、零售和制造业等各个行业开辟了一个充满可能性的世界,在这些行业中,访问大量标记数据并不总是一件奢侈的事情。