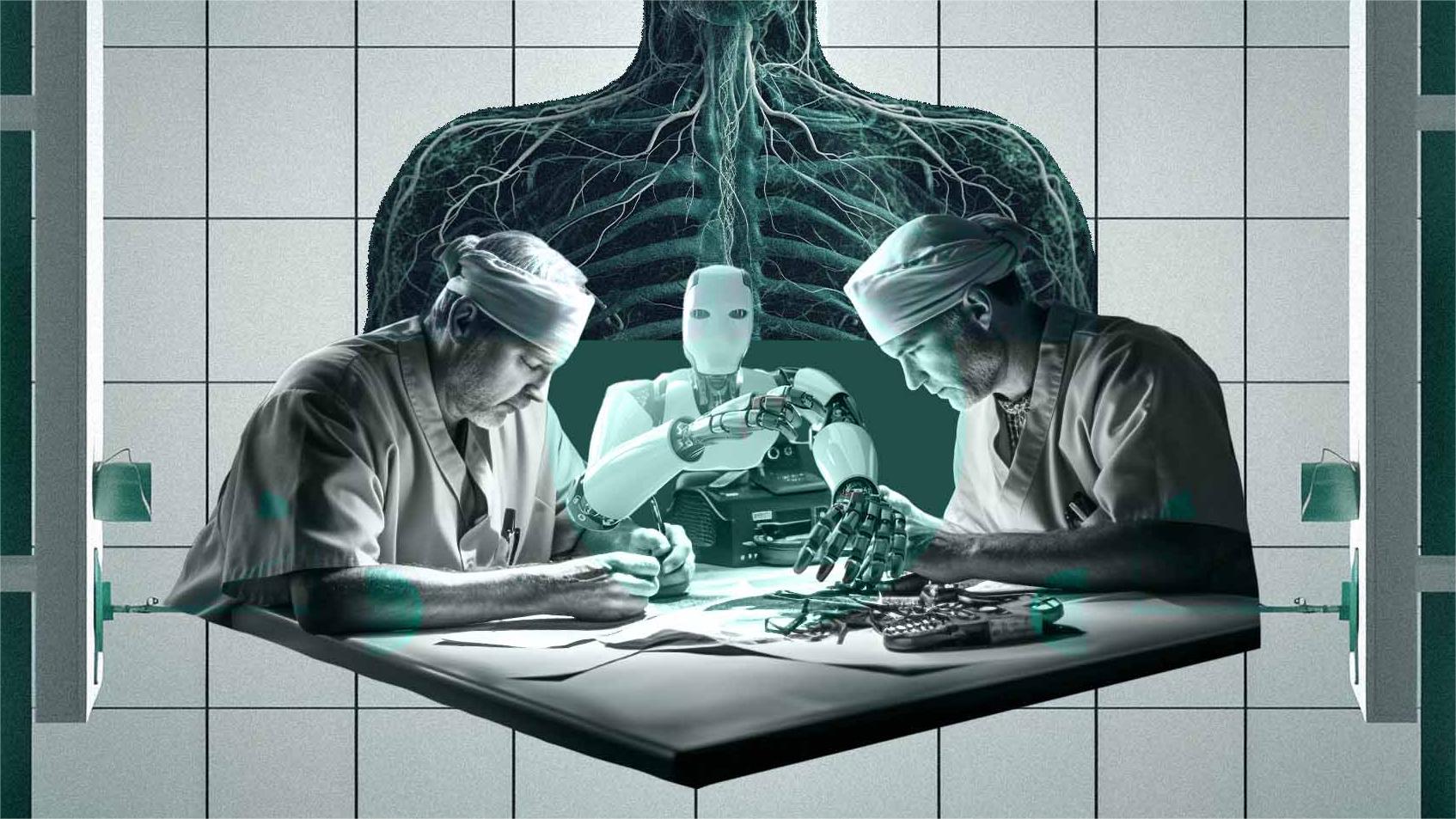

GoogleAI帮助医生做出判断

2023年08月04日 由 samoyed 发表

645

0

在共同努力下,Google DeepMind和Google Research发表了一篇论文,承诺提供更安全的医学成像解释,将误报率降低25%。

AI已经改变了许多行业的面貌,AI的应用进展缓慢。AI在该行业的应用面临着一些挑战,例如数据隐私、安全性、缺乏互操作性以及缺乏监管,这些因素限制了其应用。

AI模型容易出错,正如我们所知,人类也会犯错。Google研究院提出了一个问题,当把预测性AI模型和临床医生的专业知识结合起来时,错误率会是多少?

今年7月,Google DeepMind与Google Research携手推出了Complimentary-driven-Deferral-to-Clinical-Workflow(CoDoC),该系统将人类专业知识与预测性AI相结合,以最大限度地提高准确性。该系统可以判断AI模型是否比临床医生的诊断更准确。

对使用多个真实世界数据集进行的CoDoC综合测试显示,结合人类专业知识和预测性AI的结果可提供更高的准确性。他们发现,在乳腺X线摄影数据集中,假阳性率降低了25%,更重要的是,没有漏掉任何真阳性病例。

这篇发表的论文是AI和临床医生之间合作的重大进步。它有望提高诊断具有二元结果的疾病的准确性。他们的数据集侧重于使用X射线乳房X光检查进行乳腺癌筛查和使用胸部X射线进行结核病检测的分诊。

避开医学中的AI障碍

在医疗环境中使用AI工具时,知道何时说“我不知道”至关重要。该论文解决了何时承认不确定性,然后将权力交给临床医生的关键挑战。参与这项研究的英国Google健康公司的Alan Karthikesalingam说:“如果将CoDoC与AI工具和放射科医生的判断结合起来使用,然后CoDoC帮助决定使用哪种意见,那么结果的准确性就会比单独使用人或AI工具更好。”

CoDoC模型也不需要患者的医学图像来做出诊断。这照顾了患者的隐私。在训练数据集时,每种情况只需要三个输入。首先是医院自己现有的预测AI可信度评分的输出(0表示确定不存在疾病,1表示确定存在疾病)。第二是非AI专家临床工作流程的输出,最后是历史“真实”数据。

该系统可以与任何专有的AI模型兼容,并不需要访问模型的内部工作或训练数据。为了将CoDoC范式应用于现有的预测性AI系统,研究人员将按照论文中描述的方法进行操作,即使用其自己现有的预测性AI系统的输出来训练一个类似CoDoC的模型。

预测性模型的工作原理

它通过将预测性AI模型的准确性与医生解释的准确性进行比较来学习,然后检查准确性如何随预测性AI模型的可信度分数而变化。

在经过训练后,CoDoC被放置在一个假设的临床工作流程中,与预测性AI和医生一起工作。当预测性AI模型评估新的患者图像时,其关联的可信度得分被输入到CoDoC中。

通过将AI作为确认诊断的有效工具,即使在极端情况下,医生也可以对自己的诊断充满信心,这是以前无法做到的。

“CoDoC的优势在于它可以与各种专有的AI系统互操作,”Google DeepMind的Krishnamurthy Dvijotham说。

邀请开发人员进行测试、验证和构建

为了帮助研究人员在他们的工作基础上,保持透明,并确保在现实世界中使用更安全的AI模型,他们在Github上开源了CodoC的代码。

到目前为止,这项工作还只是理论上的,但研究人员表示,它显示了AI系统在不同人口、临床环境、使用的医疗成像设备和疾病类型上适应和提高医学成像性能的潜力。

文章来源:https://analyticsindiamag.com/google-ai-helps-doctors-decide-when-to-trust-ai-diagnoses/

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消