减少虚假相关性的自监督推荐算法

近年来,自监督学习(SSL)在推荐算法系统中取得了巨大成功。然而,SSL推荐模型可能会受到虚假相关性的影响,从而导致较差的泛化能力。为了减小虚假的相关性,现有研究通常采用基于ID的SSL推荐算法或利用特征工程来识别虚假的特征。

然而,基于ID的SSL方法牺牲了不变特征的优势,而特征工程方法需要较高的人工标记成本。在Machine Intelligence Research上发表的一篇论文中,一组研究人员通过自动减轻虚假相关性的影响,以解决这些问题。这一目标要求在不受监督的情况下自动屏蔽虚假特征,并阻止虚假特征在SSL过程中向其他特征传递负面影响。

自我监督学习(SSL)方法最近已经成为个性化推荐的最先进方法(SOTA)。SSL在推荐中的核心方法是通过一个额外的自我区分任务来学习更好的用户和项目表示,该任务对比用户—项目特征或用户—项目交互图的增强,以发现特征和交互之间的相关关系。

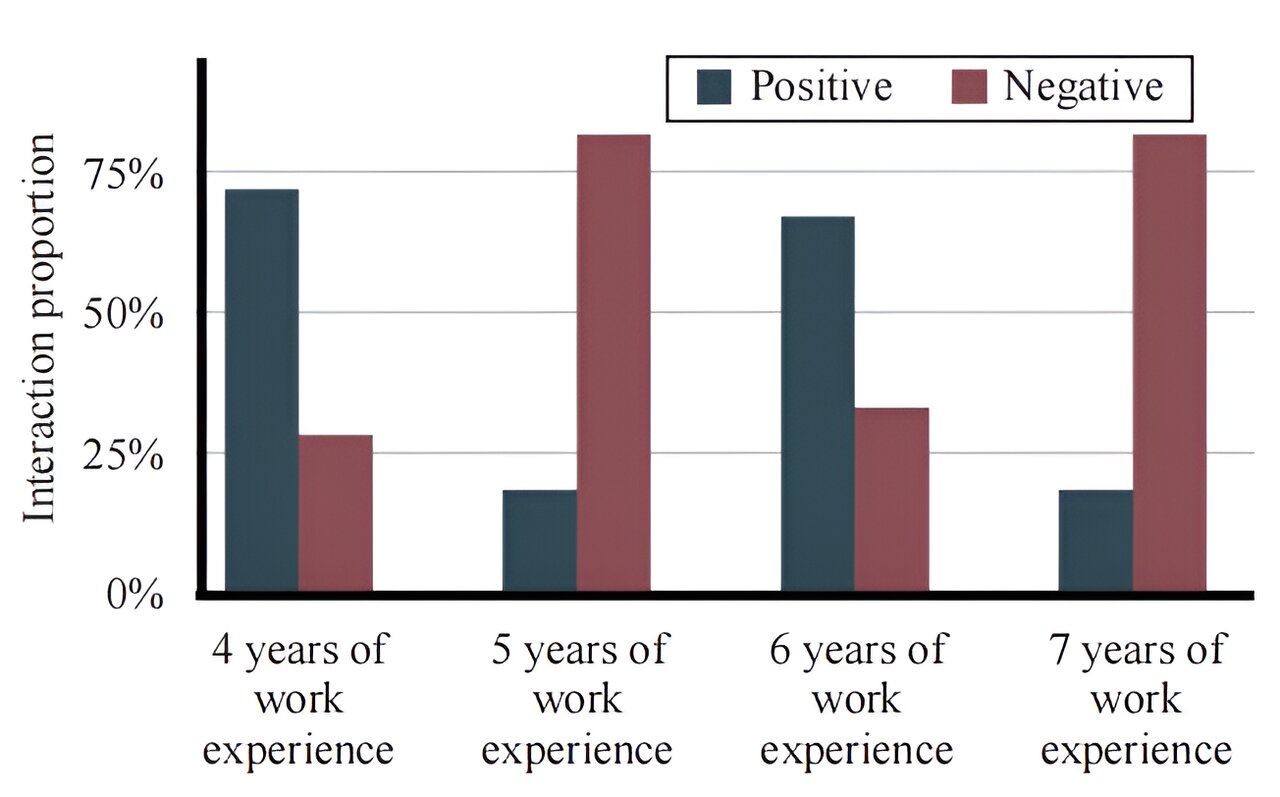

尽管取得了巨大的成功,但基于SSL的推荐模型由于拟合输入特征与交互之间的相关性而容易受到虚假相关性的影响。由于数据收集过程中的选择偏差,训练数据中不可避免地存在虚假相关性,其中一些虚假特征与用户的积极交互表现出很强的相关性。通过自我区分任务,SSL模型容易捕获这些虚假的相关性,导致泛化能力差。

为了减轻虚假关联对SSL模型的有害影响,现有的解决方案主要有三类:一是基于ID的SSL方法,它只利用用户和项目的ID进行协同过滤,从而避免了某些虚假特征的有害影响。然而,用户和项目特征在推荐中仍然很有用,特别是对于交互较少的用户。有必要考虑一些对相互作用有因果影响的不变特征。

第二种是特征工程方法,它能够手动或使用人机混合方法识别一组虚假特征。然后,他们可以通过丢弃已识别的特征来训练SSL推荐模型。然而,特征工程方法需要大量的人工标记工作,因此不适用于具有大量用户和项目特征的大规模推荐。

三是信息特征选择方法,能够在训练过程中自动识别信息交叉特征并去除冗余特征。然而,在训练数据的交互预测中,虚假特征可能是非常有用的信息,从而降低了泛化能力。

为了解决这些问题,就需要SSL模型能够自动减轻虚假关联的影响。为了实现这一目标,存在两个基本挑战:第一个是在没有监督的情况下屏蔽虚假特征。另一个挑战是阻止虚假特征对其他特征的影响传播。

为了解决这两个挑战,研究人员考虑从多个环境中学习特征屏蔽机制来估计虚假特征的概率,然后采用屏蔽机制来指导SSL模型中的特征增强。具体来说,研究人员可以将相互作用聚类到多个环境中,每个环境具有相似的特征分布,但分布在不同的环境之间会发生变化。分布的变化将引导屏蔽机制捕捉跨环境的不变特征,并排除虚假特征。此外,它们还可以利用屏蔽机制将虚假特征作为增强样本丢弃,从而最大化增强样本中不变特征与事实样本中所有输入特征之间的互信息,从而推动SSL模型忽略虚假特征,切断虚假特征向不变特征的负面影响传递。

为此,研究人员为SSL推荐模型提出了一个不变特征学习(IFL)框架,以减轻虚假相关性。特别是,IFL将训练交互聚类到多个环境中,并利用[0,1]中具有可学习参数的屏蔽机制来屏蔽虚假相关性。为了优化屏蔽机制,IFL采用方差损失来识别不变性特征,并实现跨环境的鲁棒预测。

在自分辨任务中,研究人员将基于屏蔽机制的虚假特征作为增强样本,然后通过对比损失最大化事实样本和增强样本之间的互信息,从而使SSL模型忽略虚假特征。他们在SOTA SSL模型上实例化了IFL,并在两个真实数据集上进行了大量实验,验证了所提出的IFL在减轻虚假相关性方面的有效性。

本文的贡献总结如下:

首先,研究人员指出了SSL推荐中的虚假相关性,并考虑了从多个环境中学习不变特征。

其次,他们提出了一个模型无关的IFL框架,该框架利用特征屏蔽机制和屏蔽引导的对比学习来减少SSL模型的虚假相关性。

第三,在两个公共数据集上的实证结果验证了他们提出的IFL在屏蔽虚假特征和增强SSL模型泛化能力方面的优越性。