数据清洗在数据科学中的重要性

在数据科学中,预测模型的准确性非常重要,以确保避免任何高昂的错误,并确保每个方面都能发挥最佳水平。一旦数据被选择和格式化,就需要对数据进行清洗,这是模型开发过程中至关重要的阶段。

在本文中,我们将概述数据清洗在数据科学中的重要性,包括清洗的定义,好处,数据清洗过程以及常用工具。

什么是数据清洗?

在数据科学中,数据清洗是识别错误数据并修复错误的过程,以便最终数据集可供使用。错误可能包括重复字段、错误格式、不完整字段、无关或不准确的数据以及损坏的数据。

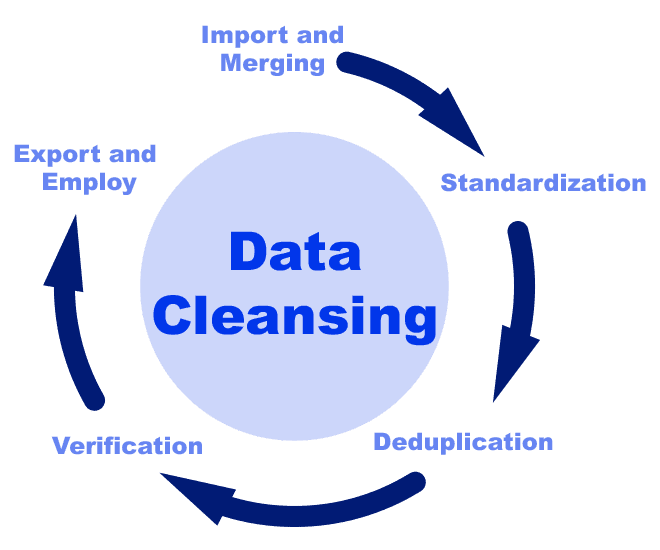

在数据科学项目中,清洗阶段出现在数据管道的验证之前。在数据管道中,每个阶段都会接收输入并创建输出,逐步改进数据。数据管道的好处在于每个步骤都有特定的目的并且是自包含的,这意味着数据经过了彻底的检查。

数据清洗在数据科学中的重要性

数据很少以可直接使用的形式到达;事实上,可以自信的说,数据永远不会完美无缺。当从多个来源和真实环境收集数据时,数据很可能包含许多错误并采用不同的格式。因此,数据清洗的重要性产生——将数据变得无错误、相关和易于模型吸收。

当处理来自多个来源的大型数据集时,可能会出现错误,包括重复或错误分类。这些错误会严重影响算法的准确性。值得注意的是,数据清洗和整理可以占据数据科学家时间的80%,这凸显了它在数据管道中的关键作用。

数据清洗的示例

以下是数据清洗如何修复数据集中的错误的三个示例:

数据格式化

数据格式化涉及将数据转化为特定的格式或修改数据集的结构。确保一致性和良好结构化的数据集对于避免数据分析中的错误非常重要。因此,在清洗过程中采用各种技术以确保准确的数据格式化是必要的。这可能包括将分类数据转化为数字值,将多个数据源合并为一个统一的数据集。

空值/缺失值

数据清洗技术在解决缺失或空值等数据问题方面起着关键作用。这些技术涉及使用相关信息估计和填补数据集中的空缺。

例如,考虑到位置字段。如果该字段为空,则科学家可以使用数据集或类似数据集的平均位置数据填充该字段。虽然不是完美的,但是拥有最有可能的位置信息比没有位置信息要好。这种方法可以确保改进数据质量,提高数据集的整体可靠性。

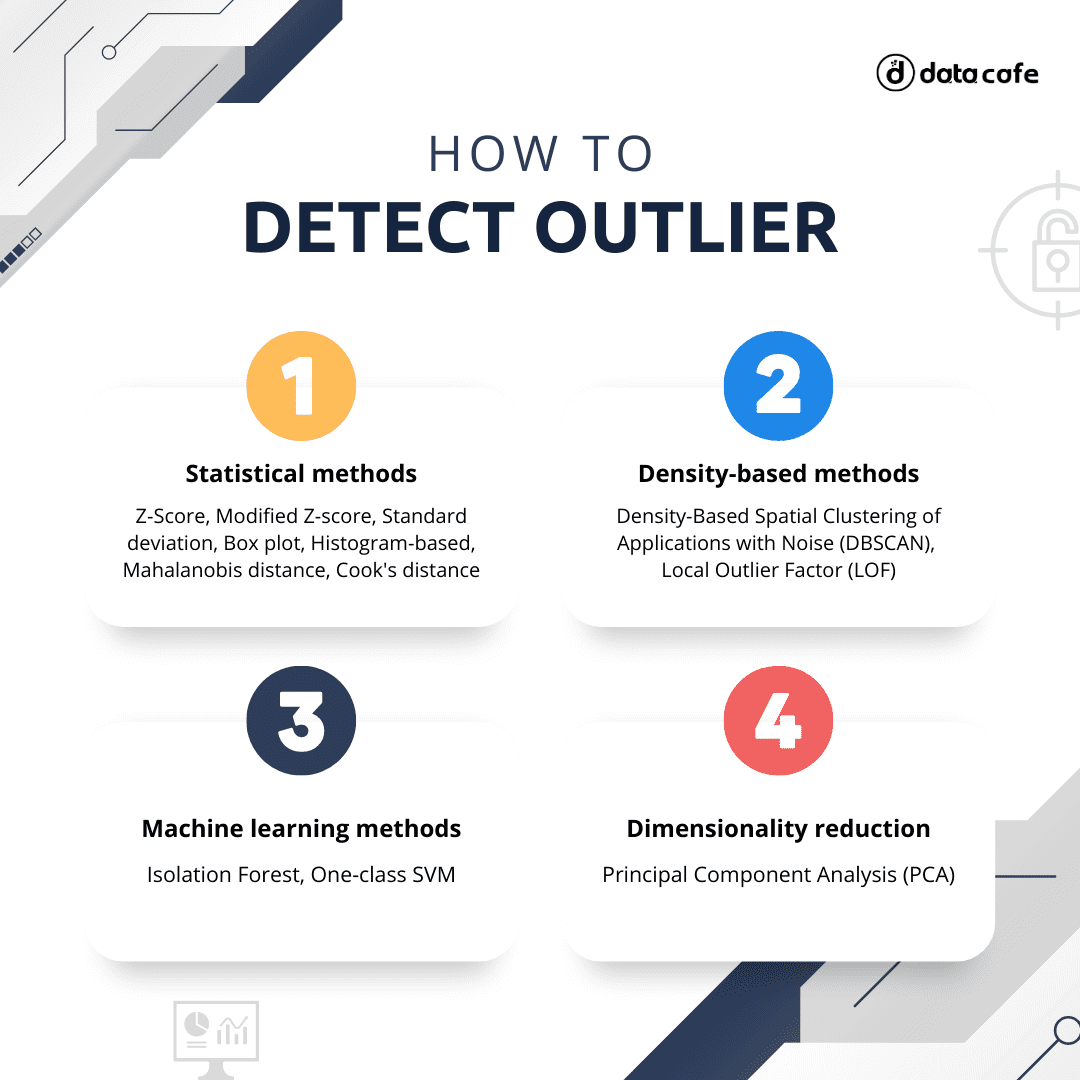

识别异常值

在数据集中,某些数据点可能与其他数据点(例如值或行为)缺乏任何实质性联系。因此,在数据分析中,这些异常值可能会显著扭曲结果,导致错误的预测和错误的决策。然而,通过实施各种数据清洗技术,可以识别和消除这些异常值,从而确保数据集的完整性和相关性。

数据清洗的好处

数据清洗提供了一系列益处,对数据的准确性、相关性、可用性和分析有着重大影响。

- 准确性—使用数据清洗工具和技术显著减少数据集中的错误和不准确性。这对于数据分析非常重要,有助于创建能够进行准确预测的模型。

- 可用性—清洗和正确格式化后,数据可以应用于多种用例,使其更易于访问,可以在多种项目类型中使用。

- 分析—清洁的数据使分析阶段更加有效,使分析师能够获得更多的洞察力并提供更可靠的结果。

- 高效的数据存储—通过删除不必要和重复的数据,可以降低存储成本,因为只需要保留相关、有价值的数据,无论是在现场服务器还是云数据仓库上。

- 管理—数据清洗可以帮助组织遵守严格的法规和数据治理,保护个人的隐私并避免任何处罚。最近几个月出台了更多的数据合规法律。一个例子是最近通过的德克萨斯州消费者隐私法 (TDPSA),禁止某些数据实践,例如收集个人客户数据,而这些数据对于收集目的来说不是合理必要的。

数据清洗过程:8个步骤

数据管道中的数据清洗阶段由八个常见步骤组成:

- 删除重复数据

- 删除无关数据

- 标准化大小写

- 数据类型转换

- 处理异常值

- 修复错误

- 语言翻译

- 处理任何缺失值

1.删除重复数据

使用多个数据源的大型数据集很可能存在错误,包括重复数据,特别是当新条目尚未经过质量检查时。重复数据是冗余的,占用了不必要的存储空间,需要数据清洗来提高效率。常见的重复数据包括重复的电子邮件地址和电话号码。

2.删除无关数据

为了优化数据集,必须删除无关的数据字段。这将使模型处理更快,并能更专注地实现特定的目标。在数据清洗阶段,将删除与项目范围不符的任何数据,只保留完成任务所需的必要信息。

3.标准化大小写

对数据集中的文本进行标准化对于确保一致性并方便分析非常重要。纠正大小写特别重要,因为它可以避免创建虚假的类别,从而导致数据混乱和困惑。

4.数据类型转换

当使用Python处理CSV数据时,分析师通常依赖于Pandas,这是一种常用的数据分析库。然而,在处理数据类型时,Pandas有时无法有效处理数据类型。为了确保准确的数据转换,在进行实际项目时,分析师会采用清洗技术。这可以确保正确的数据在应用于实际项目时能够轻松识别。

5.处理异常值

异常值是与其他数据点缺乏相关性的数据点,与数据集的整体背景显著偏离。虽然异常值有时可能提供有趣的洞察力,但它们通常被视为应该删除的错误。

6.修复错误

确保模型的有效性非常重要,在进行数据分析阶段之前纠正错误至关重要。这些错误通常是由于没有适当的检查程序而人工录入数据导致的。例如,错误的电话号码、没有“@”符号的电子邮件地址或者没有标点符号的用户反馈等。

7.语言翻译

数据集可以从不同语言的各种来源收集。然而,当使用这些数据进行机器翻译时,评估工具通常依赖于单语自然语言处理(NLP)模型,这些模型一次只能处理一种语言。幸运的是,在数据清洗阶段,人工智能工具可以将所有数据转换为统一的语言。这确保了翻译过程中的更高连贯性和兼容性。

8.处理任何缺失值

数据清洗的最后一个步骤之一是处理缺失值。可以通过删除具有缺失值的记录或使用统计技术来填补空白来实现。在做出这些决策时,对数据集的全面了解非常重要。

总结

在数据科学中,数据清洗的重要性不可低估,它可以极大地影响数据模型的准确性和整体成功。通过彻底的数据清洗,可以避免在数据分析阶段输出错误结果和不准确的预测。

在数据清洗阶段需要修复的常见错误包括重复数据、缺失值、无关数据、异常值以及将多种数据类型或语言转化为单一形式。