谷歌的Symbol Tuning微调技可以在LLM中进行情境学习

由于语言模型的扩展,机器学习经历了一次革命性的飞跃,使得通过上下文学习完成具有挑战性的推理任务。然而,问题仍然存在:语言模型对提示变化表现出敏感性,这表明缺乏稳健的推理能力。这些模型通常需要大量的提示工程或指导性措辞,甚至表现出特殊的行为。在他们的最新研究中,谷歌揭示了人类智能的一个基本特征:通过几个例子推理来学习新任务的能力。

谷歌的突破性论文题为“符号调整改善语言模型中的上下文学习”,介绍了一种称为符号调整的创新微调方法。该技术强调了输入标签映射,从而显著增强了跨不同场景的Flan-PaLM模型的上下文学习。

符号调优

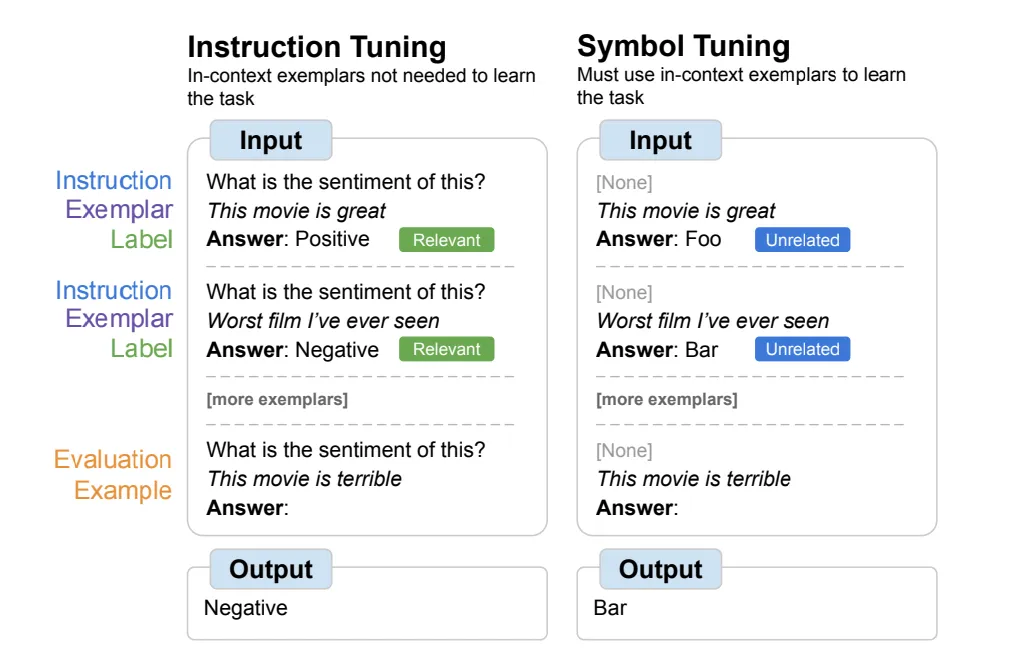

谷歌研究院引入了“符号调优”,这是一种有效的微调技术,解决了传统指令调优方法的局限性。虽然指令调优可以增强模型性能和上下文理解,但它有一个缺点:模型可能不会被迫从示例中学习,因为任务是通过指令和自然语言标签冗余定义的。例如,在情感分析任务中,模型可以简单地依赖于提供的指令,而完全忽略示例。

符号调优证明对以前未见过的上下文学习任务特别有益,在传统方法因缺乏指令或自然语言标签的未指定提示而失效的情况下表现出色。此外,用符号调整的模型在算法推理任务中表现出非凡的能力。

最显著的结果是在处理上下文中呈现的翻转标签方面有了实质性的改进。这一成就突出了该模型利用上下文信息的卓越能力,甚至超越了已有的知识。

符号调优提供了一种补救方法,通过对缺乏指令的示例进行微调模型,并用语义无关的标签(如“Foo”、“Bar”等)替换自然语言标签。在这种设置中,如果不参考上下文示例,任务就会变得模棱两可。对这些例子进行推理对成功至关重要。因此,符号调优模型在需要在上下文示例及其标签之间进行细致推理的任务上表现出更好的性能。

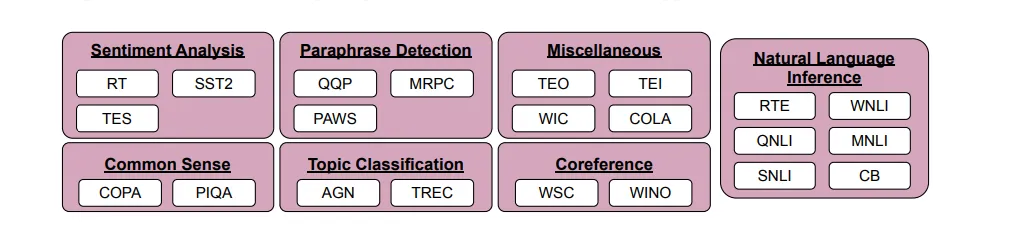

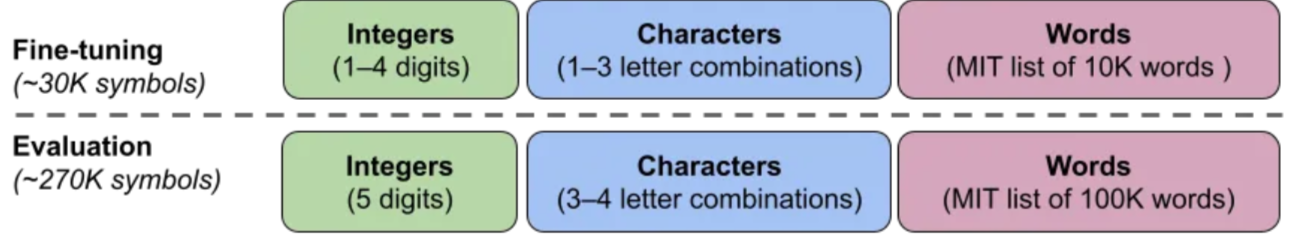

为了评估符号调优的有效性,研究人员利用了22个公开可用的自然语言处理(NLP)数据集,其中包含分类类型的任务,考虑了离散标签。标签被重新映射为从大约30,000个任意标签池中随机选择的标签,这些标签属于三类:整数、字符组合和单词。

实验涉及在Flan-PaLM模型上的符号调整,特别是Flan-PaLM-8B、Flan-PaLM-62B 和 Flan-PaLM-540B。此外,对Flan-cont-PaLM-62B(简称62B-c)进行了测试,以1.3万亿代币的规模代表Flan-PaLM-62B,而不是通常的7800亿代币。

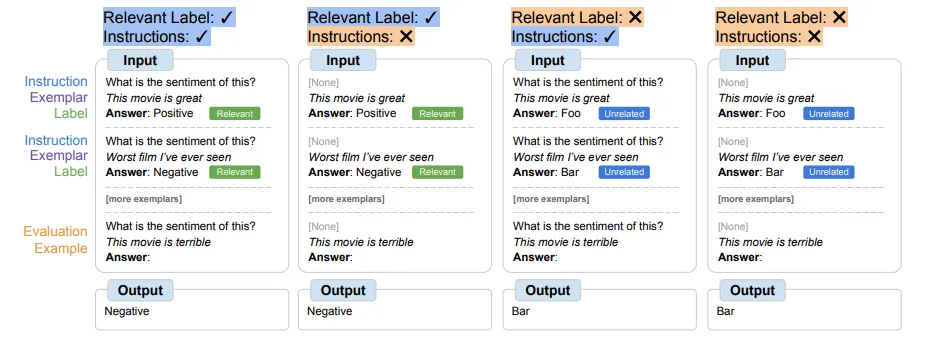

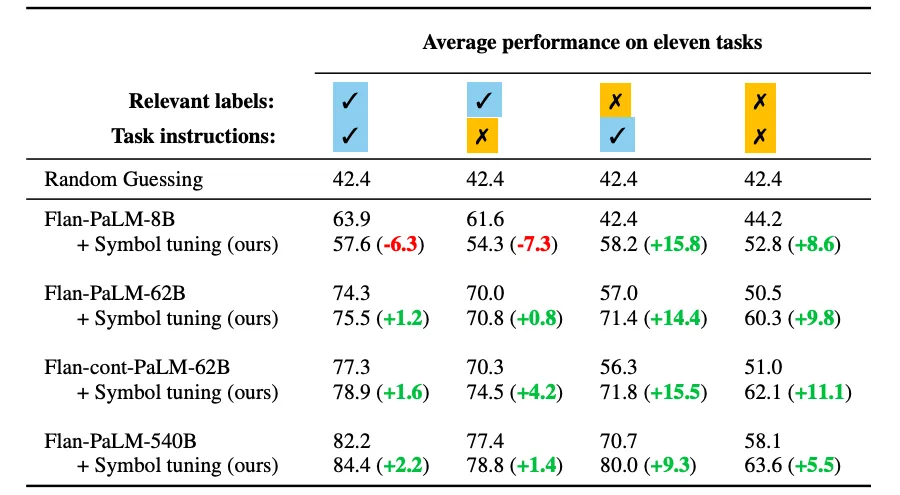

符号调优过程需要模型与上下文示例进行推理,以有效地执行任务,因为提示的设计是为了防止仅从相关标签或说明中学习。符号调优模型在需要在上下文示例和标签之间进行复杂推理的设置中表现出色。为了探索这些设置,定义了四个上下文学习场景,改变了学习任务所需的输入和标签之间的推理水平(取决于指令/相关标签的可用性)。

结果表明,在62B及更大模型的所有设置中,性能都得到了改善,在有相关自然语言标签的设置中有适度的增强(范围从+0.8%到+4.2%),在没有这些标签的设置中有实质性的改善(范围从+5.5%到+15.5%)。值得注意的是,当相关标签不可用时,符号调优的Flan-PaLM-8B的性能超过了Flan-PaLM-62B,而符号调优的Flan-PaLM-62B的性能优于Flan-PaLM-540B。这表明符号调优使较小的模型能够在这些任务上匹配较大模型的性能,从而显着降低了推理计算需求(大约节省了10倍的计算)。

一般来说,符号调优在上下文学习任务中显示出显著的改进,特别是对于未指定的提示。该技术在推理任务中也表现出比传统微调更强的性能,并且更能够使用内容内信息来覆盖先验知识。总的来说,符号调优可以成为最有趣的微调技术之一。