AI超级芯片对决:NVIDIA GH200 vs Intel Gaudi2 vs AMD M1300X

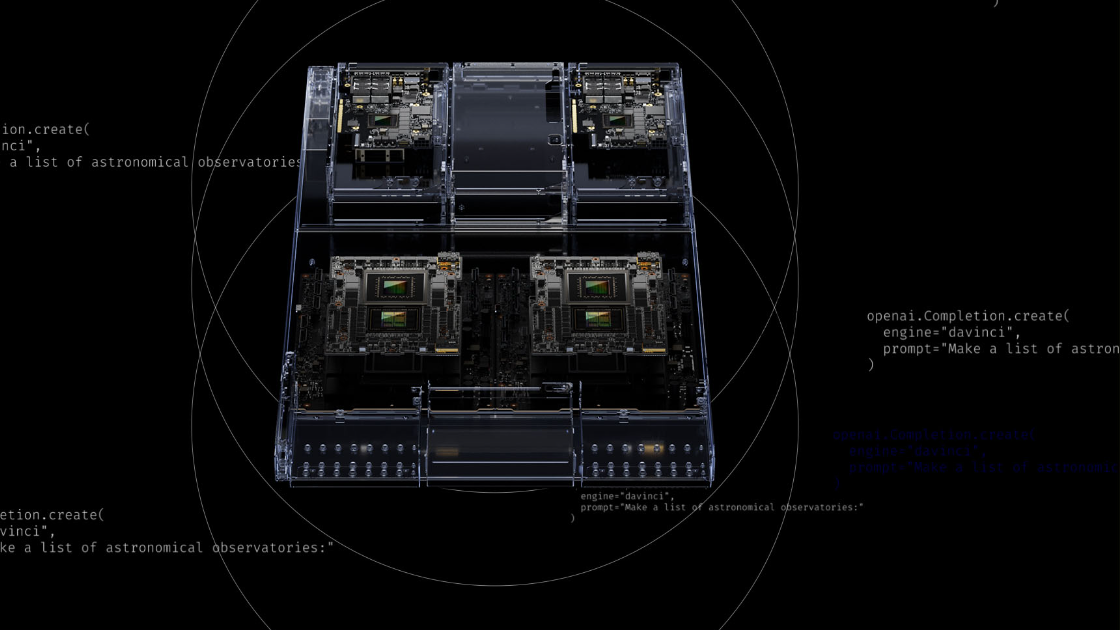

NVIDIA最近宣布了其最新创新,即下一代NVIDIA GH200 Grace Hopper平台。该平台以一款创新的Grace Hopper超级芯片为核心,采用世界上首屈一指的HBM3e处理器。

这个全新的配置是一个改变游戏规则的举措,提供了当前版本3.5倍的内存容量和3倍的带宽。该配置包括一个拥有144个Arm Neoverse核心的单个服务器,提供8个AI浮点运算,拥有282GB最新的HBM3e内存技术。

该技术经过精心设计,以满足快速计算和令人兴奋的生成AI领域的需求。HBM3e内存比现有HBM3快50%,总带宽达到10TB/秒,使新平台能够运行比之前版本大3.5倍的模型,并通过3倍更快的内存带宽提高性能。NVIDIA表示,预计将在2024年第二季度推出这款新的AI芯片。

该新平台使用了Grace Hopper超级芯片,可以通过NVIDIA NVLink与其他超级芯片连接,使它们能够共同部署用于生成AI的巨型模型。这种高速、协同的技术使GPU能够完全访问CPU内存,在双重配置时提供1.2TB的快速内存。

领先AMD和Intel

NVIDIA的新一代GH200要比预计于今年晚些时候推出的AMD 1300X更好。最近,为了与NVIDIA竞争,AMD在M1300X中增加了额外的64GB HBM3内存。

M1300X将CNA3与领先行业的192GB HBM3内存结合在一起,提供5.2TB/秒的内存带宽,而GH200提供的带宽是10TB/秒。NVIDIA不仅超过了AMD,还使Intel远远落后,后者近来一直在努力追赶训练LLM的GPU的竞赛。

GH200要远超Intel的Gaudi2。Gaudi2的内存子系统包括96GB HBM2E内存,提供2.45TB/秒的带宽,此外还有48MB的本地SRAM,具有足够的带宽,可以使MME、TPC、DMAs和RDMA NICs并行操作。

在同样的趋势下,Intel今年宣布进军AI芯片领域,准备与NVIDIA和AMD竞争。即将推出的Intel“Falcon Shores”芯片预计将展示令人印象深刻的288GB内存容量,同时支持8位浮点计算。

Falcon Shores将使用常规以太网切换,类似于针对AI任务设计的IntelGaudi架构。它将具备各种不同数量的HBM3内存和可适应的I / O,可能意味着不同的内存选项。Intel提到它将提供高达288GB的HBM3内存和总内存速度为9.8TB/秒。

Intel的Falcon Shores已经延迟,计划在2025年推出,只配备GPU核心,而何时引入CPU核心尚不确定。在最新的盈利电话会议上,Intel首席执行官Pat Gelsinger表示,Gaudi3将成为明年的量产产品,他们已经在为2026年的Falcon Shores 2进行工作。

考虑到NVIDIA的GH200计划比Falcon Shore和Falcon Shore 2更早发布,Intel超越NVIDIA的前景似乎是不太可能的。Intel已经制定了一系列雄心勃勃的策略,他们必须成功实施这些策略才能赶超NVIDIA。

软件方面

NVIDIA硬件成功的一个重要方面是CUDA,它实现了并行计算。可以说CUDA是NVIDIA在AI领域的护城河。

为了与CUDA竞争,AMD最近对RocM进行了更新。对于AMD来说,这是一步重要的进展,因为CUDA一直是NVIDIA最大的优势之一,特别是在AI加速工作负载中。

通过RocM可以获得大量的内存带宽,使公司能够购买更少的GPU,这使得AMD对于轻中度AI工作负载的小型公司具有吸引力。类似地,Intel也宣布改进了他们的CUDA替代方案oneAPI。

尽管NVIDIA采取了高端市场策略,但AMD和Intel仍可以继续专注于开源解决方案,以与NVIDIA在小型公司竞争。