认识 AudioCraft:Meta AI 的新生成音频模型系列

音频正迅速成为生成人工智能的新领域之一。在追求生成高保真音频的过程中,Meta AI面临着在不同尺度上建模复杂信号和模式的挑战。在各种音频类型中,音乐尤其令人生畏,因为它融合了本地和远程模式,从单个音符到多种乐器的复杂音乐结构。虽然传统方法依赖于MIDI或钢琴卷等象征性表现,但它们在捕捉音乐内在的表达细微差别和风格丰富性方面存在不足。Meta AI最近推出了AudioCraft,这是一系列用于高质量音频生成的生成AI模型。

AudioCraft模型系列是一项值得注意的成就,它展示了生成具有持久一致性的高质量音频的能力,并提供了一个用户友好的交互界面。与该领域之前的工作相比,AudioCraft简化了音频生成模型的整体设计,为探索Meta多年来开发的最先进模型提供了一个全面的工具包。此外,它使用户能够突破界限并开发自己的定制模型。

AudioCraft基于三个核心模型,即MusicGen, AudioGen和EnCodec。AudioCraft展示了它在生成不同形式音频方面的多功能性。MusicGen接受了meta拥有的和特别授权的音乐训练,可以将基于文本的用户输入转换成令人印象深刻的音乐作品。另一方面,AudioGen经过公开声音效果的训练,熟练地从与环境声音和声音效果相关的文本提示生成音频,例如狗叫、汽车鸣笛声或木地板上的脚步声。

1)音频生成:EnCodec

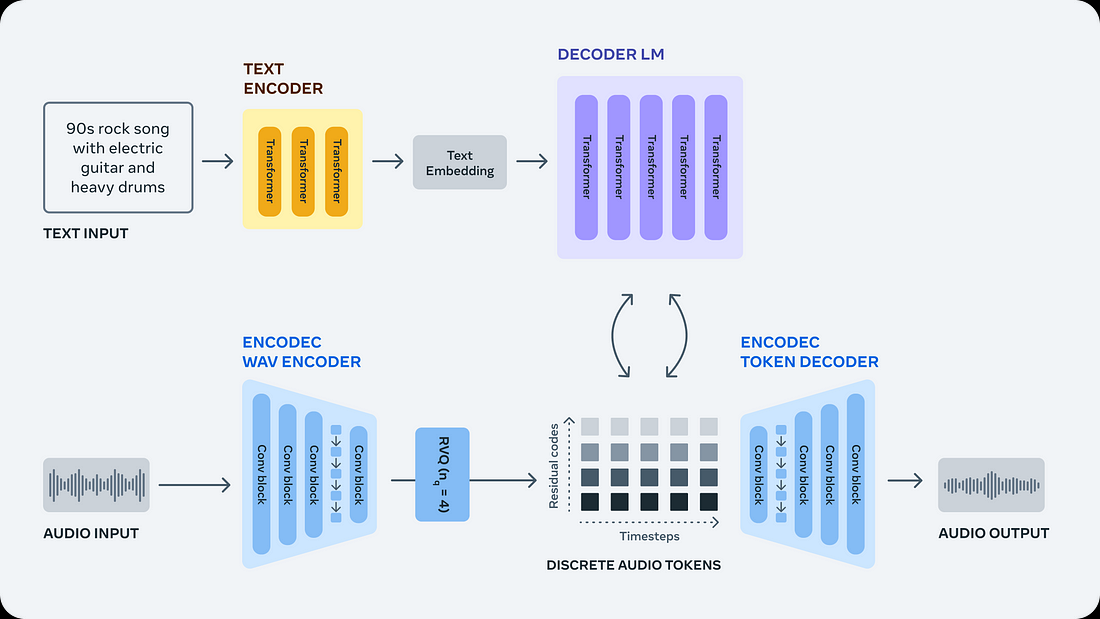

AudioCraft模型需要解决从原始音频信号生成音频的复杂挑战,因为它涉及到对非常长的序列进行建模。一个典型的音乐轨道持续几分钟,以44.1 kHz(音乐录音的标准)采样,包含数百万个时间步长。相比之下,基于文本的生成模型,如Llama和Llama 2,处理作为子词处理的文本,每个样本只代表几千个时间步。

为了解决这种复杂性,Meta AI采用EnCodec神经音频编解码器从原始信号中学习离散音频标记,有效地为音乐样本创建新的固定“词汇表”。通过这种方法,他们可以在这些离散的音频标记上训练自回归语言模型,以生成新的标记、声音和音乐。通过随后使用EnCodec的解码器将这些标记转换回音频空间,它们实现了所需的音频生成。

AudioCraft模型利用EnCodec神经音频编解码器从原始波形中学习离散音频标记。编解码器执行音频信号映射到一个或几个离散令牌的并行流。然后采用单一的自回归语言模型对来自EnCodec的音频标记进行递归建模。然后将这些生成的令牌馈送到编解码器,将它们转换回音频空间并产生最终输出波形。这种方法的灵活性允许使用各种调节模型来控制生成过程,例如为文本到音频的应用程序使用预训练的文本编码器。

EnCodec是一种有损神经编解码器,专门用于压缩各种音频类型并以高保真度重建原始信号。它的体系结构包括一个带有残余矢量量化瓶颈的自编码器,生成具有固定词汇的音频标记的并行流。这些不同的流从音频波形中捕获不同级别的信息,最终实现跨所有流的高保真音频重建。

2)文本转音频:AudioGen

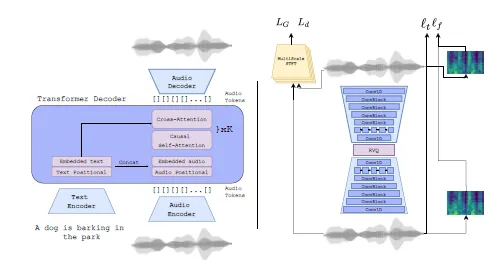

AudioGen深入研究了以描述性文本标题为条件生成音频样本的挑战性任务,将该方法扩展到包括条件和无条件音频延续。在生成复杂音景的背景下,例如“有人在繁忙的街道上吹小号时狗叫”,该模型面临着生成三种不同类型的声学内容的复杂挑战,其特征是不同的背景/前景元素、持续时间和时间轴上的相对位置。这种组合,极不可能出现在训练数据中,需要深刻的泛化,声学保真度,生产和掌握能力。

AudioGen提出了一种自回归的文本引导音频生成模型,该模型包括两个主要阶段。在初始阶段,通过神经音频压缩模型将原始音频编码为离散的令牌序列,该模型设计用于端到端训练,以从压缩表示中重建输入音频。为了提高音频生成的保真度,一组鉴别器在该过程中应用了感知损失。这种压缩技术既保证了音频生成的高保真度,又保持了表示的紧凑性。

第二阶段采用自回归的Transformer-解码器语言模型,对从第一阶段获得的离散音频令牌进行操作。此外,该语言模型以文本输入为条件。为了表示文本,使用了一个单独的文本编码器模型T5,它在大量文本语料库上进行了预训练。这种预训练的文本编码器显著有助于泛化当前文本-音频数据集中缺乏的文本概念。在处理多样性和描述性有限的文本注释时,此功能变得尤为重要。通过整合这样一个通用的文本编码器,AudioGen有效地解决了根据文本提示生成丰富多样的音频样本的挑战。

3)文本转音乐:MusicGen

MusicGen是AudioCraft模型,致力于文本到音乐生成的挑战性任务,旨在基于文本描述生成音乐作品。这个过程提出了独特的困难,因为它涉及到建模远程序列。与语音不同,音乐需要利用整个频谱,因此音乐录音的采样率更高,通常为44.1 kHz或48 kHz,而语音的采样率为16 kHz。此外,音乐的复杂性源于多种乐器的和声和旋律的存在,从而形成了复杂的结构。

MusicGen是一个简单可控的音乐生成模型,Meta AI提出了一个全面的框架来建模多个并行的声学标记流,比以前的研究提供了重大的进步。为了增强生成音乐的可控性,该模型结合了无监督的旋律调节,促进了坚持给定和声和旋律结构的音乐的生产。

MusicGen采用基于自回归转换器的解码器,以文本或旋律表示为条件。该语言模型对从EnCodec音频标记器获得的量化单元进行操作,从而确保从低帧率的离散表示中获得高保真度重建。此设置中的每个流包含来自各种学习码本的离散令牌。为了解决这种复杂性,以前的方法提出了不同的建模策略。在这项工作中,Meta AI引入了一种新颖而通用的建模框架,可以适应各种码本交错模式,探索几种不同的变体。通过利用这些模式,该模型可以利用量化音频标记的内部结构,增强音乐生成过程。