人工智能模型在生物学上可行吗?

人工神经网络是一种无处不在的机器学习模型,可以通过训练来完成许多任务,其之所以被称为人工神经网络,是因为它们的架构受到了人类大脑中生物神经元处理信息方式的启发。

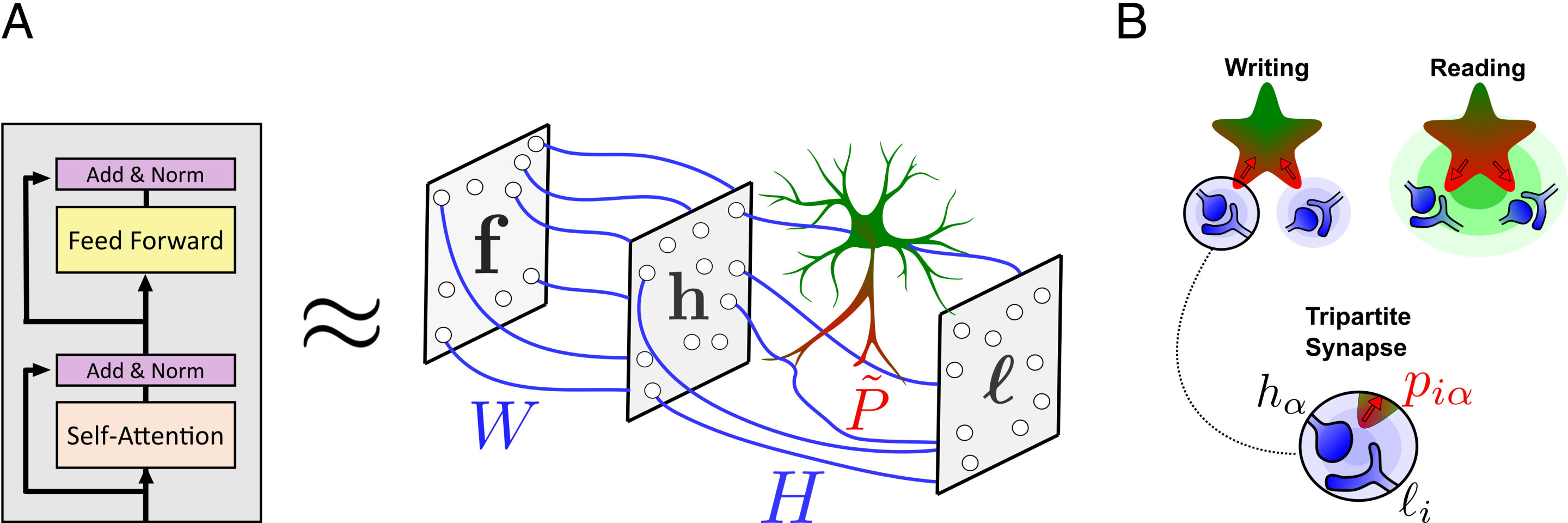

大约六年前,科学家们发现了一种新型的更强大的神经网络模型,称为“transformer”。这些模型可以实现前所未有的性能,例如通过近乎人类的精度从提示生成文本。例如,transformer是ChatGPT和Bard等人工智能系统的基础。虽然transformer非常有效,但它也很神秘:与其他大脑启发的神经网络模型不同,目前人们还不清楚如何使用生物成分构建它们。

现在,来自麻省理工学院、麻省理工学院- IBM沃森人工智能实验室和哈佛医学院的研究人员提出了一个假设,可以解释如何利用大脑中的生物元素来构建transformer。他们认为,由神经元和其他被称为星形胶质细胞的脑细胞组成的生物网络可以像transformer一样进行同样的核心计算。

最近的研究表明,星形胶质细胞是大脑中大量存在的非神经元细胞,与神经元交流,并在一些生理过程中发挥作用,如调节血液流动。但是科学家们仍然对这些细胞在计算上的作用缺乏清晰的认识。

在本周发表于《美国国家科学院院刊》(Proceedings of the National Academy of Sciences)的这项新研究中,研究人员从计算的角度探索了星形胶质细胞在大脑中的作用,并构建了一个数学模型,展示了如何利用星形胶质细胞与神经元一起,构建一个生物学上合理的transformer。

他们的假设为未来的神经科学研究研究人类大脑如何工作提供了启发。与此同时,它可以帮助机器学习研究人员解释为什么transformer在各种复杂任务中如此成功。

“大脑甚至比我们开发的最好的人工神经网络都要优秀得多,但我们并不真正知道大脑是如何工作的。思考生物器官和大规模人工智能网络之间的联系具有科学价值。”麻省理工学院-IBM 沃森人工智能实验室的研究人员、该研究论文的资深作者Dmitry Krotov说:“这是神经科学为人工智能服务,人工智能为神经科学服务。”

与克罗托夫一起撰写这篇论文的主要作者是麻省理工学院大脑与认知科学系的博士后Leo Kozachkov;以及哈佛医学院(Harvard Medical School)神经生物学助理教授、马萨诸塞州综合研究所(Massachusetts General Research Institute)助理研究员Ksenia V. Kastanenka。

生物学上的不可能变成了可能

transformer的运作方式与其他神经网络模型不同。例如,经过自然语言处理训练的循环神经网络会将句子中的每个单词与由前一个单词确定的内部状态进行比较。但是,transformer会同时比较句子中的所有单词,从而产生预测,这一过程被称为自注意(self-attention)。

Krotov解释说,为了让自关注发挥作用,transformer必须以某种形式的记忆保存所有的单词,但由于神经元的交流方式,这在生物学上似乎是不可能的。

然而,几年前,研究一种略有不同类型的机器学习模型(称为密集关联记忆)的科学家意识到,这种自注意机制可能发生在大脑中,但前提是至少三个神经元之间存在通信。

Kozachkov说:“‘3’这个数字真的让我眼前一亮,因为在神经科学中,这些被称为星形胶质细胞的细胞不是神经元,它们与神经元形成三向连接,即所谓的三方突触。”

当两个神经元交流时,一个突触前神经元将一种叫做神经递质的化学物质传递给连接它和突触后神经元的突触。有时,星形胶质细胞也连接在一起——它在突触周围缠绕着一个又长又细的触手,形成一个三部分的突触。一个星形胶质细胞可以形成数百万个三方突触。

星形胶质细胞会收集一些流经突触接头的神经递质。在某种程度上,星形胶质细胞可以向神经元发出信号。因为星形胶质细胞的运作时间比神经元长得多——它们通过缓慢地提高钙反应然后降低钙反应来产生信号——这些细胞可以保存并整合神经元传递给它们的信息。Krotov说,通过这种方式,星形胶质细胞可以形成一种记忆缓冲。

“如果你从这个角度考虑,那么星形胶质细胞对于我们需要在transformer内执行注意力操作的精确计算来说是非常自然的,”他补充说。

构建神经元-星形胶质细胞网络

有了这个见解,研究人员形成了他们的假设,即星形胶质细胞可以在transformer的计算中发挥作用。然后,他们着手建立一个神经元-星形胶质细胞网络的数学模型,该网络将像transformer一样运行。

他们采用了组成transformer的核心数学,并基于对文献的深入研究和神经科学家合作者的指导,开发了星形胶质细胞和神经元在大脑中交流时的简单生物物理模型。

然后,他们以某种方式将这些模型结合起来,直到得出一个描述transformer自关注的神经元-星形胶质细胞网络方程。

“有时,我们发现某些我们希望成为现实的东西无法合理地实现。因此,我们不得不想一些变通的办法。论文中有一些东西非常近似于transformer结构,能够以生物学上合理的方式与之匹配,”Kozachkov说。

通过他们的分析,研究人员表明,他们的生物物理神经元-星形胶质细胞网络理论上与transformer相匹配。此外,他们还进行了数值模拟,将图像和文本段落输入transformer模型,并将其与模拟的神经元-星形胶质细胞网络的反应进行比较。两者都以相似的方式回应提示,证实了他们的理论模型。

研究人员的下一步是实现从理论到实践的飞跃。他们希望将模型的预测与生物实验中观察到的结果进行比较,并利用这些知识来完善或可能推翻他们的假设。

此外,他们研究的一个意义在于,星形胶质细胞可能参与了长期记忆,因为网络需要存储信息,以便将来能够对其采取行动。Krotov说,进一步的研究可以进一步探讨这个观点。

“由于很多原因,星形胶质细胞对认知和行为极其重要,它们的运作方式与神经元根本不同。我对这篇论文最大的希望是,它能催化计算神经科学领域对神经胶质细胞,特别是星形胶质细胞的一系列研究,”Kozachkov补充道。