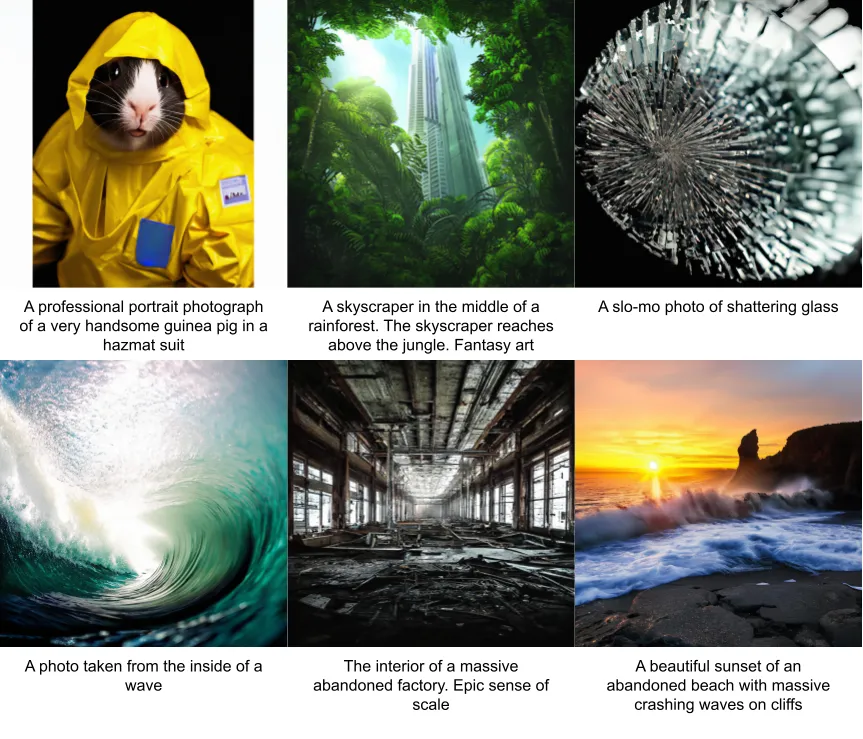

大规模文本到图像模型:Salesforce Research的XGen-Image-1内幕揭秘

Salesforce一直是新一波基础模型研究中最活跃的实验室之一。在最近几个月,Salesforce研究发布了各种不同领域的模型,包括语言、编码和计算机视觉。最近,他们发布了XGen-Image-1,这是一个巨大的文本到图像模型,在不同的计算机视觉任务中展现出最先进的性能。除了发布模型,Salesforce研究还详细介绍了XGen-Image-1的训练方法和最佳实践。今天,深入了解其中的一些细节。

构建XGen-Image-1的过程涉及一系列非常棘手的决策,涵盖了战略设计选择、训练方法和首次图像生成模型的性能指标等方面。

• 模型训练:从架构角度来看,XGen-Image-1是一个拥有8.6亿个参数的潜在扩散模型。在训练过程中,Salesforce研究利用了11亿个公开可用的文本-图像对的LAION数据集。

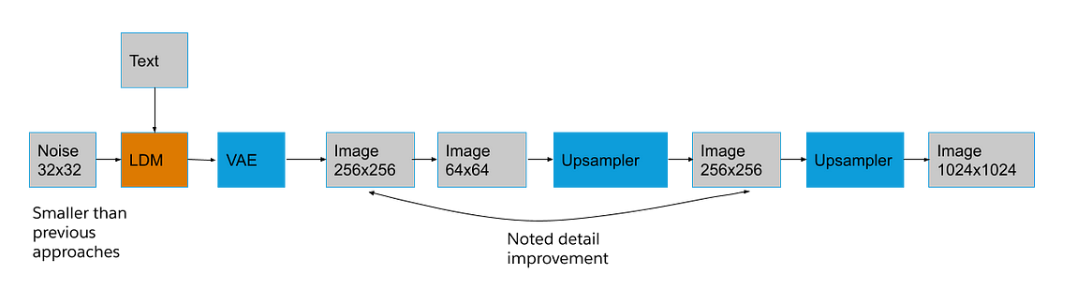

• 分辨率管理:XGen-Image-1使用了潜在变量自编码器(VAE),配合现成可用的像素上采样器,有助于以明显较低的分辨率进行训练,从而有效地降低了计算成本。

• 成本效益:当涉及到文本到图像模型的训练时,成本始终是一个令人担忧的因素。在XGen-Image-1的情况下,Salesforce研究发现,使用谷歌的TPU堆栈可以以约7.5万美元的相对较小投资培养出具备竞争力的图像生成模型。

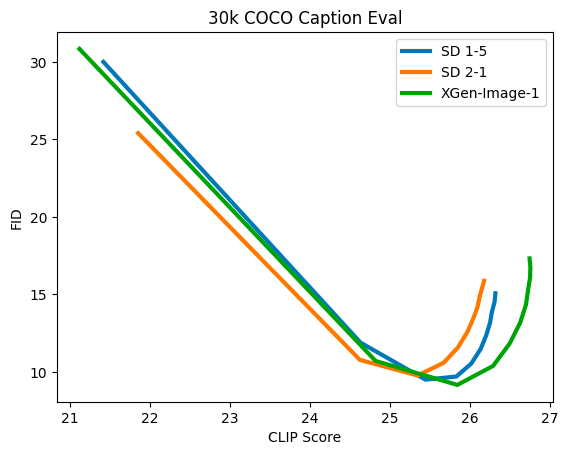

• 性能相等:值得注意的是,XGen-Image-1展示了类似于Stable Diffusion 1.5和2.1的对齐性能,这些模型堪称图像生成领域的先驱者。

• 自动优化:通过对特定区域进行修饰,自动增强特性成为一个显着的方面。例如,像“面部”这样的区域经过细化,有效地增强了生成的图像。

• 推理增强:通过在推理过程中引入拒绝采样,结果的质量得到了显著提升,这证明了深思熟虑的方法论增强的力量。

训练

大多数文本到图像模型开创了自己的训练方法。而XGen-Image-1则选择了一条不同的道路,不再关注条件、编码和上采样的直接挑战,而是着眼于它们的可重用程度。这种独特的观点使他们对高效训练的界限进行了实验,通过预训练的自编码器和基于像素的上采样模型的融合来探索低分辨率训练的边界。

正如如下流程图所示,预训练的自编码器结合可选的基于像素的上采样器,在产生宏伟图像(1024x1024)的同时赋予了低分辨率生成的能力。他们的前景延伸到对分辨率实际下限的进一步探索。定量评估发生在256x256的交汇处,在经过没有上采样的VAE阶段之后进行。定性评估利用了一个“重新上采样器”,通过从256到64再到256的过程,与SDXL的“Refiner”类似,以及一个从256到1024的上采样器。

训练基础设施

Salesforce Research使用TPU v4进行模型训练。在整个训练过程中,团队利用Google Cloud Storage(GCS)来保存模型的检查点。此外,还使用Gloud挂载驱动程序来存储庞大的数据集。在一台v4-512 TPU机器上进行了强大的训练计划,训练过程中进行了大约110万个步骤,历时约9天,硬件成本约为73,000美元,与其他替代方案相比非常便宜!

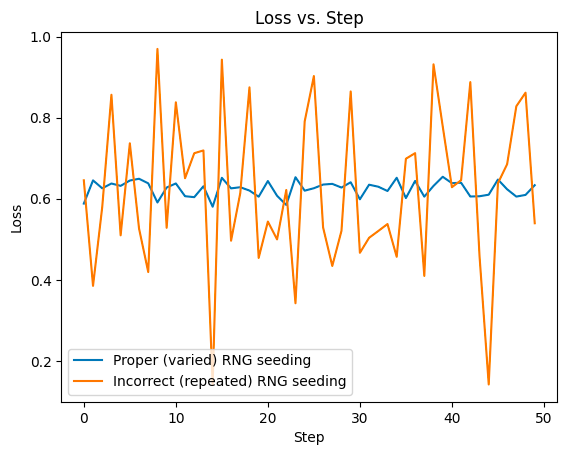

这个过程并非没有挑战。尽管批量大小很大,但模型的损失却在每个步骤中出现了不稳定的波动。根本原因与所有工作程序的统一种子有关,导致了这种波动性。通过随机种子的方式解决了这个问题,每个工作程序的种子与其排名相匹配,促进了噪声步骤的均衡分散,使损失曲线更加平滑。

评估

为了评估XGen-Image-1,Salesforce Research采用了一种双轴表示的方法,其中x轴显示CLIP Score(对提示的匹配程度),而y轴则囊括了FID(Fréchet Inception Distance),这是一个衡量数据集中外观相似性的指标。这个评估过程涉及15个指导尺度,包括初始图中的30,000个图像-提示对。用于检查点间比较时,这个范围缩小到1,000个对。数据对是从COCO Captions数据集中精心抽样出来的,其中的标题被增加了“一张照片”,以减轻与不同图形风格相关的FID惩罚。

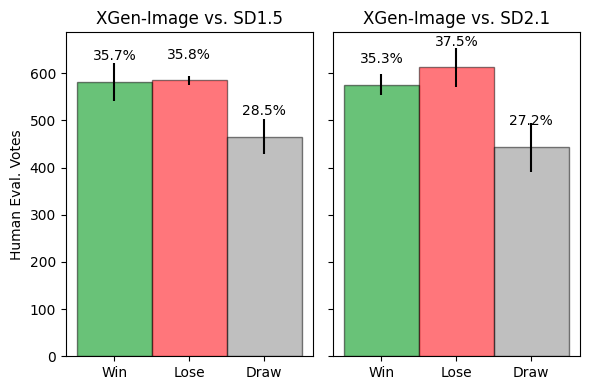

Salesforce Research还使用人工评估来对比XGen-Image-1的性能。这项评估通过Amazon Mechanical Turk进行,参与者需判断图像和提示的对应程度。为了确保准确度,参与者需要处理六个不同的实验,并完成全部1,632个提示,最终得到每项对比约10,000个回答的大量数据。

生成高质量的图像

XGen-Image-1 构建的一个重要部分是确保它生成高质量的图像。这个过程基于两个众所周知的技巧。

最初的策略是生成大量的图像,然后挑选最优的图像。Salesforce研究坚持保持一个提示对一个输出的原则,并着手自动化这个方法。对这种方法的探索使他们深入研究了拒绝采样——一种生成多个图像,然后自动选择最合适的候选图像的技术。最初考虑了一系列指标,包括美学评分和CLIP分数。最终,团队发现PickScore是一个强大的综合指标。正如文献中所证实的,这个指标与人类偏好的一致性表现出非凡的相关性 — 这是一个关键的特征。

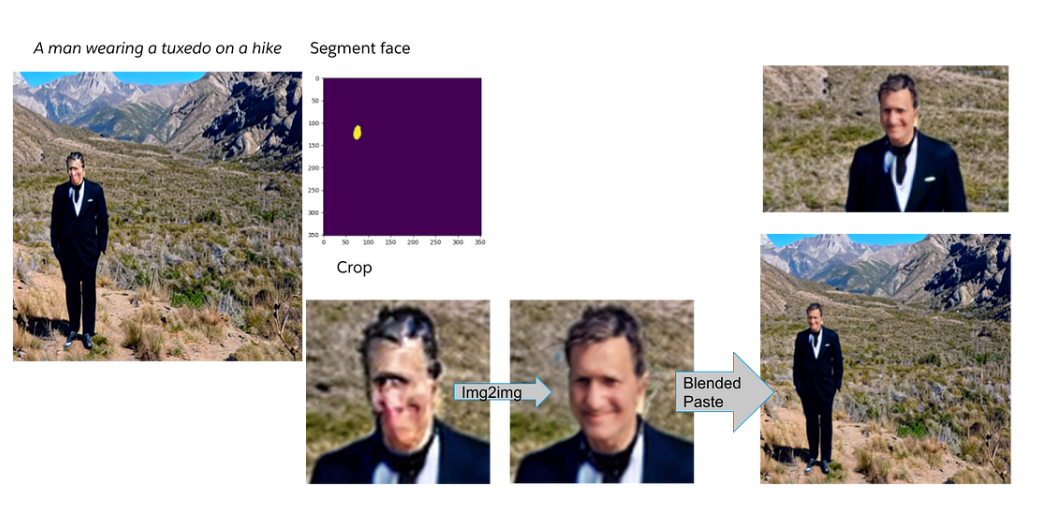

第二种技术是通过对呈现次优美学效果的区域进行修复,从而作为图像改进的典范。

1. 从提示中推导出的分割掩码囊括了目标对象。

2. 根据这些分割掩码,适当地对对象进行裁剪。

3. 对裁剪区域进行扩展。

4. 在裁剪区域上使用图像到图像操作,将分割提示与匹配的标题(例如,“一张脸部的照片”)相对应,促进了区域的精细调整。

5. 分割掩码在将增强的裁剪区域与原始图像无缝融合中起着关键作用。

这两种方法的结合使得XGen-Image-1能够创建高质量的图像。

XGen-Image-1虽然不是文本到图像模型领域的突破,但它仍然提供了一些非常有用的贡献。最大的贡献是展示了可以重复使用许多预训练组件,以在这类模型中实现最先进的性能。XGen-Image-1在使用较少的训练计算资源的情况下,实现了与StableDiffusion相似的性能。这的确非常令人印象深刻。