新的“强盗”算法利用光来达到更好的效果

赌徒如何从一排老虎机中获得最大的收益?这就是“多臂强盗问题”的灵感来源,这是强化学习中的一个常见任务,在这个任务中,“代理”做出选择来获得奖励。最近,由东京大学Hiroaki Shinkawa领导的一个国际研究小组开发了一种扩展的光子强化学习方案,该方案从静态强盗问题转向更具挑战性的动态环境。这项研究发表在《智能计算》杂志上。

该方案的成功依赖于提高学习质量的光子系统和支持算法。着眼于“潜在的光子实现”,作者开发了一种改进的bandit Q-learning算法,并通过数值模拟验证了其有效性。

他们还用并行架构测试了他们的算法,在并行架构中,多个代理同时操作,发现加速并行学习过程的关键是利用光子的量子干扰来避免冲突的决策。

虽然使用光子的量子干扰在这一领域并不新鲜,但作者认为这项研究是“第一次将光子合作决策的概念与Q-learning联系起来,并将其应用于动态环境。”强化学习问题通常设置在动态环境中,这种环境会随着智能体的行为而变化,因此比强盗问题中的静态环境更复杂。

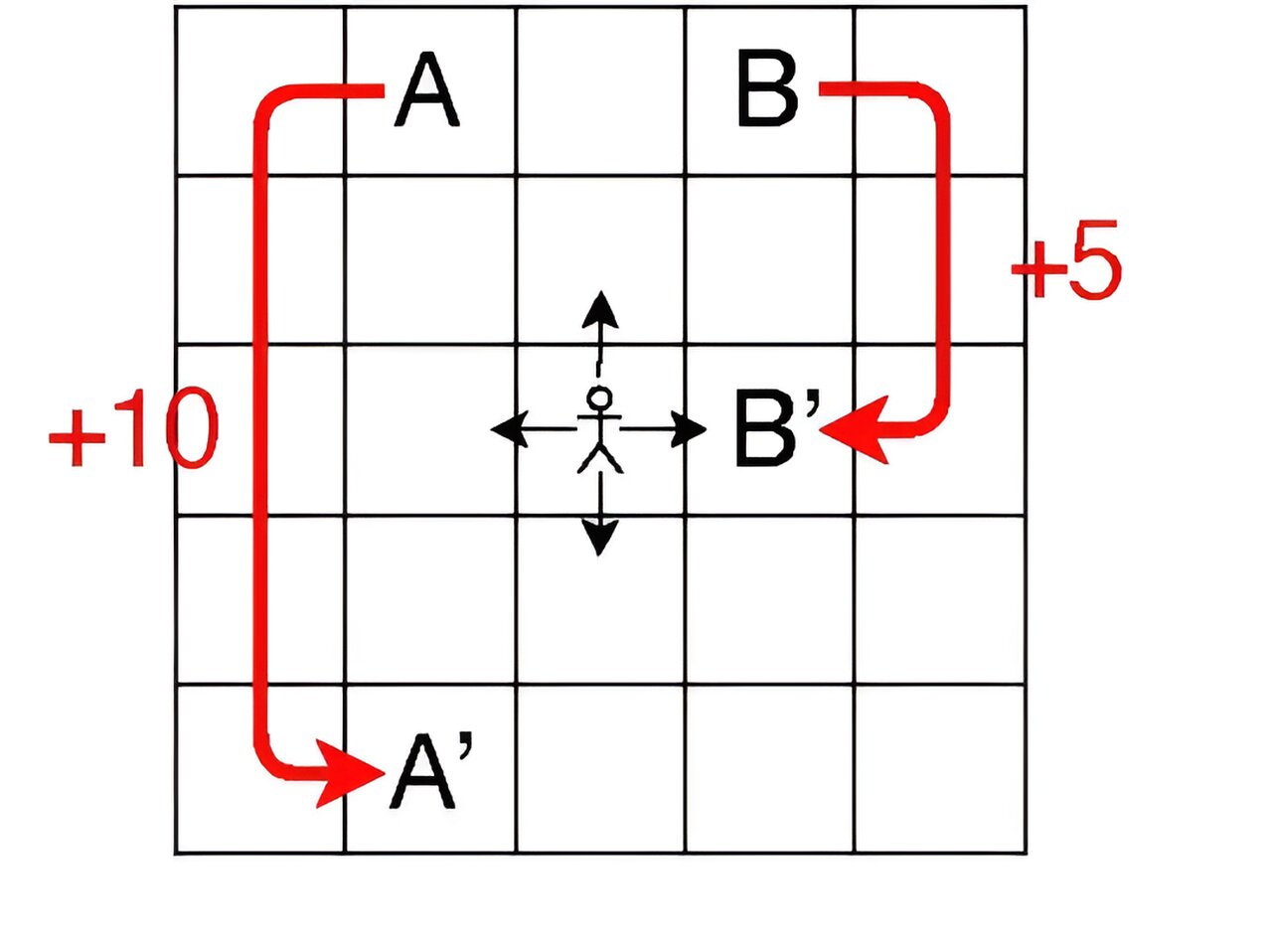

这项研究的目标是一个网格世界,是一个由持有不同奖励的单元格组成的集合。每个代理都可以向上、向下、向左或向右移动,并根据其当前的移动和位置获得奖励。在这种环境下,智能体的下一步完全取决于它当前的移动和位置。

本研究中的模拟使用5 ×5单元格;每个单元被称为一个“状态”,代理在每个时间步所做的每一个动作被称为一个“动作”,而决定代理如何在每个状态中选择某个动作的规则被称为“策略”。将决策过程设计为强盗问题场景,将每个状态-动作对视为老虎机,将状态-动作对Q值的变化视为奖励。

与基本的Q-learning算法不同,改进的bandit Q-learning算法的目标是高效、准确地学习整个环境中每个状态-动作对的最优Q值。

因此,智能体必须在“利用”具有高值的熟悉配对以获得更快的学习速度和“探索”不常用的配对以获得潜在的更高值之间保持良好的平衡。采用了在这类平衡中表现优异算法softmax作为策略。

作者未来的首要任务是设计一个支持至少三个代理之间无冲突决策的光子系统,希望通过将其添加到他们提出的方案中,来帮助代理避免做出冲突决策。与此同时,他们正计划开发允许智能体连续行动的算法,并将他们的bandit Q-learning算法应用于更复杂的强化学习任务。