Google发布AVIS:自主搜索图像信息的新方法

2023年08月22日 由 daydream 发表

792

0

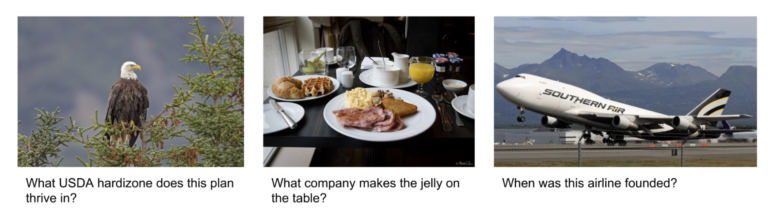

Google的AVIS尝试回答关于图像的问题,这些问题的信息不容易获得,例如航空公司成立的日期或汽车制造的年份。

近期大语言模型(LLMs)的进展使得多模态功能成为可能,比如图像描述和视觉问答。然而,这些视觉语言模型(VLMs)在需要外部知识的复杂真实世界视觉推理(称为“视觉信息寻求”)方面仍面临困难。

为了解决这一限制,Google的研究人员提出了一种新方法,称为AVIS,它将Google的PALM与计算机视觉、网页搜索和图像搜索工具相结合。借助这些工具,AVIS在一个动态框架中利用语言模型自主地搜索视觉信息。

Google的AVIS向人类学习

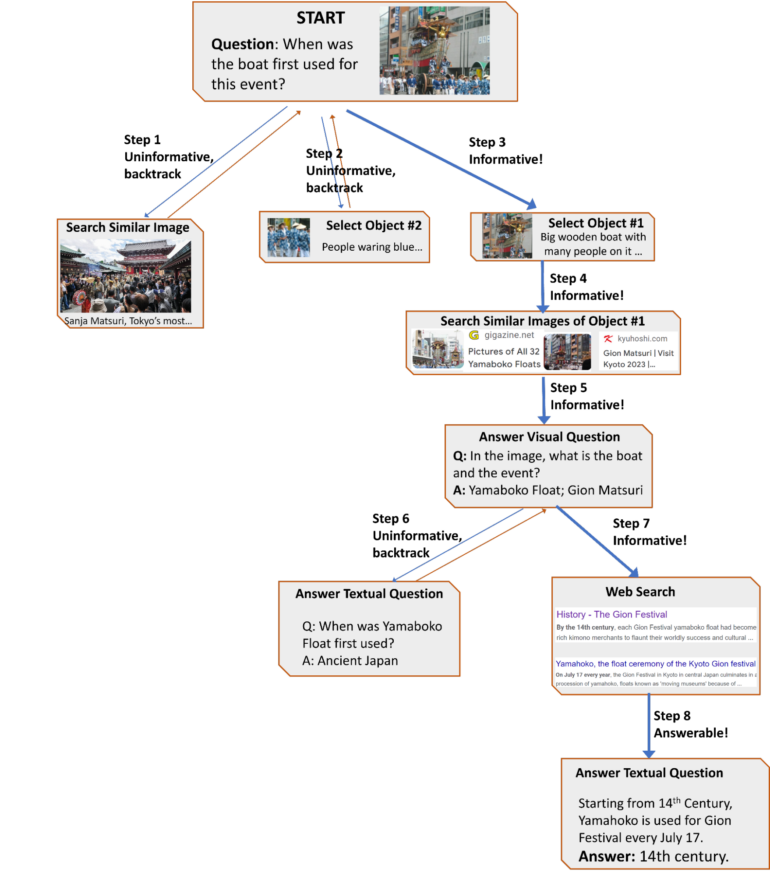

与以往将大型语言模型与工具以严格的两步流程结合的系统不同,AVIS更灵活地用于计划和推理,实现行动根据实时反馈进行调整的能力。

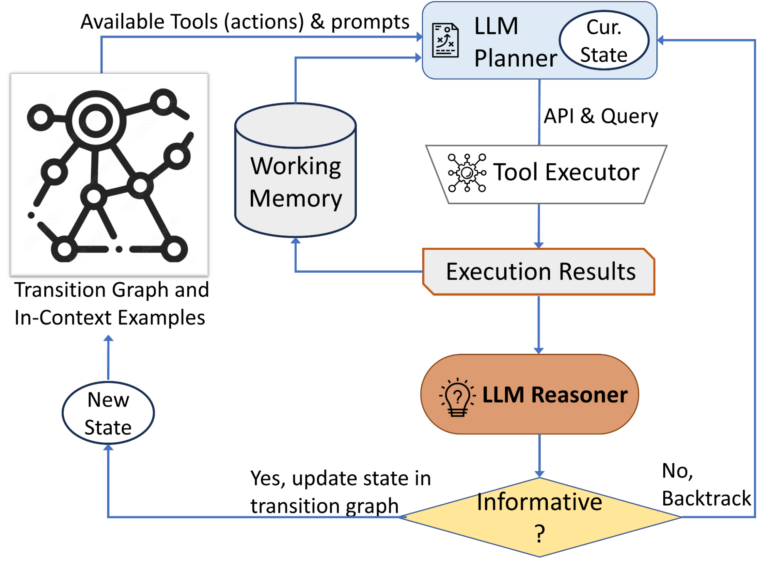

AVIS主要由以下三个组成部分构成:

- 通过LLM确定下一步行动(API调用和查询)的计划器

- 用于保留过去API执行信息的工作内存

- 利用LLM处理API输出并提取有用信息的推理器

计划器和推理器被迭代使用,计划器根据推理器更新的状态确定下一个工具和查询。这一过程一直持续,直到推理器确定有足够的信息提供最终答案为止。

同时,还整合了三种类型的工具:

- 用于从图像中提取视觉信息的计算机视觉工具

- 用于检索开放世界知识和事实的网页搜索工具

- 用于从与视觉相似的图像关联的元数据中获取相关信息的图像搜索工具

为了充分利用这些能力,研究人员进行了一项用户研究,捕捉了人类使用视觉推理工具进行决策的常见行动序列,并构建了一个指导AVIS行为的转换图。

AVI无需微调即可达到最先进水平

在Infoseek数据集上,AVIS取得了50.7%的准确率,显著优于经过微调的视觉语言模型如OFA和PaLI。在OK-VQA数据集上,AVIS以较少的示例达到了60.2%的准确率,超过大部分先前的成果,并接近经过微调的模型,Google表示。

未来,研究团队希望在其他推理任务上探索他们的框架,并尝试使用更轻量级的语言模型,因为目前使用的PALM模型在计算上是密集型的,具有5400亿个参数。

总结

- Google的自主视觉信息寻求(AVIS)是一个新方法,它将大型语言模型与计算机视觉、网页搜索和图像搜索工具整合起来,自主搜索视觉信息并回答关于图像的复杂问题。

- AVIS系统主要由计划器(使用语言模型决定下一步行动)、工作内存(存储信息)和推理器(处理输出并提取有用信息)三个组成部分构成,实现了灵活和动态的计划和推理。同时使用了多种工具。

- 在Infoseek和OK-VQA数据集上,AVIS取得了高准确率,优于经过微调的视觉语言模型,并接近无需微调的最新水平。研究团队计划将这一框架应用于其他推理任务,并尝试使用更轻量级的语言模型,因为目前的模型计算负荷较高。

文章来源:https://the-decoder.com/googles-avis-aims-to-answer-tricky-questions-about-images-by-searching-the-web/

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消