人工智能帮助机器人用整个身体操纵物体

想象一下,你正在拿着一个又大又重的箱子上一段楼梯。你可以张开手指,双手举起箱子,然后把它放在前臂上,靠在胸前保持平衡,用你的整个身体来操纵盒子。

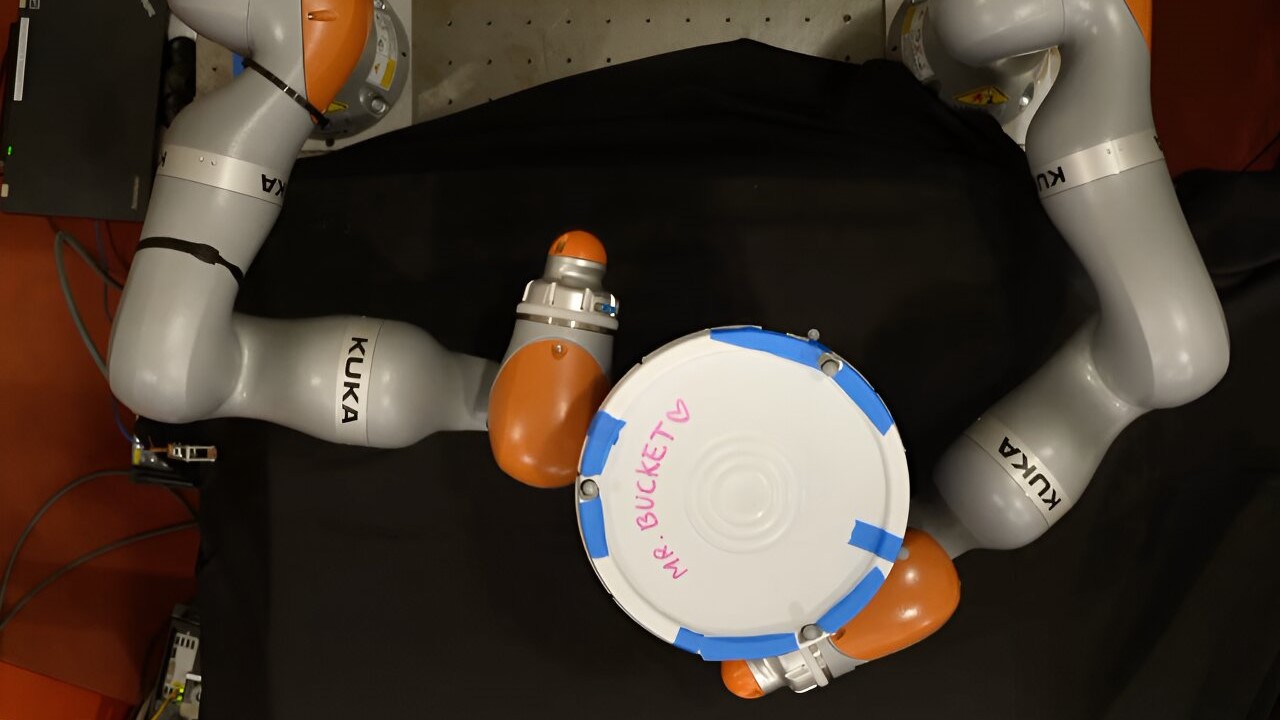

人类通常擅长全身操作,但机器人却很难完成这样的任务。对于机器人来说,箱子可能接触到搬运者的手指、手臂和躯干的每个点都代表着一个接触事件,它必须对此进行推理。由于有数十亿潜在的联系事件,为这个任务进行规划很快变得困难。

现在,麻省理工学院的研究人员发现了一种简化这一过程的方法,称为富接触操纵规划(contact-rich manipulation planning)。他们使用一种被称为“smoothing”的人工智能技术,将大量接触事件总结为少量的决策,从而使简单的算法也能快速为机器人确定有效的操纵计划。

虽然这种方法仍处于早期阶段,但它有可能使工厂使用更小的移动机器人,这些机器人可以用整个手臂或身体来操纵物体,而不是只能用指尖抓住物体的大型机械手臂。这可能有助于减少能源消耗和降低成本。此外,这项技术对于执行火星或其他太阳系天体探测任务的机器人也很有用,因为它们只需要一台机载计算机就能迅速适应环境。

电气工程与计算机科学(EECS)研究生、这一技术相关论文的共同第一作者H.J. Terry Suh说:“与其把它看作是一个黑匣子系统,不如利用模型来使用这类机器人系统的结构,这样就可以加快做出这些决定的整个过程,并提出丰富的接触计划。”

论文的共同第一作者、波士顿动力人工智能研究所机器人专家 Tao Pang 博士;EECS研究生Lujie Yang;计算机科学和人工智能实验室(CSAIL)成员、资深作者Russ Tedrake。这项研究发表在本周的IEEE机器人学报上。

关于学习的学习

强化学习是一种机器学习技术,智能体(如机器人)通过试错来学习完成任务,并在接近目标时获得奖励。研究人员表示,这种类型的学习采用黑盒方法,因为系统必须通过试验和错误来学习世界上的一切。

它已被有效地用于富接触操作规划,其中机器人寻找学习以特定方式移动物体的最佳方式。

但是,由于机器人在决定如何使用手指、手、手臂和身体与物体互动时,可能需要对数十亿个潜在的接触点进行推理,因此这种反复试验的方法需要大量的计算。

“强化学习可能需要经过数百万年的模拟时间才能真正学会一种策略,”Suh补充道。

如果研究人员利用他们对系统的了解和他们想让机器人完成的任务,专门设计一个基于物理的模型,那么这个模型就包含了这个世界的结构,使它更有效率。

然而,当涉及到接触丰富的操作计划时,基于物理的方法不如强化学习有效,Suh和Pang想知道其中的原因。

他们进行了详细的分析,发现一种被称为“smoothing”的技术可以使强化学习表现得很出色。

在确定如何操纵物体时,机器人可能会做出许多不重要的决策。例如,一个手指的每一个微小的调整,无论它是否与物体接触,都无关紧要。“smoothing”会平均掉许多不重要的中间决策,只留下一些重要的决策。

强化学习通过尝试许多接触点,然后计算结果的加权平均值来隐式地执行“smoothing”。根据这一见解,麻省理工学院的研究人员设计了一个简单的模型,可以执行类似的“smoothing”操作,使其能够专注于核心的机器人-物体交互并预测长期行为。他们证明,这种方法在生成复杂计划方面与强化学习一样有效。

“如果你对你的问题了解得更多,你就能设计出更有效的算法,”Pang说。