AI的多视图浪潮即将到来,将具备强大的潜力

人工智能在其最成功的形式中,比如ChatGPT或DeepMind的AlphaFold进行蛋白质预测,一直被困在一个狭窄的维度中:AI只从一个角度看待事物,作为一个单词、一个图像、一个空间坐标,作为任何类型的数据,但一次只能看一个。

很快,神经网络将通过融合多种数据形式的方式大幅扩展,从多个方面来看待生活。这是一个重要的发展,因为它可能使神经网络能更好地理解世界的连贯性,事物之间的联系,这可能是朝着能够执行所谓的"推理"和"规划"的程序,对世界进行思考的重要阶段。

多方位数据的到来源于机器学习科学家多年的研究,通常被称为"多视图"或者"数据融合"。甚至有一本专门探讨这个主题的学术期刊,由学术出版巨头爱思唯尔出版,名为《信息融合》。

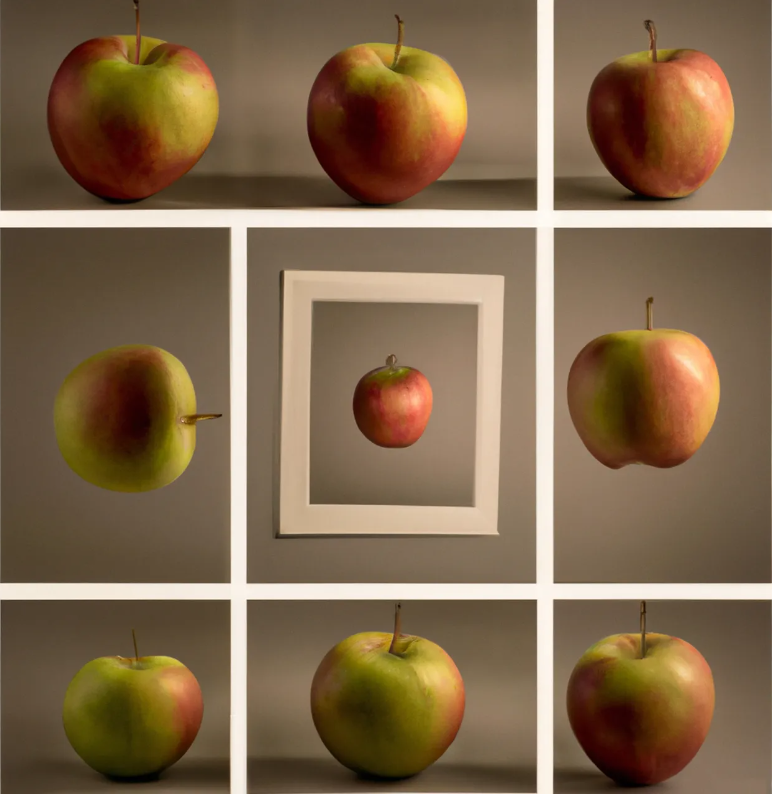

数据融合的深刻观点是,世界上任何一个我们想要研究的东西同时有很多方面。例如,一个网页既包括肉眼可见的文本,又包括指向该网页的锚文本,甚至是构成网页结构的底层HTML和CSS代码。

一个人的图像既可以有标签显示人的姓名,又可以有图像的像素。一个视频有视频画面,但也有伴随画面的音频片段。

今天的AI程序将这些不同的数据视为有关世界的独立信息片段,几乎没有联系。即使神经网络处理多种数据,如文本和音频,它们所做的也仅仅是同时处理这些数据集,它们并没有明确地将多种类型的数据链接起来,理解它们是同一对象的不同视角。

例如,Meta Properties(Facebook、Instagram和WhatsApp的所有者)最近推出了其机器翻译领域的最新成果,一个多模态数据的壮举。这个程序名为SeamlessM4T,同时训练语音数据和文本数据,并且可以为任何任务生成文本和音频。

但是SeamlessM4T不会将每个信号的每个单元视为同一对象的不同方面。

关于事物的这种分裂视角正在发生改变。纽约大学助理教授和教职研究员Ravid Shwartz-Ziv,以及Meta公司首席AI科学家Yann LeCun最近发表的一篇论文中,他们讨论了使用多视图来丰富深度学习神经网络,以从多个角度表示对象的目标。

在这篇高度技术性和颇具理论性的论文中,于4月份在arXiv预印论文服务器上发布,Shwartz-Ziv和LeCun写道:“深度学习在各个应用领域的成功引发了对深度多视图方法的日益关注,并展示了有希望的结果。"

多视图即将迎来决定性的时刻,因为当今越来越庞大的神经网络(如SeamlessM4T)正接纳越来越多的模态,被称为“多模态”AI。

所谓生成式AI的未来,比如ChatGPT和Stable Diffusion等程序,将多种模态结合为一个单一程序,不仅包括文本、图像和视频,还包括点云和知识图谱,甚至包括生物信息学数据以及场景或对象的许多其他视角。

这许多不同的模态可能提供了事物的成千上万个"视图",这些视图可能包含相互信息,这可能是一种非常丰富的方法来理解世界。但同时也带来了挑战。

多视图在深度神经网络中的关键是一个由Shwartz-Ziv和其他人假设的概念,被称为“信息瓶颈”。随着模态数量的增加,信息瓶颈变得棘手起来。

在信息瓶颈中,多个输入被合并成一个"表示",提取出输入之间作为同一对象的不同视角所共享的显著细节。在第二阶段,该表示被压缩成仅包含预测与该对象相对应的输出所需的输入的精简形式。这个收集相互信息的过程,然后剥离或压缩除了必需元素之外的全部内容,就是信息的瓶颈。

在大型多模态网络中,多视图面临的挑战是如何知道所有不同视角的信息对于巨大的神经网络使用所有这些不同模态执行的许多任务来说是必不可少的。

举个简单的例子,一个执行基于文本的任务(如ChatGPT)并生成文本句子的神经网络,如果在压缩阶段丢弃了与后一任务相关的细节,当需要生成图像时,可能会出现问题。

正如Shwartz-Ziv和LeCun所写:“将信息分离为相关和不相关的组件变得具有挑战性,并且通常导致亚最优性能。"

学者们宣称,目前还没有明确的答案。这将需要进一步的研究,特别是从包括对象的两个不同视图扩展到可能是许多视图的多视图的重新定义。

他们写道:"为了确保这一目标的最优性,我们必须将多视图的假设扩展到两个以上的视图",特别是对于多视图的传统方法来说,"认为相关信息在所有不同视图和任务之间共享,这可能过于局限。"他们补充说,在某些情况下,视图可能仅在某些上下文中共享一些信息。

他们总结道:"结果是,定义和分析这个天真解决方案的更精细版本是至关重要的。"

毫无疑问,多模态的兴起将推动多视图科学提出新的解决方案。在实践中,多模态的爆炸将为AI带来新的理论突破。