Meta开源DINOv2视觉模型,允许商用分发

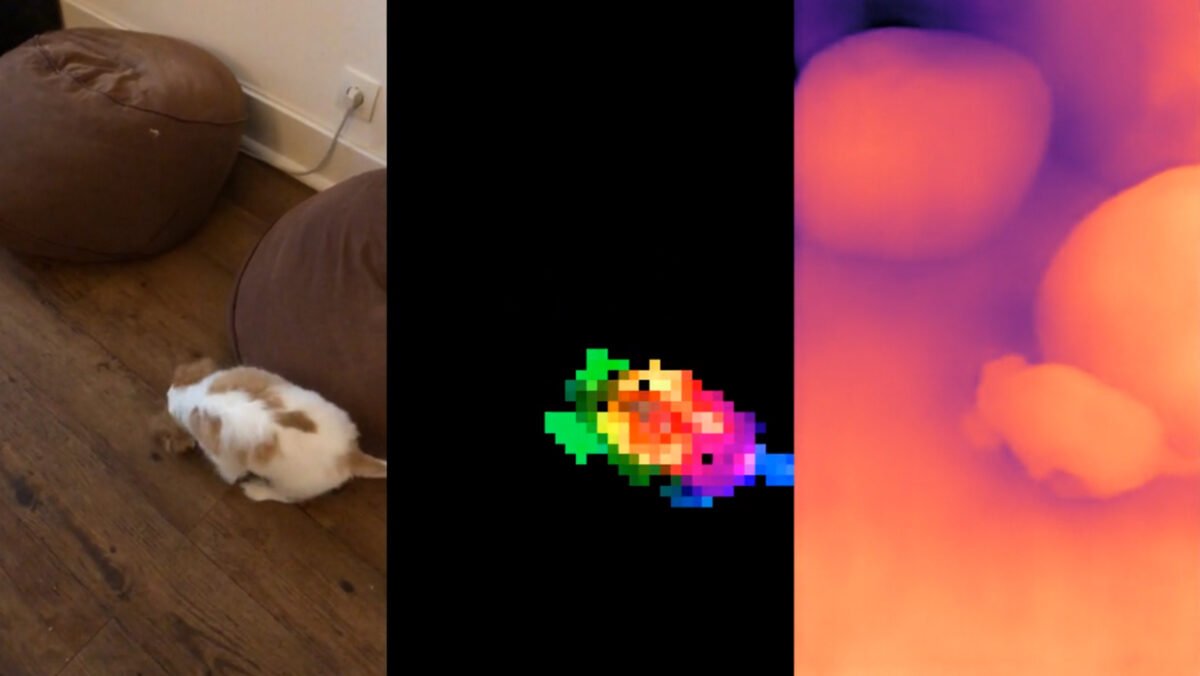

Meta发布了DINOv2计算机视觉模型,采用Apache 2.0许可证,为开发人员和研究人员在下游任务中提供更大的灵活性。Meta还发布了基于DINOv2的密集预测模型集,用于语义图像分割和单目深度估计。

此外,Meta引入了FACET,这是一个用于评估计算机视觉模型公平性的基准,包括分类和分割等任务。该数据集包含32,000张来自50,000人的图像,除了物理特征外,还包括感知性别和年龄组等人口属性。

FACET旨在成为评估计算机视觉模型公平性的标准基准,并鼓励设计和开发考虑更多人群的模型。

Meta的DINOv2是计算机视觉的基础模型。该公司展示了其优势,并希望将DINOv2与大型语言模型相结合。

2021年5月,Meta的AI研究人员提出了DINO(无标签自蒸馏)的概念,这是一种自我监督训练的图像任务AI模型,包括分类或分割。现在,Meta发布了显著改进的DINOv2版本。

与DINO一样,DINOv2是使用自我监督学习进行训练的计算机视觉模型,据Meta称,在所有基准测试的任务上,它的性能优于大多数当前的专业系统。由于采用自我监督学习,不需要标记的数据,并且可以使用大型未标记的图像数据集对DINO模型进行训练。

DINOv2是所有计算机视觉任务的基础模型

Meta表示:“DINOv2提供了高性能功能,可以直接作为简单线性分类器的输入。”这使得DINOv2成为广泛范围的计算机视觉任务(从图像级视觉任务,如图像分类、实例检索、视频理解,到像素级视觉任务,如深度估计、语义分割)的灵活而多功能的工具。

据Meta称,DINOv2模型可以应用于各种应用,包括与世界资源研究所一起进行森林制图,估计动物密度和数量,以及细胞显微镜等生物研究。

为了训练,Meta收集了12亿张图像,并对数据集进行了筛选和平衡。最终,DINOv2使用了1.42亿张图像进行训练。与其前任一样,DINOv2依赖于Vision Transformers。

Meta希望将DINOv2与大型语言模型相结合

DINOv2是Meta在计算机视觉方面的工作的补充,特别是“Segment Anything”,这是一个最近发布的零样本图像分割模型,具备提示功能。Meta将DINOv2视为可以与其他分类器链接起来应用于超过分割的许多领域的构建块。

该公司发布了DINOv2系列的代码和一些模型。现在,公司计划将DINOv2集成到更复杂的AI系统中,使其能够与大型语言模型进行交互。“提供关于图像丰富信息的视觉骨干将使复杂的AI系统能够对图像进行比描述单一文本句子的更深入的推理。”

他还表示,像CLIP这样的模型,将使用图像-文本对进行训练,最终将受到标题的限制。“而对于DINOv2,没有这样的内置限制。”

总结

- Meta发布了DINOv2,这是一系列自我监督的计算机视觉模型,可用于深度估计或分割等各种任务。

- DINOv2模型经过超过1.42亿张图像的训练,Meta认为它们是可以与其他分类器链接的基础模型。

- Meta打算将DINOv2与大型语言模型结合,以创建更强大的用于图像分析和处理的模型。