Stability AI推出其首个日语图像视觉模型Japanese InstructBLIP Alpha

2023年09月04日 由 daydream 发表

638

0

Stability AI发布了其首款日本视觉语言模型,即Japanese InstructBLIP Alpha。它可以为输入图像生成文本描述,并根据图像生成答案。

Japanese InstructBLIP Alpha是一种视觉语言模型,可以在最近发布的日语大语言模型Japanese StableLM Instruct Alpha 7B的基础上生成给定图像的条件文本。

Japanese InstructBLIP Alpha利用了InstructBLIP架构,该架构在各种视觉语言数据集上表现出色。为了创建一个性能卓越的模型,我们使用了在大型英文数据集上预训练的InstructBLIP的一部分作为模型的初始值,然后使用有限的日本数据集进行微调。

该模型的应用示例包括基于图像的搜索引擎、场景的描述/问答以及盲人的图像文本描述等。

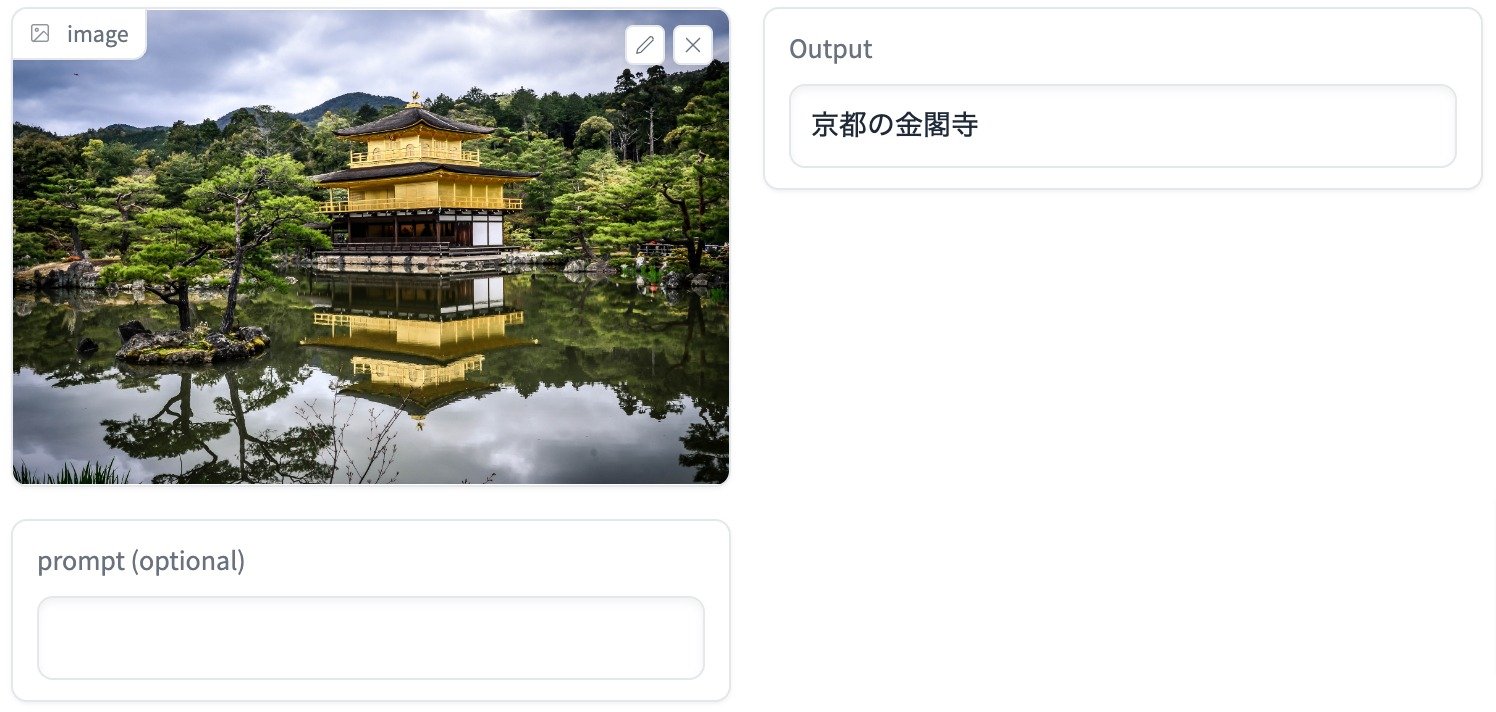

性能方面,除了生成日语文本外,日本InstructBLIP Alpha还能准确识别特定于日本的对象(如东京天空树或金阁寺)。

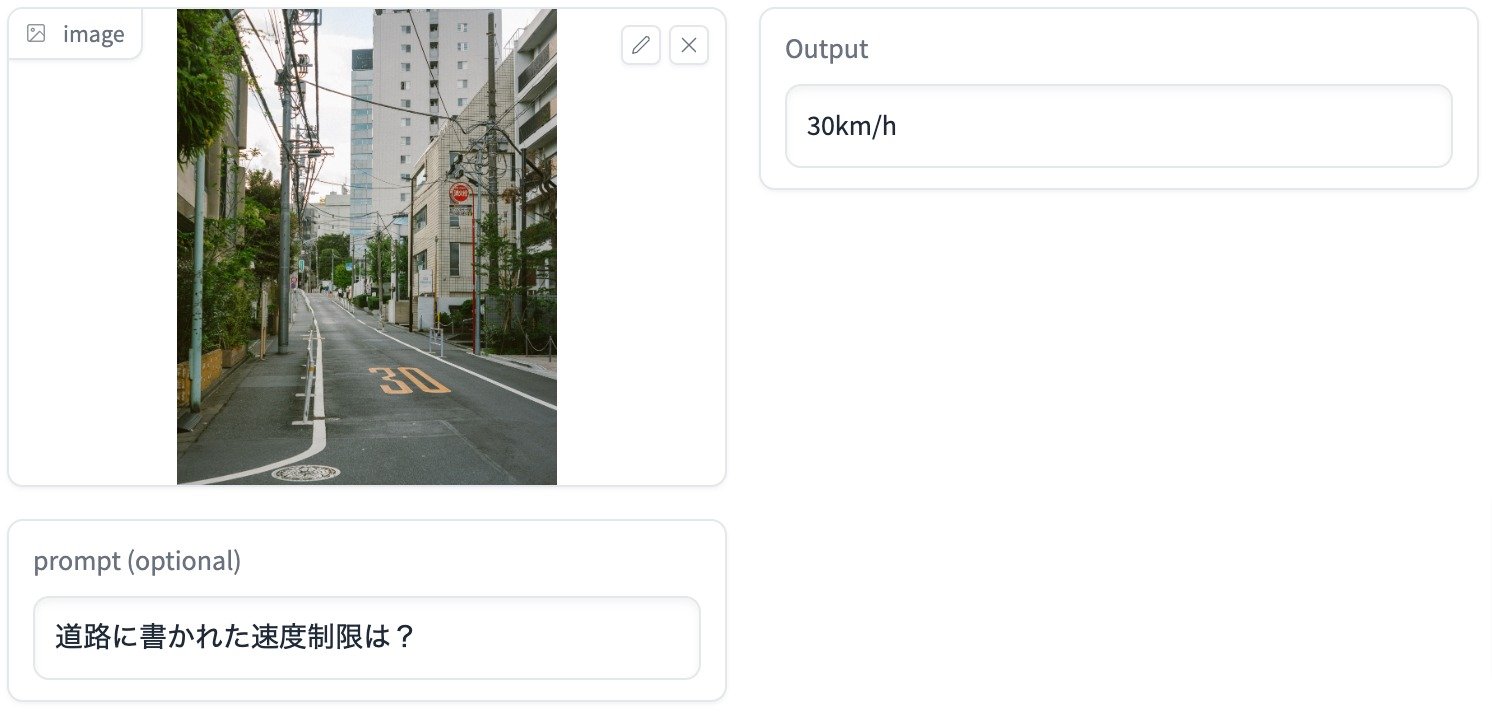

此外,输入还可以包括文本,比如问题。例如,如下所示的示例中,它可以回答关于输入图像的问题。

该模型可在Hugging Face Hub上使用,进行推理和额外的训练。

文章来源:https://stability.ai/blog/announcing-japanese-instructblip-alpha

欢迎关注ATYUN官方公众号

商务合作及内容投稿请联系邮箱:bd@atyun.com

热门企业

热门职位

写评论取消

回复取消