MLPerf 3.1新增了大型语言模型推理的基准测试

MLCommons通过增加用于大型语言模型(LLMs)推理测试和衡量用于机器学习(ML)工作负载的存储系统性能的新基准,进一步完善了其MLPerf AI基准套件。

MLCommons是一个中立、多利益相关方的组织,旨在为供应商提供一个公平竞争的环境,以基于MLPerf基准套件的不同方面报告AI性能。今天发布的新的MLPerf推理3.1基准是今年的第二次重大更新,此前的3.0结果于4月份发布。MLPerf 3.1基准包含了超过13,500个性能结果。

提交结果的公司包括:ASUSTeK、Azure、cTuning、Connect Tech、Dell、Fujitsu、Giga Computing、Google、H3C、HPE、IEI、Intel、Intel-Habana-Labs、Krai、Lenovo、Moffett、Neural Magic、Nvidia、Nutanix、Oracle、Qualcomm、Quanta Cloud Technology、SiMA、Supermicro、TTA和xFusion。

持续提升的性能

在每次更新的MLPerf基准中,供应商性能的持续提升是一个共同的主题,而MLPerf 3.1推理结果也遵循了这一趋势。尽管推理基准测试有多种类型和配置,但MLCommons的创始人兼执行总监David Kanter在新闻发布会上表示,许多提交者在3.0基准测试相比性能提升了20%甚至更多。

除了持续的性能提升,MLPerf还在推广3.1推理基准。

他说:“我们正在发展基准套件以反映最新的情况。我们的LLM基准是在本季度全新推出的,真正反映了生成式AI大型语言模型的爆发。”

MLPerf 3.1推理LLM基准的关键内容

这不是MLCommons第一次尝试对LLM的性能进行基准测试。

早在6月份,MLPerf 3.0训练基准首次添加了LLM。然而,训练LLM与运行推理操作是完全不同的任务。

“一个关键的区别是,对于推理,LLM在根本上是执行生成任务,生成多个句子”Kanter说。

MLPerf训练基准的LLM使用了GPT-J 6B(60亿参数)模型对CNN/Daily Mail数据集进行文本摘要。Kanter强调,尽管MLPerf训练基准侧重于非常大型的基础模型,但MLPerf推理基准所执行的实际任务是代表更广泛的用例,更多的组织可以部署。

Kanter说:“许多人根本没有足够的计算资源或数据来支持一个非常大的模型。我们在推理基准中执行的实际任务是文本摘要。”

推理不仅仅适用于GPU —— 至少英特尔认为如此

尽管高端GPU加速器通常在MLPerf的训练和推理结果中名列前茅,但并不是所有的组织都追求最高的数字 —— 至少在英特尔看来是如此。

英特尔芯片在MLPerf推理3.1中表现出色,其中提交了Habana Gaudi加速器、第四代Intel Xeon可扩展处理器和Intel Xeon CPU Max系列处理器的结果。根据英特尔的说法,第四代Intel Xeon可扩展处理器在GPT-J新闻摘要任务中表现出色,以实时服务器模式每秒摘要一段文字。

在MLCommons新闻发布会的问答环节,英特尔人工智能产品部高级总监Jordan Plawner在回答问题时表示,各组织对推理所需的计算需求多样化。

他说:“归根结底,企业和组织需要在生产中部署人工智能,这显然需要各种计算能力。能够展示这么多软件和硬件代表展示出推理可以在各种计算设备上运行,这真的是市场发展的一个领先指标,现在是扩展人工智能模型的规模,而不仅仅是构建模型。”

Nvidia声称取得了Grace Hopper MLPef推理的增益,并表示还有更多进展

虽然英特尔热衷于展示CPU在推理中的价值,但Nvidia的GPU在MLPerf推理3.1基准中得到了很好的代表。

MLPerf推理3.1是首次包括Nvidia的GH200 Grace Hopper超级芯片。Grace Hopper超级芯片将一个Nvidia CPU与GPU配对,以优化AI工作负载。

Nvidia的人工智能总监Dave Salvator在新闻发布会上表示:“Grace Hopper首次强势亮相,相比我们的H100 GPU提交结果提升了高达17%的性能,我们在各方面都实现了领先地位。”

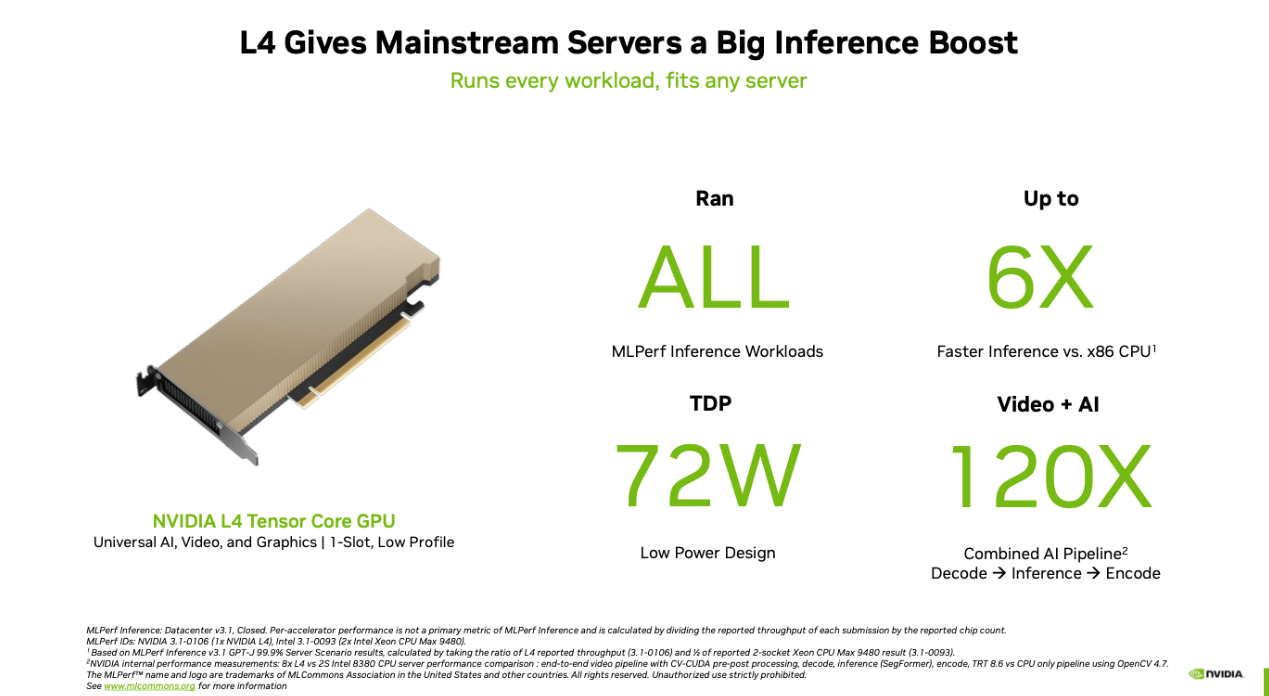

虽然Grace Hopper适用于最大最复杂的工作负载,但Nvidia并未止步于此。Nvidia的Dave Salvator还强调了MLPerf推理3.1结果中的Nvidia L4 GPU。

他说:“与本轮提交的最佳x86 CPU相比,L4的性能也表现出了非常好的结果,最高提升了6倍。”