模块化人工智能如何增强LLM

在人工智能和机器学习领域中,LLMs的推理速度和效率是关键因素。开发人员不断寻求减少延迟和计算成本,同时保持高模型性能的方法。模块化人工智能引擎提供了解决这一挑战的方案,使你能够无缝优化TensorFlow或PyTorch模型的推理性能。在本文中,我们将探讨模块化人工智能引擎的功能以及如何提升你的模型推理能力。

模型推理的挑战

随着机器学习模型变得越来越复杂和数据驱动,模型推理的计算需求也变得很大。许多开发者在部署模型到生产环境时都面临着推理时间过慢、资源利用率高和可伸缩性问题等挑战。

为了解决这些挑战,开发出了模块化人工智能引擎,这是一个强大的解决方案,可以加速模型推理。现在让我们深入了解如何利用它的潜力。

模块化人工智能引擎的介绍

模块化人工智能引擎是一个创新的系统,旨在优化模型推理。它通过将模型模块化和优化成高效的格式来实现这一目标。这种格式使得执行速度更快,并减少了推理所需的计算资源。结果是减少了延迟,提高了可伸缩性,并实现了成本节约。

模块化人工智能引擎的关键特点

1. 模型优化: 该引擎通过优化模型来减少推理时间和资源消耗。 它支持流行的机器学习框架,如TensorFlow和PyTorch。

2. 动态图执行: 模块化人工智能引擎支持动态图执行,适用于各种模型架构和输入大小。

3. 可伸缩性: 它可以高效地在多个CPU或GPU设备上进行扩展,非常适用于高需求的应用。

4. 易集成性: 借助其Python API,与现有的机器学习流水线的集成非常简单。

使用模块化人工智能引擎入门

模块化人工智能引擎简化了与复杂模型(如BERT)一起工作的过程,使我们能够专注于手头的任务,而不必处理复杂的模型配置。在本节中,我们将深入了解如何使用模块库来加载和运行BERT模型。

加载BERT模型

要开始使用模块化,我们首先需要加载预训练的BERT模型。这一步骤非常关键,因为它准备了模型进行高效的推理。让我们来看一下具体的步骤:

# Import the necessary modules

import numpy as np

from modular import engine

from pathlib import Path

# Create an InferenceSession

session = engine.InferenceSession()

# Specify the path to the BERT model (in this example, 'bert-base-uncased')

model_path = Path('bert-base-uncased')

# Load the model

model = session.load(model_path)

通过执行上述代码,我们现在已经将BERT模型加载到我们的Modular环境中。

检查模型输入

在我们开始进行预测之前,我们必须了解如何正确准备输入数据。为了做到这一点,我们需要知道模型输入张量的名称、形状和数据类型。以下是你可以访问这些信息的方法:

# Iterate through the model's input metadata

for tensor in model.input_metadata:

print(f'name: {tensor.name}, shape: {tensor.shape}, dtype: {tensor.dtype}')

# ########################## OUTPUT #################################

name: attention_mask, shape: [None, None], dtype: DType.int32

name: input_ids, shape: [None, None], dtype: DType.int32

name: token_type_ids, shape: [None, None], dtype: DType.int32

对于在这里使用的BERT模型,我们有三个输入张量:attention_mask,input_ids和token_type_ids。这些张量在其形状中有表示为空的动态维度。

进行推断:

现在我们已经加载了BERT模型并了解了其输入要求,让我们使用占位符输入数据运行一个示例推断。这演示了如何使用Modular AI Engine进行预测。

# Prepare placeholder input data

inputs = {

'attention_mask': np.zeros((1, 1), dtype=np.int32),

'input_ids': np.zeros((1, 1), dtype=np.int32),

'token_type_ids': np.zeros((1, 1), dtype=np.int32),

}

# Execute the inference

output = model.execute(**inputs)

# ########################## OUTPUT #################################

{

'pooler_output': array([[ 0.33634973, 0.4382758 ...]], dtype=float32),

'last_hidden_state': array([[[-0.13070619, 0.56097835 ...]]],dtype=float32)

}

在这个例子中,我们提供零作为输入数据的占位符。在实际应用中,你会用你实际的文本或序列来替换它。

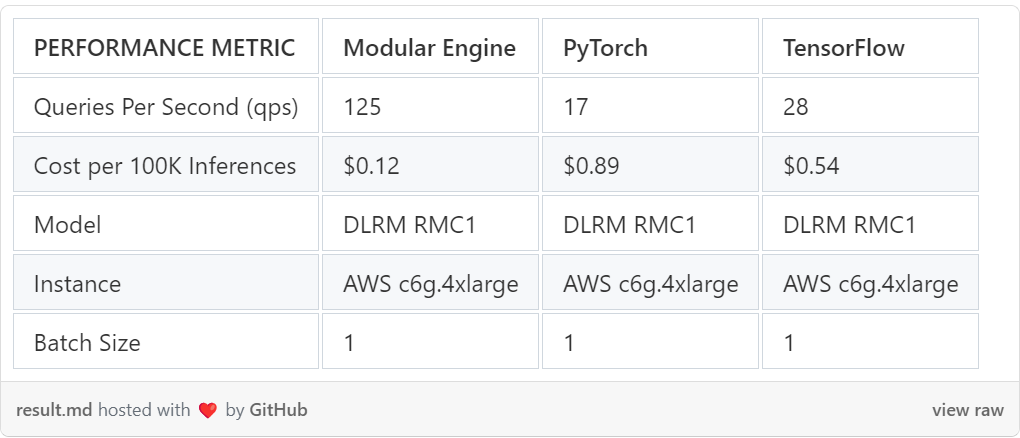

性能仪表盘

性能仪表盘是Modular提供的一个有价值的工具,你可以在Modular的基础设施上比较标准行业模型的性能。它提供了关于延迟、成本和查询吞吐量的洞察。以下是不同模型和配置的性能结果示例:

优化性能并将开支最小化

通过减少处理延迟、增加数据吞吐量,并在CPU、GPU和加速器之间有效管理资源,提高计算效率。扩展以部署更大的模型,同时大幅削减计算开支。

结论

在本文中,我们向你介绍了Modular AI Engine Python API,这是一个增强模型推理性能的强大工具。通过按照这里概述的简单步骤,你可以快速加载并执行你的TensorFlow或PyTorch模型,降低延迟和计算成本。无论你使用的是像BERT这样的自然语言处理模型还是其他机器学习模型,Modular AI Engine都可以帮助你实现最佳性能。