研究人员揭示了AI聊天机器人的局限性

看起来,可以与人类媲美的人工智能聊天机器人已经出现了。这些聊天机器人依赖于大型语言模型——一种特殊类型的神经网络。但是一项新的研究表明,大型语言模型仍然容易将无意义的内容误认为是自然语言。对于哥伦比亚大学(Columbia University)的研究团队来说,这一缺陷可能会指向提高聊天机器人性能的方法,并有助于揭示人类如何处理语言。

在《自然机器智能》(Nature Machine Intelligence)杂志在线发表的一篇论文中,科学家们描述了他们如何让九种不同的语言模型输出数百个句对。对于每对句子,参与研究的人们选择他们认为哪个句子更自然,也就是说,在日常生活中更有可能看到或听到。然后,研究人员测试这些模型,看它们是否会用与人类一样的评价方式对每对句子进行评分。

在一对一测试中,基于研究人员所称的transformer神经网络的更复杂的人工智能往往比简单的循环神经网络模型和只统计互联网或在线数据库中的词对频率的统计模型表现更好。但所有模型都犯了错误,有时会选择对人类来说听起来像胡言乱语的句子。

哥伦比亚大学(Columbia University)Zuckerman研究所的负责人、该论文的合著者Nikolaus Kriegeskorte博士说:“一些大型语言模型的表现如此出色表明,它们捕捉到了一些简单模型所缺失的重要信息。”他补充说:“即使是我们研究的最好模型在识别无意义句子时仍然会被欺骗,这表明它们的计算过程在处理人类语言方面还是缺少一些东西。”

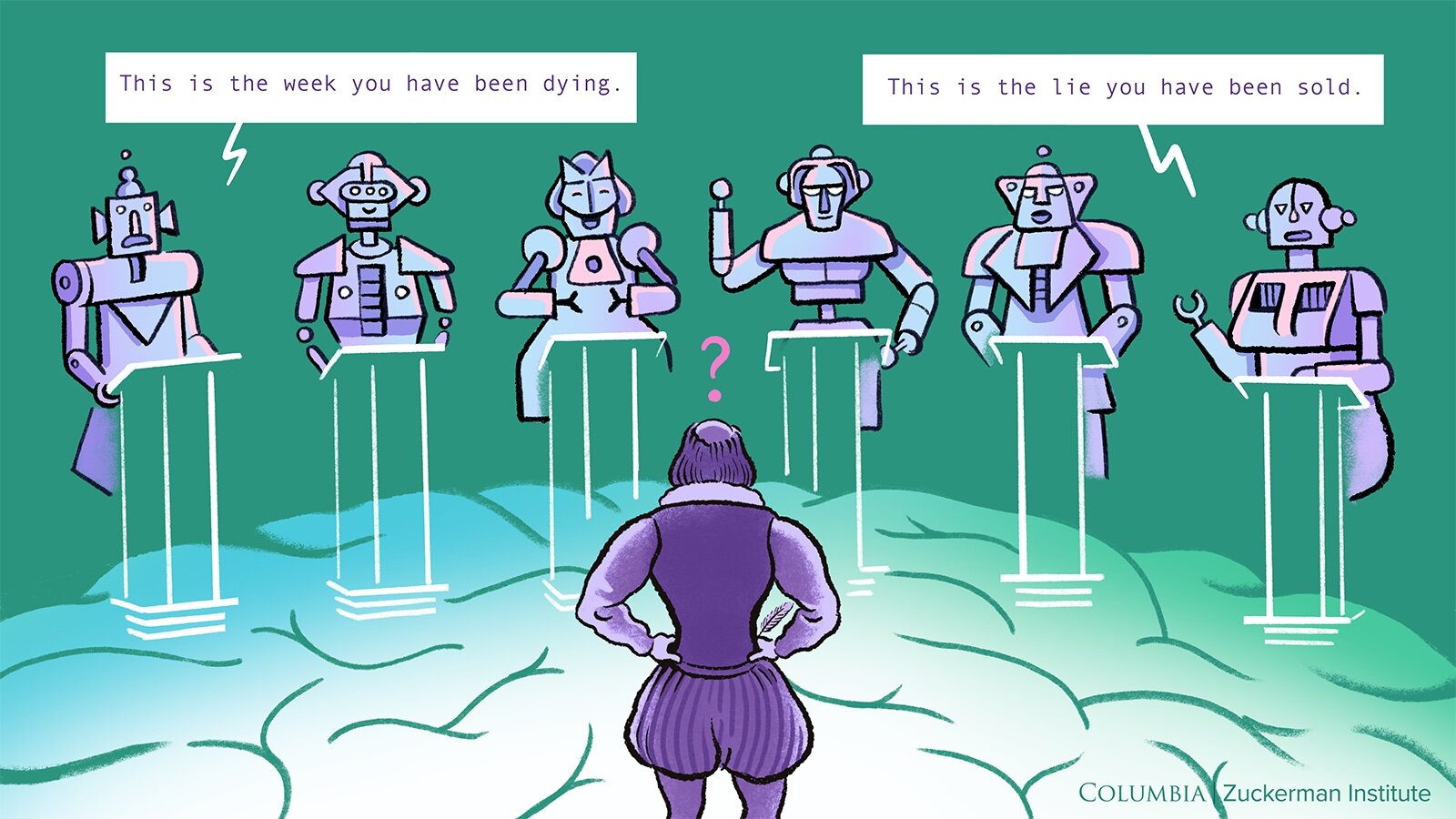

请考虑以下一对人类参与者和人工智能在研究中评估的句子:

1、That is the narrative we have been sold.

2、This is the week you have been dying.

在这项研究中给予这些句子的人们判断第一句更有可能遇到。但根据BERT这个较好的模型,第二句更自然。而最为广为人知的模型GPT-2则正确判断第一句更自然,与人类的判断相符。

本文的资深作者Christopher Baldassano博士说:“每个模型都存在盲点,将一些人类参与者认为是胡言乱语的句子标记为是有意义的。”他说:“这应该让我们对于是否应该让人工智能系统做出重要决策产生怀疑,至少目前是这样。”

许多模型的良好但不完美的性能是Kriegeskorte博士最感兴趣的研究结果之一。Kriegeskorte博士说:“了解这种差距的存在以及为什么一些模型比其他模型表现更好可以推动语言模型的进步。”

对于研究团队来说,另一个关键问题是人工智能聊天机器人的计算过程是否能够启发新的科学问题和假设,从而帮助神经科学家更好地理解人类大脑。这些聊天机器人的工作方式是否能够指向我们大脑的电路的某些特点?

进一步分析各种聊天机器人及其基础算法的优点和缺陷可能有助于回答这个问题。

该论文的通讯作者Tal Golan博士表示,“最终,我们对于了解人们如何思考感兴趣。”他说:“这些人工智能工具变得越来越强大,但它们处理语言的方式与我们不同。将它们的语言理解方式与我们的进行比较,让我们以新的方式思考我们的思维方式。”