DeepMind发现AI大型语言模型可以优化自己的提示

当人们编写新的深度学习AI模型时,其中绝大多数依赖于优化算法或优化器来确保模型具有足够高的准确性。但是,其中最常用的优化器——基于导数的优化器在处理现实世界的应用时会遇到问题。

在一份新的论文中,来自DeepMind的研究人员提出了一种新的方法:OPtimization by PROmpting(OPRO),这种方法使用了大型语言模型(LLM)作为优化器。这种方法的独特之处在于将优化任务定义为自然语言,而不是通过形式化的数学定义。

研究人员写道:“我们不是通过对优化问题进行正式定义并使用编程求解器来推导更新步骤,而是用自然语言描述优化问题,然后指示LLM根据问题描述和先前找到的解来迭代生成新的解。”

这种技术具有很高的适应性。只需修改问题描述或添加特定指令,就可以引导LLM解决各种各样的问题。

研究人员发现,在小规模的优化问题上,仅通过提示LLM就可以生成有效的解,有时甚至可以与专家设计的启发式算法的性能相匹配或超越。然而,OPRO的真正潜力在于其能够通过优化LLM的提示来从模型中获得最大精度。

OPRO的工作原理

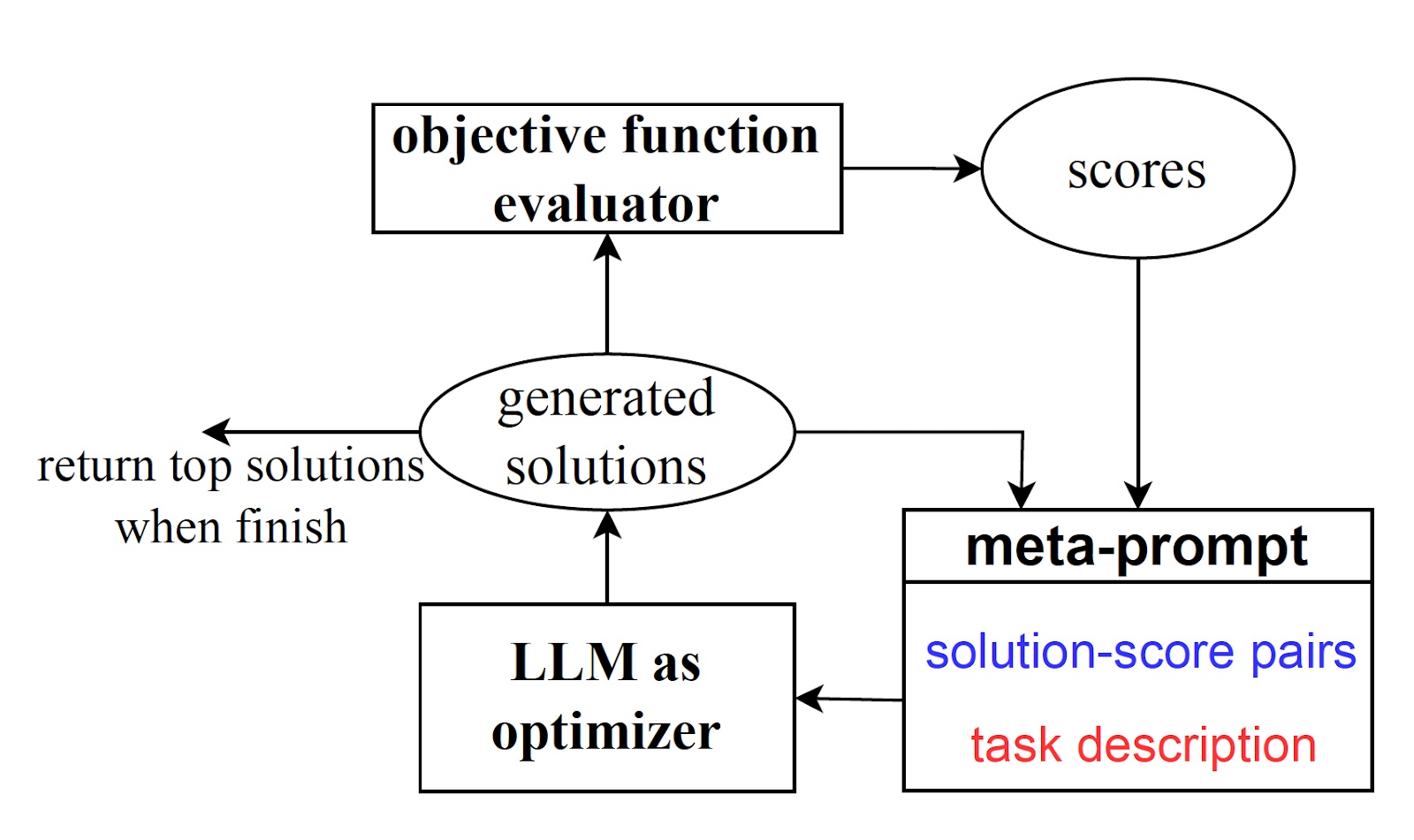

OPRO的过程始于输入一个“元提示”。这个元提示包括一个任务的自然语言描述,以及一些问题的示例、提示指令的占位符和相应的解。

随着优化过程的展开,大型语言模型(LLM)生成候选解。这些解基于问题描述和元提示中包含的先前解。

然后,OPRO评估这些候选解,并为每个解分配一个质量得分。优秀解和得分被添加到元提示中,为下一轮解生成提供丰富的上下文。这个迭代的过程会一直持续下去,直到模型停止生成更好的解为止。

研究人员解释道:“LLM在优化中的主要优势是其理解自然语言的能力,这使得人们可以在不需要正式规范的情况下描述他们的优化任务。”

这意味着用户可以指定目标指标,比如“准确性”,同时提供其他指令。例如,他们可以要求模型生成既简洁又广泛适用的解。

OPRO还利用了LLM检测上下文模式的能力。这使得模型能够根据元提示中包含的示例识别出一个优化轨迹。研究人员指出:“将优化轨迹包含在元提示中可以使LLM识别具有高得分的解的相似性,鼓励LLM基于现有的好解构建可能更好的解,而无需显式地定义如何更新解。”

为了验证OPRO的有效性,研究人员在两个众所周知的数学优化问题上进行了测试:线性回归和“旅行推销员问题”。虽然OPRO可能不是解决这些问题的最优方法,但结果还是令人鼓舞的。

研究人员报告说:“在这两个任务中,我们看到LLM们仅基于元提示中提供的过去优化轨迹就能够正确捕捉到小规模问题的优化方向。”

通过OPRO优化LLM提示

实验证明,提示工程可能极大地影响模型的输出。例如,将短语“让我们一步一步思考”附加到提示中可以引导模型进行推理,使其概述解决问题所需的步骤。这通常会导致更准确的结果。

然而,重要的是要记住,这并不意味着LLM具有类似人类推理的能力。它们的响应高度依赖于提示的格式,而语义上相似的提示可能会产生截然不同的结果。DeepMind的研究人员写道:“最佳提示格式可能是模型特定和任务特定的。”

OPRO的真正潜力在于其能够优化像OpenAI的ChatGPT和Google的PaLM这样的LLM的提示。它可以指导这些模型找到最佳的提示,以最大程度地提高任务准确性。

研究人员写道:“OPRO使LLM能够逐步生成新的提示,通过优化过程提高任务准确性,其中初始提示的任务准确性较低。”

为了说明这一点,考虑解决词语数学问题的最佳提示的任务。给定一个包含指令和带有优化提示的示例的元提示(例如,“让我们一步一步思考”),为“优化LLM”提供一个元提示。该模型生成一组不同的优化提示,并将它们传递给“评分LLM”。评分LLM在问题示例上测试这些提示并评估结果。最佳提示以及其得分被添加到元提示的开头,然后重复此过程。

研究人员使用来自PaLM和GPT系列的几个LLM对这种技术进行了评估。他们发现,“我们评估的所有LLM都能够充当优化器,在迭代优化过程中始终提高生成提示的性能,直到收敛为止。”

例如,当在GSM8K上测试PaLM-2的OPRO时,GSM8K是一个基于学校数学词语问题的基准测试,模型产生了有趣的结果。它以提示“让我们解决问题”开始,并生成了其他字符串,如“让我们仔细思考问题并共同解决”,“让我们分解问题”,“让我们计算出解”,最后是“让我们进行数学计算”,提供了最高的准确性。

在另一个实验中,加上字符串“深呼吸并逐步解决此问题”,可以获得最准确的结果。

这些结果既令人着迷又有些令人不安。对于人类来说,所有这些指令都具有相同的意义,但它们在LLM中触发了非常不同的行为。这提醒我们不要将人类化的特点赋予LLM,并突显了我们对它们内部运作方式还有多少需要学习的地方。

然而,OPRO的优势是明显的。它提供了一种系统的方法来探索可能的LLM提示空间,并找到适用于特定类型问题的最佳提示。它在实际应用中的表现如何还有待观察,但这项研究可以为我们对LLM工作原理的理解迈出一步。