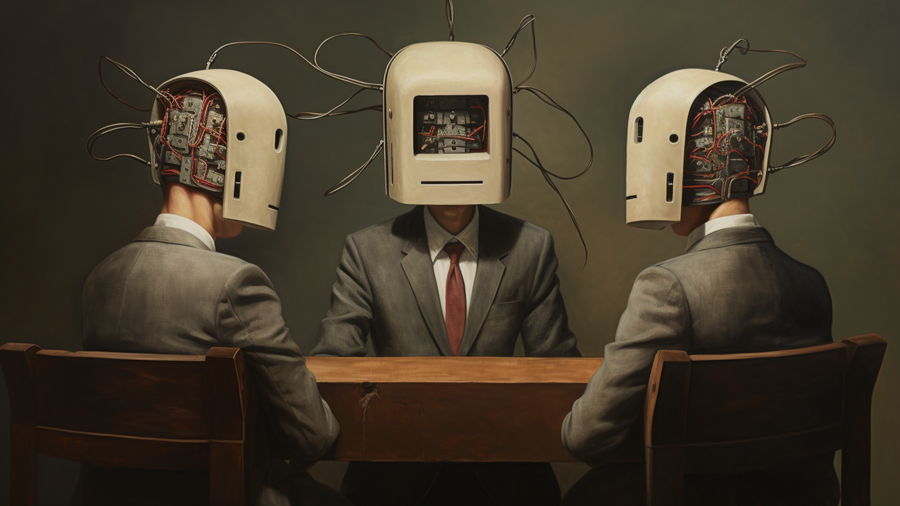

多人工智能协作有助于提升大型语言模型性能

在我们的成长岁月中经常听到一句古老至理名言,那就是:一个脑袋不如两个脑袋。这句谚语鼓励协作思考,突显了共享智慧的威力。

快进到2023年,我们发现这个智慧甚至在人工智能领域也同样适用:多个语言模型合作比单个效果更好。

最近,麻省理工学院计算机科学与人工智能实验室(CSAIL)的一个团队将这句古老智慧体现在现代技术的前沿。他们提出了一种策略,利用多个人工智能系统进行讨论,以得出一个更好的答案。这种方法能够提高语言模型对事实数据的遵守程度,并完善它们的决策。

大型语言模型(LLM)的问题关键在于它们生成的回答不一致,导致潜在的不准确和有缺陷的推理。这种新方法让每个agent主动评估其他agent的回答,并使用集体反馈来改进自己的回答。在技术术语上,这个过程包括多轮回应生成和评论。每个语言模型对给定的问题生成一个答案,然后结合来自所有其他agent的反馈来更新自己的回答。这个迭代循环以模型解决方案的多数投票为结果。它在某种程度上反映了小组讨论的动态——个体为达成一个统一而有理性的结论做出贡献。

这种方法的一个实际优势在于它能够无缝应用于现有的黑盒模型。由于这种方法围绕生成文本展开,它也可以在各种LLM上实施,而不需要访问它们的内部工作原理。研究团队表示,这种简单性可以帮助研究人员和开发人员使用该工具来提高整体上语言模型输出的一致性和事实准确性。

麻省理工学院电气工程和计算机科学博士生、麻省理工学院CSAIL的学生Yilun Du表示:“我们采用一种新颖的方法,不仅仅依赖一个单一的AI模型来回答问题。相反,我们的过程利用多个AI模型,每个都带来了对问题的独特见解。尽管它们的初始回答可能看起来不全面或含有错误,但这些模型可以通过审查对方的回答来改进自己的回答。”Du还说:“随着这些AI模型进行交流和讨论,它们更有能力识别和纠正问题,提高解决问题的能力,并更好地验证其回答的准确性。本质上,我们创造了一个迫使它们深入问题核心的环境。单一的孤立的AI模型常常只是重复互联网上的内容,然而,我们的方法积极地激发了AI模型制定更准确和全面解决方案的能力。”

该研究关注数学问题的解决,包括小学、中学和高中的数学问题,并通过多agent辩论的过程显著提升了性能。此外,语言模型展示了产生准确算术评估的增强能力,并展现出在不同领域的潜力。

这种方法还可以帮助解决常常困扰语言模型的“幻觉”问题。通过设计一个环境,使agent互相评议回答,它们更有动力避免随机信息的产生,优先考虑事实的准确性。

除了应用于语言模型,这种方法还可以用于将具有专门能力的不同模型整合起来。通过建立一个多个agent相互交流和辩论的去中心化系统,它们有可能在语音、视频或文本等各种模态下使用这些全面而高效的问题解决能力。

尽管这种方法产生了优秀的结果,但是研究人员表示现有的语言模型可能面临处理非常长的上下文的挑战,而且评价能力可能没有理想的那么完善。此外,灵感来自人类群体互动的多agent辩论形式尚未纳入对智能集体决策有贡献的更复杂形式的讨论,这是未来探索的一个关键领域。团队表示,推动这一技术的发展可能涉及对人类辩论和讨论背后的计算基础的进一步理解,并使用这些模型来增强或补充现有的LLM。