NExT-GPT:处理文本、图像、视频和音频的多模态大型语言模型

新加坡国立大学(NUS)的NExT研究中心最近开源了NExT-GPT,这是一个“any-to-any”多模态大型语言模型(LLM),可处理文本、图像、视频和音频作为输入或输出。NExT-GPT基于现有的预训练模型,并且在训练过程中只需要更新总参数的1%。

NExT-GPT具有基于聊天的界面,用户可以键入文本或上传图像、视频或音频文件。该模型能够理解输入内容并回答相关问题,或根据用户的请求生成文本、图像、视频或音频。该系统基于开源的预训练编码器和解码器,包括Vicuna和Stable Diffusion,并在其间加入可训练的神经网络层。这些层使用NExT团队发明的一种叫做异态切换指令调整(MosIT)的技术进行训练。根据NExT团队表示:

“总体而言,我们的研究展示了建立一种能够建模普遍模态的AI代理的有希望可能性,为社区中更接近人类的AI研究打开了道路。”

基于LLMs的多模态人工智能是一个活跃的研究领域。2022年,InfoQ报道了DeepMind的Flamingo,将预先训练的视觉模型和语言模型结合起来,可以回答关于输入图像和视频的问题。早些时候,OpenAI的GPT-4可以处理图像输入,此外还有微软的两个视觉语言模型:Visual ChatGPT,它使用ChatGPT调用不同的视觉基础模型执行任务;还有LLaVA,结合了用于视觉的CLIP和用于语言的LLaMA,并通过附加的网络层将两者联系在一起,进行端到端的视觉指令调整训练。

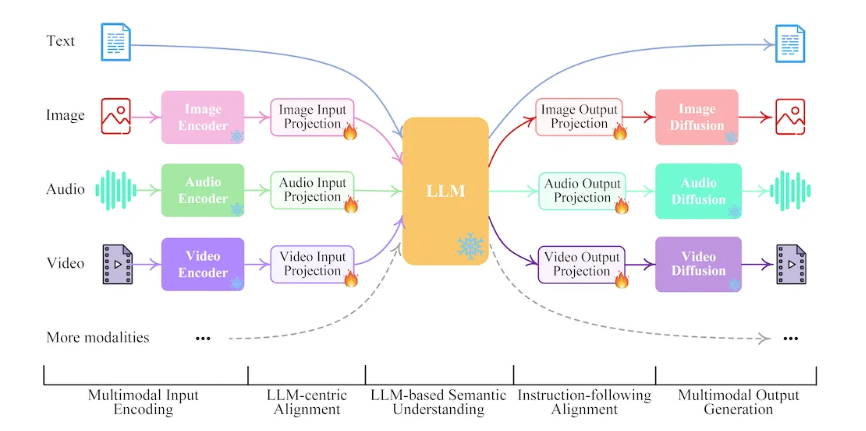

NExT-GPT的架构包括三个层次:编码阶段加上线性投影,将各种输入模态映射到一个统一的空间;Vicuna LLM “核心”,生成标记,包括表示使用哪种输出模态的信号标记;解码阶段由模态特定的变压器层和解码器组成。由于编码器、解码器和Vicuna模型都是固定的,在训练过程中,只有大约1%的模型总参数需要更新,这节省了训练成本。

与微软的LLaVA类似,NExT-GPT使用指令调整进行训练。对于NExT-GPT,新加坡国立大学的团队为人类用户和聊天机器人之间的对话制作了一个示例数据集。对话包含三至七个转换,并涵盖了输入和输出中的多种模态。团队使用ChatGPT和其他生成式人工智能模型,包括Midjourney等,来帮助生成这些示例。总的来说,该数据集包含约5,000个对话。

研究人员在几个多模态生成基准测试上评估了NExT-GPT的性能。虽然没有达到最先进的结果,但该模型与基准模型的表现相当。团队还请人工评审在几种情景中对模型的输出进行评分,按照1到10的比例排名。评审员在图像生成情景中给出的评分比视频和音频高。