Meta发布Llama 2 Long,超越GPT-3.5 Turbo和Claude 2

在本周举行的Meta Connect大会上,Meta平台展示了其面向消费者的服务Facebook、Instagram和WhatsApp的一系列新的人工智能功能。

不过,这家马克·扎克伯格公司最重大的消息可能是由Meta研究人员在开放访问和非同行评审网站arXiv.org上发布的一篇计算机科学论文,而并没有公开宣传。

这篇论文介绍了Llama 2 Long,这是基于Meta今年夏天发布的开源Llama 2的一个新的人工智能模型,经过“使用长训练序列和上采样长文本的数据集,持续从Llama 2进行预训练” ,研究人员在论文中写道。

由于这个原因,Meta的这个新的延长型人工智能模型在生成对长用户提示的回复方面超越了一些领先竞争对手,包括OpenAI的GPT-3.5 Turbo(具有16,000个字符上下文窗口),以及Claude 2(具有100,000个字符上下文窗口)。

Llama 2 Long的诞生

Meta研究人员选取了不同训练参数大小的原始Llama 2——算法能够在学习过程中自行更改的数据和信息值,对于Llama 2来说,这些值分别为70亿、130亿、340亿和700亿个变种,并在原始Llama 2的训练数据集中增加了更多的长文本数据源,准确来说,是额外的4000亿个令牌。

然后,研究人员保持了原始Llama 2的结构不变,只对定位编码进行了“必要的修改”,这在模型需要注意更长内容时至关重要。

这个修改是对转置位置嵌入(RoPE)编码的改变,RoPE编码是一种为Llama 2(以及Llama 2 Long)之类的语言模型中的转换模型编程的方法,实际上将它们的令牌嵌入(用于表示单词、概念和思想的数字)映射到一个3D图上,显示它们相对于其他令牌的位置,即使在旋转的情况下也能如此。这使得模型能够生成准确而有用的回复,所需信息较少(因此占用的计算存储空间也较少)。

Meta的研究人员将RoPE编码的旋转角度从Llama 2减小到Llama 2 Long,这使他们能够确保模型的知识库中包含更多“远程令牌”——即出现频率较低或与其他信息关系较少的令牌。

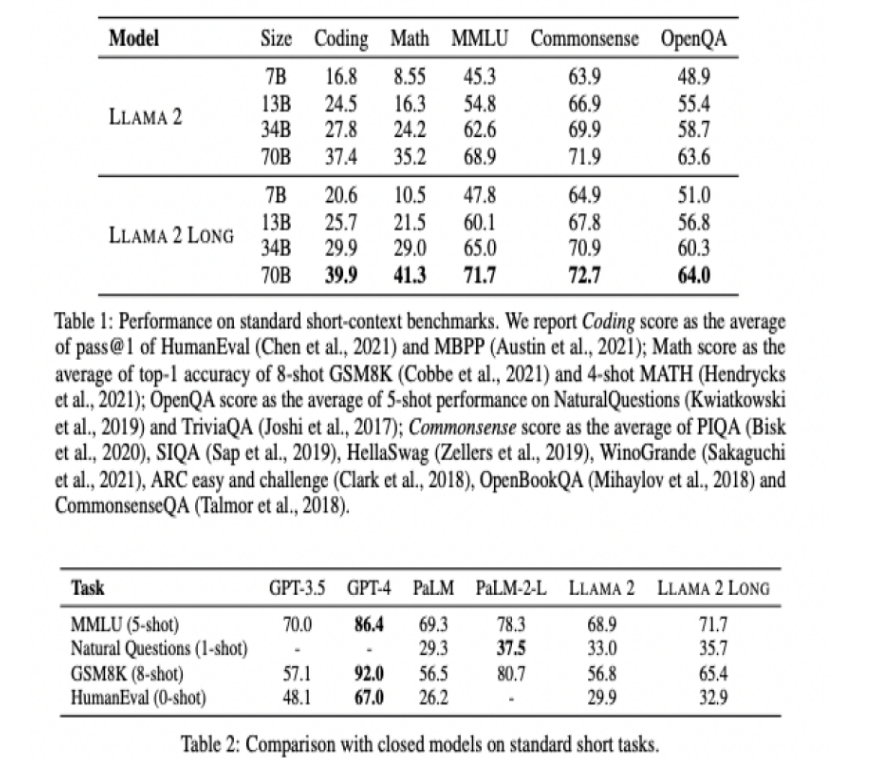

通过使用人类反馈的强化学习(RLHF)和由Llama 2 chat自动生成的合成数据,这是一种常见的人工智能模型训练方法,其中AI在正确回答问题时得到人类监督的奖励,研究人员能够提高其在常见的语言模型任务中的性能,包括编码、数学、理解语言、常识推理和回答用户提出的问题。

考虑到Llama 2对比普通LLama 2以及Anthropic的Claude 2和OpenAI的GPT-3.5 Turbo的卓越表现,不难理解为什么Reddit、Twitter和Hacker News上的开源AI社区对Llama 2自论文发布之初就表达了他们的钦佩和兴奋之情——这是对Meta“开源”方法在生成模型AI领域的一大验证,并表明开源可以与资金充足的初创公司提供的封闭源、需要付费才能使用的模型相竞争。