LLaVA-1.5:开源多模态大模型挑战GPT-4V

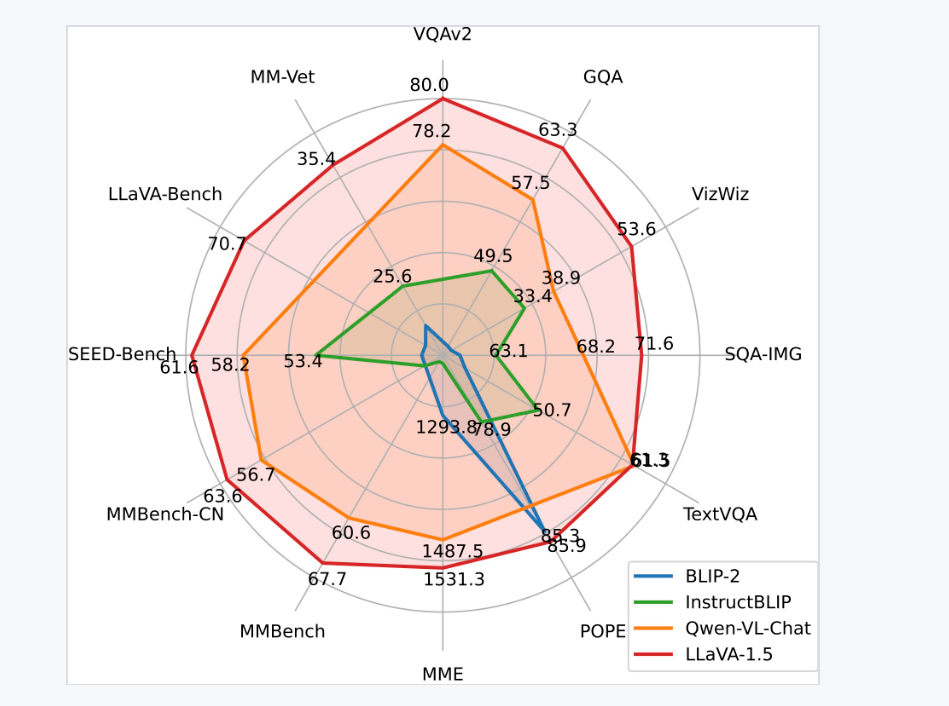

LLaVA-1.5是一款由威斯康星大学麦迪逊分校、微软研究院和哥伦比亚大学的研究人员共同开源的多模态大模型。最近,LLaVA-1.5在11个基准测试中展现出了新的状态最优(SOTA)成绩,涵盖了视觉问答、图像描述等任务,证明了它强大的多模态理解能力,从而成为OpenAI的GPT-4V的有力竞争对手。

相较于LLaVA的早期版本,LLaVA-1.5采用了更高分辨率的图像输入、更大规模的语言模型(拥有13B个参数),并且基于面向学术任务的视觉问答数据集进行了训练,显著提升了性能。

研究人员发现,在提升多模态能力方面,相较于大规模预训练,视觉指令微调发挥着更为关键的作用。

令人惊奇的是,LLaVA-1.5采用了非常简单的架构设计,只需在公开可获取的600万个图像文本配对上训练一个全连接层,就能够在多个基准测试中击败复杂的SOTA系统,并刷新记录。使用8个A100 GPU训练LLaVA-1.5仅需一个工作日的时间。

这一研究表明,通过简单的架构设计和使用公共数据,开源的大型模型能够获得很高的竞争力,为未来的研究提供了宝贵的经验。LLaVA-1.5以其出色的多模态理解能力引起了业界对"硬杠GPT-4"的关注。

最近,OpenAI宣布解除ChatGPT的多模态能力限制。多模态GPT-4V的神奇能力令人惊叹,让人们开始将其与GPT-4.5相提并论。然而,很快出现了LLaVA-1.5作为GPT-4V的开源竞争对手。

研究人员通过使用带有MLP映射的CLIP-ViT-L-336px,并引入简单响应格式提示的面向学术任务的视觉问答数据集,显著提升了LLaVA-1.5的性能。实验结果显示,LLaVA-1.5的设计更为简单,只需使用120万个公开数据,就能超越使用14.5亿个数据训练的Qwen-VL和1.3亿个数据训练的HuggingFace IDEFICS(类似于Flamingo的80B模型)。此外,使用13B参数模型的训练仅需8块A100 GPU,并可在一天内完成。

综上,LLaVA-1.5是一款开源的多模态大模型,取得了SOTA成绩,展现了强大的多模态理解能力,成为了GPT-4V的有力竞争对手。通过简单的架构设计和公共数据,LLaVA-1.5打破了多个基准测试的记录。其出现为未来的研究提供了有价值的经验。