Google DeepMind推出DRaFT:优化扩散模型的直接奖励微调方法

扩散模型在各种数据类型的生成建模方面带来了革命性的变革。然而,在一些实际应用场景中,比如从文本描述生成美观的图像,通常需要进行微调。文本到图像扩散模型采用了一些技术,如无分类器引导和精选数据集(比如LAION美学数据集),以提升对齐和图像质量。

在研究中,作者们提出了一种简单而高效的基于梯度奖励微调方法,通过梯度反向传播整个采样过程,从而实现对扩散模型的微调。他们引入了直接奖励微调(DRaFT)的概念,即通过对一个长度为50步的展开计算图进行反向传播来实现梯度计算。为了有效地管理计算和内存开销,他们采用了梯度检查点技术并优化LoRA权重,而不是修改整个模型参数。

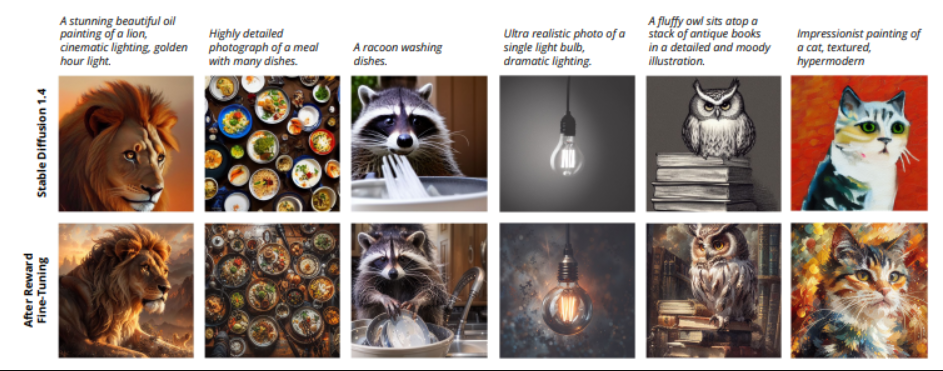

上述图片展示了使用人类偏好奖励模型进行DRaFT的过程。此外,作者们还对DRaFT方法进行了一些改进,以提高其效率和性能。首先,他们提出了DRaFT-K,这是一种改进版,仅在计算微调梯度时对最后K步的采样进行反向传播。实验证明,这种截断梯度方法相较于全反向传播在相同的训练步骤下能够更好地防止梯度爆炸的问题。

此外,作者们还引入了DRaFT-LV,这是DRaFT-1的一种改进版,通过对多个噪声样本进行平均计算,从而得到方差更低的梯度估计,进一步提高了方法的效率。

研究人员将DRaFT应用于Stable Diffusion 1.4 ,并使用各种奖励函数和提示集进行了评估。他们的方法在利用梯度进行微调方面相比基于强化学习的微调算法表现出了明显的效率优势。例如,相比强化学习算法,DRaFT在最大化LAION美学分类器分数时实现了超过200倍的速度提升。

DRaFT-LV是作者们提出的一个改进版本,展示了出色的效率,学习速度大约是之前基于梯度微调方法ReFL的两倍。此外,作者们还展示了DRaFT的灵活性,他们可以通过调整LoRA权重来将DRaFT模型与预训练模型进行结合或插值。

总而言之,通过基于可微分的奖励对扩散模型进行直接微调,为改进生成建模技术提供了一条有前途的途径,这不仅适用于图像和文本等应用领域,还具有更广泛的应用价值。DRaFT方法的高效性、灵活性和有效性使其成为机器学习和生成建模领域的研究人员和从业者不可或缺的工具。