DeepMind研究发现LLM无法在推理任务中自我纠正

科学家们正在发明各种策略来提高大型语言模型(LLM)如检索增强和思维链推理的准确性和推理能力。

其中,“自我纠正”是一种技术,即LLM可以改进其自身的响应,它在许多应用中显示出了有效性。然而,它成功的机制仍然不清楚。

最近,Google DeepMind与伊利诺伊大学厄巴纳—香槟分校合作进行的一项研究揭示出,LLM在没有外部反馈的情况下自我纠正其响应时经常出错。事实上,研究表明自我纠正有时可能会损害这些模型的性能,挑战了对这种流行技术的普遍理解。

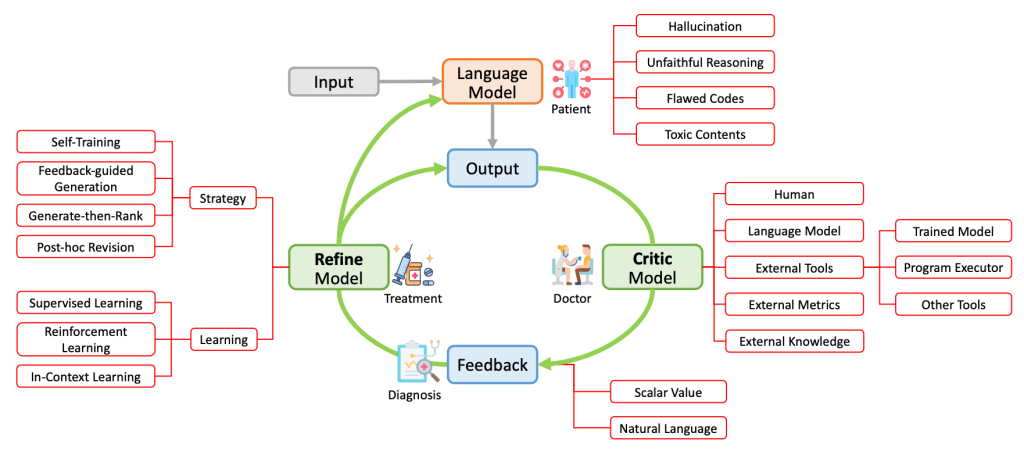

什么是自我纠正?

自我纠正是建立在LLM可以评估其输出的准确性并改进其响应的思想基础上的。例如,一个LLM可能在一道数学问题中一开始回答错误,但在检查自己的输出和推理后纠正答案。

一些研究观察到了这个过程,也被称为“自我批评”,“自我改进”或“自我提高”。

然而,自我纠正的有效性并不适用于所有任务。DeepMind和伊利诺伊大学的论文揭示了自我纠正的成功在很大程度上取决于所处理任务的性质。在推理任务中,自我纠正技术通常只有在能够利用外部资源(如人类反馈、计算器或代码执行器以及知识库)时才能成功。

研究人员强调高质量的反馈在许多应用中并不总是可获得的事实。因此,了解LLM的内在能力以及自我纠正能力多少归因于模型的内部知识非常重要。他们引入了“内在自我纠正”的概念,指的是模型仅基于其内建的能力,而没有任何外部反馈的情况下试图纠正其初始反应的场景。

测试推理任务上的自我纠正

研究人员在几个基准测试中对自我纠正进行了测试,这些测试用于衡量模型在解决数学应用题、回答多项选择题和需要推理的问答问题方面的表现。他们采用了三步自我纠正过程。首先,他们提示模型回答一个问题。接下来,他们要求模型检查其先前的回答。最后,他们第三次提示模型根据其自动生成的反馈来回答原始问题。

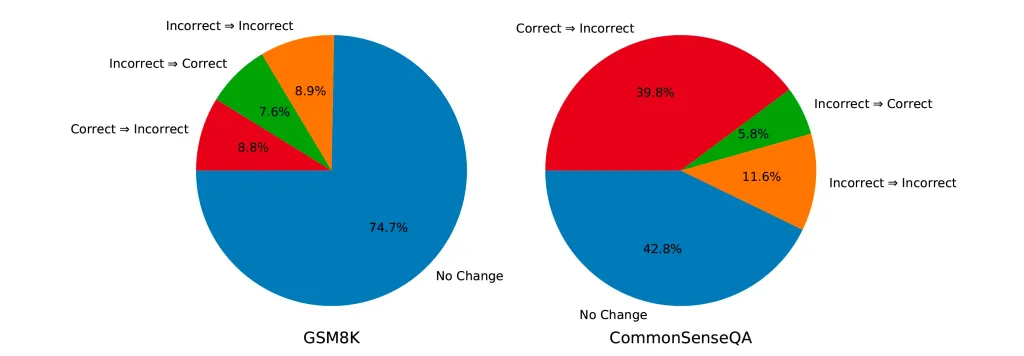

他们的研究结果显示,当模型可以访问基准数据集中包含的真实标签时,自我纠正可以有效地工作。这是因为算法可以准确地确定何时停止推理过程并避免在答案已经正确的情况下改变答案。正如研究人员所说:“这些结果使用真实标签来防止模型把正确答案改为错误答案。然而,确定如何防止这种错误的更改实际上是确保自我纠正成功的关键。”

然而,这个假设并不符合现实情况,实际场景中并不总是有真实标签可供使用。如果真实标签可以轻易获得,就不需要使用机器学习模型来预测它了。研究人员表明,当他们从自我纠正过程中去掉这些标签时,模型的性能开始显著下降。

有趣的是,模型经常在最初给出正确答案,但在自我纠正之后转为给出错误答案。例如,在GPT-3.5-Turbo(在ChatGPT的免费版本中使用的模型)中,当应用自我纠正技术时,其在CommonSenseQA问答数据集上的性能几乎下降了一半。GPT-4也表现出了性能下降,尽管幅度较小。

根据研究人员的说法,如果模型与一个合理设计的初始提示相匹配,“在给定提示条件和特定解码算法条件下,初始回答应该已经是最优的”。在这种情况下,引入反馈可以被视为添加了一个额外的提示,可能会偏离最优提示来影响模型的响应。“在推理任务中,对于内在自我纠正设置来说,这个补充提示可能不提供任何额外的优势来回答问题。实际上,它甚至可能使模型偏离产生最优初始回答的情况,导致性能下降。”研究人员写道。

自我纠正在多代理LLM应用中也很常见。在这些场景中,多个ChatGPT实例等LLM被赋予不同的指令,在多方辩论中扮演不同的角色。例如,一个代理可能负责生成代码,而另一个则指导其审查代码中的错误。

在这些应用中,自我纠正是通过教导代理互相评论对方的回答来实现的。然而,研究人员发现这种多代理互评并不会通过辩论形式带来任何改进,而是会导致一种“自我一致性”,即不同的代理会产生多个回答,然后进行多数投票来选择一个答案。

“与其将多代理辩论称为一种“辩论”或“评论”形式,更恰当地将其视为实现多个模型生成结果“一致性”的手段。”研究人员写道。

事后提示和事前提示

虽然自我纠正可能不会增强推理能力,但研究人员发现它在修改LLM输出风格或使响应更安全等任务中可以发挥作用。他们将这些任务称为“事后提示”,即在生成响应之后应用提示。他们写道:“自我纠正增强模型响应的情况出现在它可以提供有价值的指导或反馈,而事前提示不能提供的情况下。”

该论文的另一个重要发现是,某些任务中归因于自我纠正的改进可能是由于一个构造不良的初始指示而被精心构建的反馈提示超越。在这种情况下,将反馈融入初始指示,即所谓的“事前提示”,可以取得更好的结果并减少推理成本。研究人员表示:“将一个精心设计的事后提示用于引导模型“自我纠正”一个通过错误构造的事前提示生成的响应是没有意义的。为了公平比较,应在事前和事后提示中都投入同等的努力。”

研究人员最后敦促研究和实践社群以怀疑的眼光来对待自我纠正的概念,并谨慎应用它。

“研究人员和从业者有必要以审慎的态度对待自我纠正的概念,承认其潜力并认识到其局限性。”研究人员写道。“通过这样做,我们可以更好地装备这种技术来应对LLM的局限性,推动其向更高的准确性和可靠性演进。”