揭示词嵌入的力量

介绍

SkipGram是一种自然语言处理(NLP)技术,在词向量嵌入领域取得了显著进展,为机器学习、文本分析和语言理解的发展做出了贡献。SkipGram作为Word2Vec的一部分,其创建了能够捕捉语义关系的词的分布式表示而特别有名。在本文中,我们将深入探讨SkipGram的细节,探索其内部工作,并研究其在各个领域中的应用。

理解词嵌入

词嵌入是现代NLP和机器学习的重要组成部分。它们是词语的向量表示,使得机器能够以计算有用的方式理解词语的含义。传统上,语言模型将词语视为离散的实体,没有内在的联系,这使得机器难以把握词语之间的语义关联。诸如SkipGram所生成的词嵌入正是为了解决这个局限。

SkipGram的内部机制

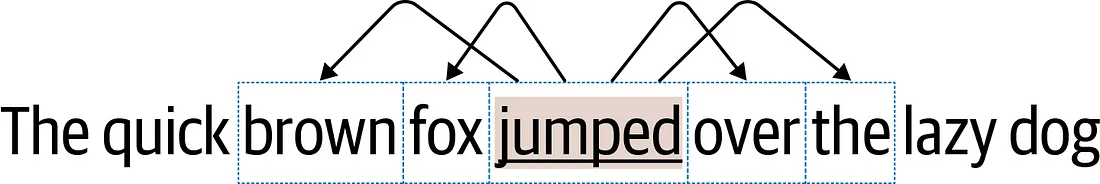

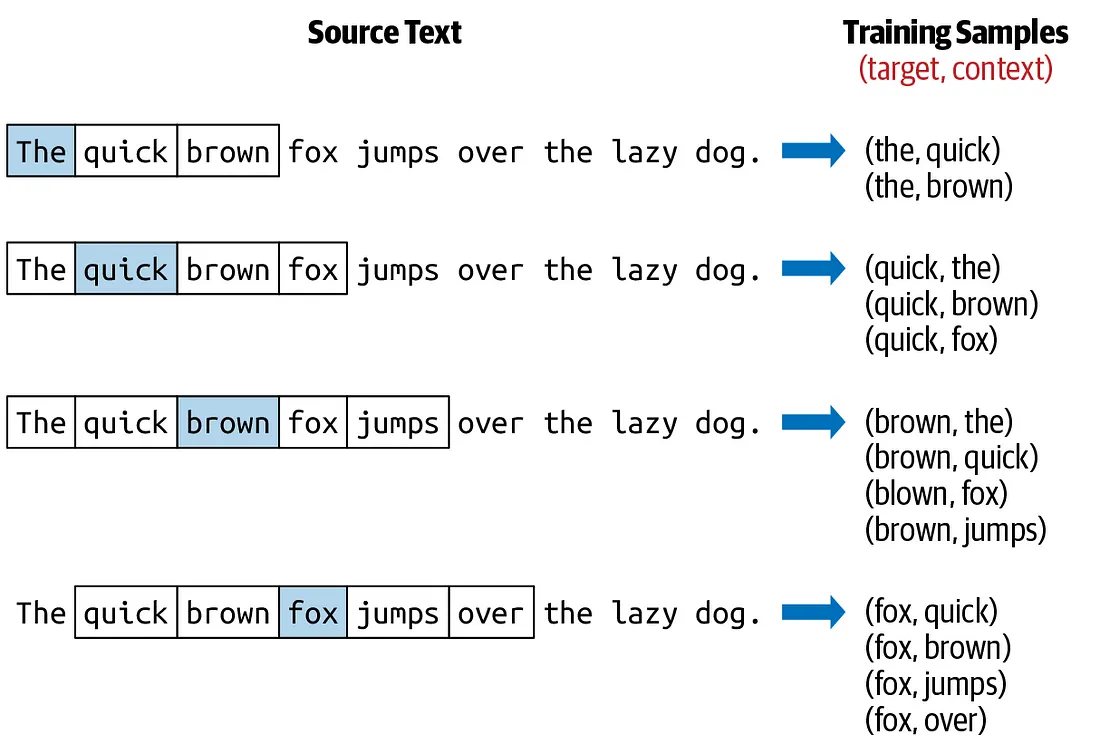

SkipGram的工作原理简单而强大:给定一个目标词,预测其周围的上下文词语,反之亦然。关键思想是以这样一种方式创建向量,使得具有相似含义或使用模式的词语在高维空间中彼此接近。让我们来详细了解这个过程:

1. 数据准备:SkipGram以大量文本语料库(如书籍、文章或网页)开始。它创建一个包含唯一词语并为每个词语分配一个ID的词汇表。

2. One-Hot编码:词汇表中的每个词语都被表示为一个一位有效编码向量,即一个二进制向量,在对应词语的ID位置上只有一个‘1’。

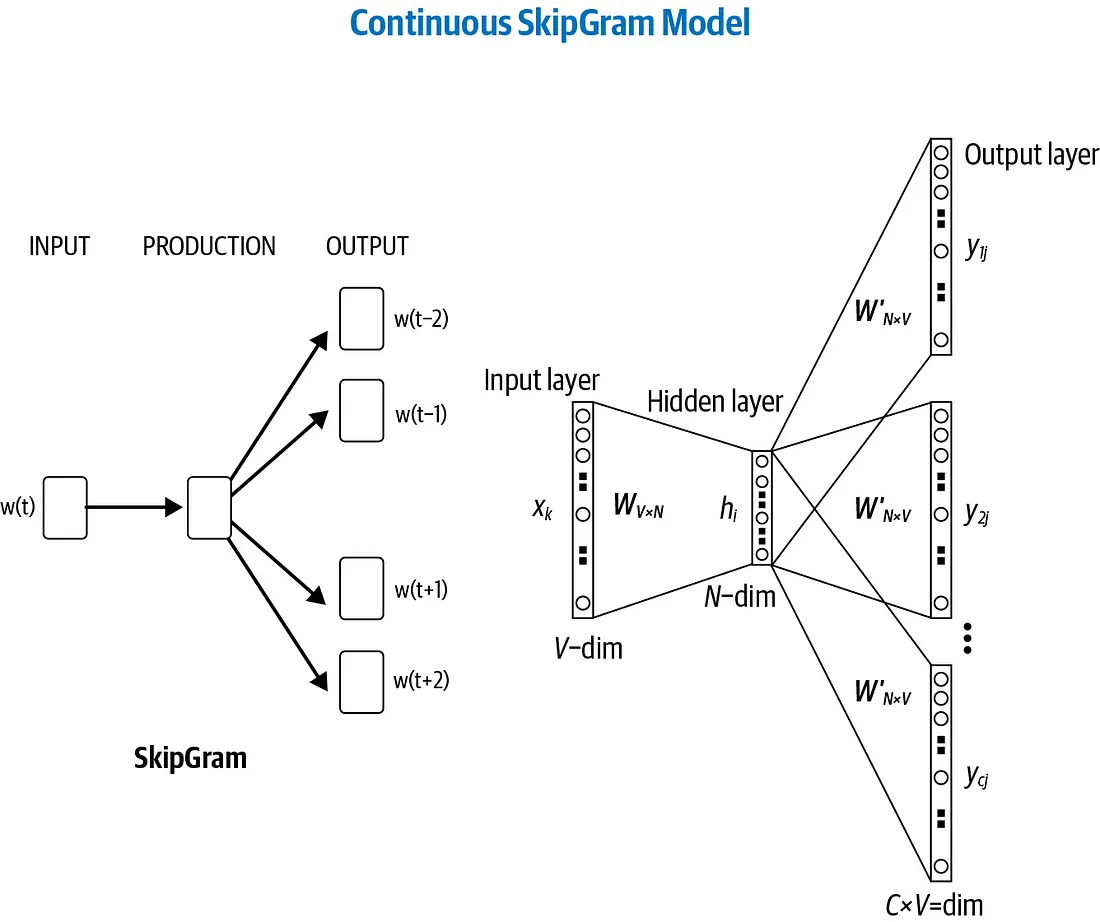

3. 神经网络架构:SkipGram采用浅层神经网络,通常是前馈神经网络,其中输入是表示目标词的一位有效编码向量。神经网络的任务是预测上下文词语的一位有效编码向量。

4. 训练:使用反向传播和随机梯度下降算法对神经网络进行训练。目标是最小化预测上下文词语与实际出现在目标词周围的上下文词语之间的差异。

5. 向量生成:神经网络的隐藏层用作词嵌入。这些向量代表了高维空间中词语及其之间的关系。

SkipGram的应用领域

SkipGram的词嵌入已在不同领域找到广泛应用:

1. 自然语言处理:SkipGram的词嵌入已成为自然语言处理任务(包括文本分类、情感分析和机器翻译)的基本组成部分。这些词嵌入使得模型能够更好地理解句子中词语的上下文和含义。

2. 信息检索:在搜索引擎中,SkipGram通过理解查询词和文档之间的语义关系,提高了搜索结果的相关性。

3. 推荐系统:SkipGram用于加强推荐系统,通过理解用户偏好和内容描述的语义,提高推荐的准确性。

4. 情感分析:在情感分析中起到关键作用,帮助机器通过捕捉词语选择中的微妙细微之处,辨别文本的情感倾向。

5. 语言生成:在文本生成和聊天机器人等任务中,可以利用SkipGram的词嵌入生成连贯且与上下文相关的文本。

6. 异常检测:SkipGram的词嵌入用于通过理解上下文中的典型词语使用来识别文本数据中的异常模式。

挑战和未来发展方向

尽管SkipGram在NLP和相关领域取得了重要进展,但它并非没有挑战。其中一些挑战包括处理多义词(具有多个含义的词语)、捕捉长程依赖以及处理低频词语等。研究人员正在不断努力解决这些问题,改进词嵌入的性能。

未来我们可以期待看到更先进的技术和模型,这些技术和模型将建立在SkipGram的基础上。随着NLP和机器学习的不断发展,像SkipGram生成的词嵌入将在增强AI系统能力中发挥重要作用。

代码

在Python中从头开始实现SkipGram而不使用外部库是一项复杂的任务,因为它需要高效的神经网络操作、梯度下降和数据预处理。这超出了单个回答的范围,但我可以提供一个简化的示例,以便让你对如何处理此问题有所了解。请注意,对于用于生产级别的SkipGram模型,通常会依赖于TensorFlow或PyTorch等深度学习库。

用于训练 SkipGram 模型的浅层网络如下所示,与用于 CBOW 的网络非常相似,只有一些微小的改变。在输入层中,使用目标词在目标中的索引来提取对应的行,从嵌入矩阵 E|V| x d 中。提取的向量然后传递到下一层。

下一个层次只需将这个d维向量与另一个矩阵E'd x | V |相乘。这给出了一个1x | V | 向量,将其输入到softmax函数中以获得词汇空间上的概率分布。该分布与标签进行比较,并使用反向传播来相应地更新矩阵E和E'。在训练结束时,E就是我们想要学习的嵌入矩阵。

这是一个简化的SkipGram代码,没有使用外部库,使用一个小型数据集和基本操作。

import numpy as np

# Sample text corpus

corpus = "the quick brown fox jumps over the lazy dog"

# Tokenize the corpus

tokens = corpus.split()

# Create a vocabulary

vocab = list(set(tokens))

vocab_size = len(vocab)

word_to_index = {word: i for i, word in enumerate(vocab)}

index_to_word = {i: word for i, word in enumerate(vocab)}

# Hyperparameters

embedding_dim = 100

window_size = 2

learning_rate = 0.01

epochs = 100

# Initialize word vectors randomly

word_vectors = np.random.rand(vocab_size, embedding_dim)

# SkipGram training

for epoch in range(epochs):

for target_index in range(len(tokens)):

target_word = tokens[target_index]

target_vector = word_vectors[word_to_index[target_word]]

context_indices = list(range(max(0, target_index - window_size), min(len(tokens), target_index + window_size + 1)))

context_indices.remove(target_index)

for context_index in context_indices:

context_word = tokens[context_index]

# Negative sampling (not implemented here)

# Calculate the error

error = target_vector - word_vectors[word_to_index[context_word]]

# Update word vectors

word_vectors[word_to_index[context_word]] += learning_rate * error

word_vectors[word_to_index[target_word]] += learning_rate * error

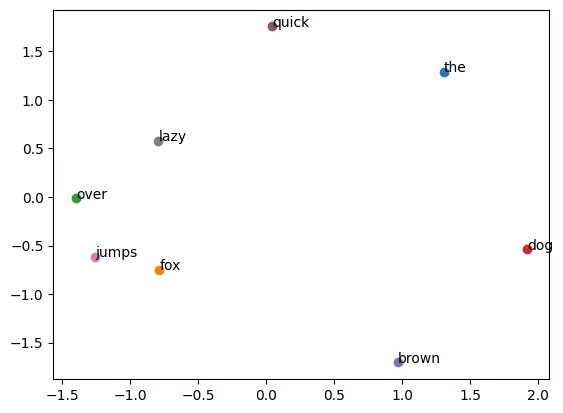

# Visualization (you can use a library like matplotlib for this)

import matplotlib.pyplot as plt

from sklearn.decomposition import PCA

# Reduce the dimensionality of the word vectors for visualization

pca = PCA(n_components=2)

reduced_word_vectors = pca.fit_transform(word_vectors)

for i, word in enumerate(vocab):

x, y = reduced_word_vectors[i]

plt.scatter(x, y)

plt.text(x, y, word)

plt.show()

在这个简化的例子中,我们使用了一个小的词汇表和基本操作进行训练。实际上,你需要更高效的数值操作、负采样和可能更大的数据集来训练有意义的单词嵌入。此外,通常需要使用像matplotlib或seaborn这样的专门库来进行可视化。这个例子提供了一个关于SkipGram过程的基本概念,而没有外部库的帮助。

结论

SkipGram是Word2Vec的一个组成部分,在词向量领域起到了改变游戏规则的作用。它使得机器能够理解单词的意义和它们之间的语义关系,从而在各种自然语言处理和机器学习任务中取得了显著的改进。随着技术的进步,像SkipGram生成的词向量将继续引领我们在数字时代处理和理解人类语言的能力。