人工智能已经拥有智能了吗?

在1950年,英国计算机科学家Alan Turing(艾伦·图灵)提出了一个试验性的方法来回答一个问题:机器能够思考吗?他建议,如果一个人在提问五分钟后无法判断自己是在与一个人工智能机器交流还是另一个人交流,那就证明人工智能具有类似人类智能的能力。

尽管在图灵的一生中,人工智能系统离通过他设计的特定条件的测试还有很大距离,但他推测道:“大约在50年后,将有可能编程计算机……使它们在模拟游戏方面的表现得更加出色,人们提问五分钟后猜对的几率不会超过70%。”

如今,在图灵提出这一观点70多年后,还没有任何人工智能成功通过这个测试并满足他所规定的具体条件。不过有一些系统已经非常接近通过测试的水平。

最近的一项实验测试了包括GPT-4在内的三个大型语言模型。参与者与人或人工智能系统聊天两分钟。人工智能被要求故意出现小的拼写错误,并在测试者变得过于激进时停止回答。

在这种提示下,人工智能成功地欺骗了测试者。当与人工智能机器人配对时,测试者只有60%的准确率能够正确猜测自己是否正在与一个人工智能系统交流。

考虑到自然语言处理系统设计方面取得的快速进展,我们可能会在未来几年内看到人工智能通过图灵最初的测试。

但是,模仿人类真的是测试智能的有效方式吗?如果不是,我们可以使用什么替代标准来衡量人工智能的能力?

图灵测试的局限性

虽然通过图灵测试表明系统具有一定的智能,但这并不是智能的决定性测试。其中一个问题是它可能产生“错误的否定结果”。

现今的大型语言模型通常会立即宣称自己不是人类。例如,当你问一个ChatGPT的问题时,它经常会用短语“作为一个人工智能语言模型”开头回答。即使人工智能系统具备通过图灵测试的能力,这种编程方式也会覆盖这种能力。

测试也存在某些类型的“错误的肯定结果”。正如哲学家Ned Block在1981年的一篇文章中指出的那样,一个系统只需对任何可能的输入进行类似人类的硬编码,就可以通过图灵测试。

除此之外,图灵测试专注于人类认知。如果人工智能认知与人类认知不同,那么专业人士将能够找到人工智能和人类表现不同的任务。

关于这个问题,图灵写道:“这个反对意见确实是一个很有力的反对意见,但至少我们可以说,如果我们能够构建一台机器以令人满意的方式进行模仿游戏,我们就不必担心这个反对意见。”

换句话说,通过图灵测试是一种证明系统具有智能的好证据,而未通过测试并不是证明系统“不具备”智能的好证据。

此外,这个测试并不能很好地衡量人工智能是否有意识、是否能感受痛苦和快乐,以及是否具有道德意义。根据许多认知科学家的说法,意识涉及一系列的心理能力,包括拥有工作记忆、高阶思维以及感知环境和模拟自己在其中移动的能力。

图灵测试无法回答人工智能系统是否具备这些能力的问题。

人工智能的不断增强的能力

图灵测试基于一定的逻辑,即人类具有智能,所以能够有效地模仿人类的任何事物可能都是具有智能的。

但这个想法并不能告诉我们关于智能的本质。衡量人工智能智能程度的一种不同方式是更加批判地思考智能是什么。

目前没有单一的测试可以权威地衡量人工智能或人类智能。

在最广泛的层面上,我们可以将智能视为在不同环境中实现一系列目标的能力。更智能的系统能够在更广泛的环境中实现更广泛的目标。

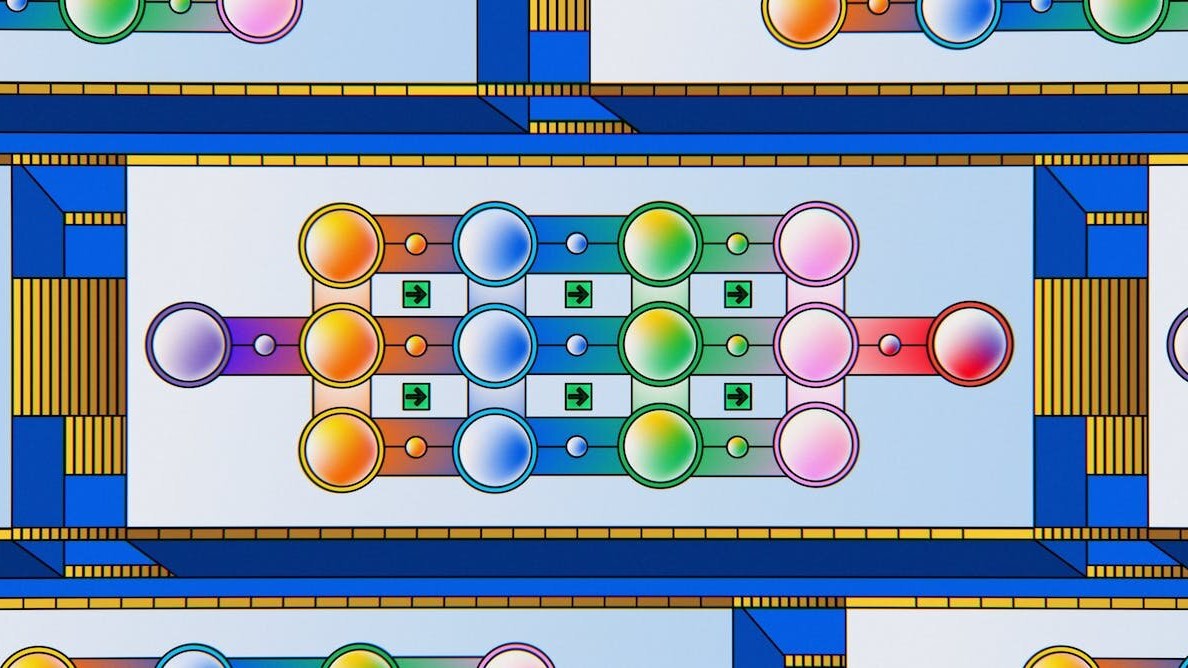

因此,跟踪通用人工智能系统设计方面的进展的最佳方法是评估其在各种任务中的表现。机器学习研究人员已经开发了一系列基准来做到这一点。

例如,GPT-4能够在广泛的专业语言理解多项选择测试中,正确回答86%的问题——这是对大规模多任务语言理解的基准测试,涵盖了一系列大学水平的学术科目。

它在AgentBench中的得分也较高,AgentBench是一种可以衡量大型语言模型作为代理人的能力的工具,例如浏览网页、在线购买产品和参与游戏等。

图灵测试是否仍然适用?

图灵测试是一种模仿的衡量方式,衡量人工智能模拟人类行为的能力。大型语言模型是专家模拟者,这种模拟能力反映在它们通过图灵测试的潜力上。但智能并不等同于模仿。

有多少种类型的智能就有多少种目标要实现。了解人工智能的最好方法是监测其在开发一系列重要能力方面的进展。

同时,在谈到人工智能是否智能的问题时,我们不要一直“改变目标”,这一点很重要。由于人工智能的能力正在迅速提高,对人工智能智能的想法的批评者不断找到人工智能系统可能难以完成的新任务,却发现它们已经越过了另一个障碍。

在这种背景下,问题并不是人工智能系统是否具有智能,而更精确的问题是,它们可能拥有哪种“类型”的智能。