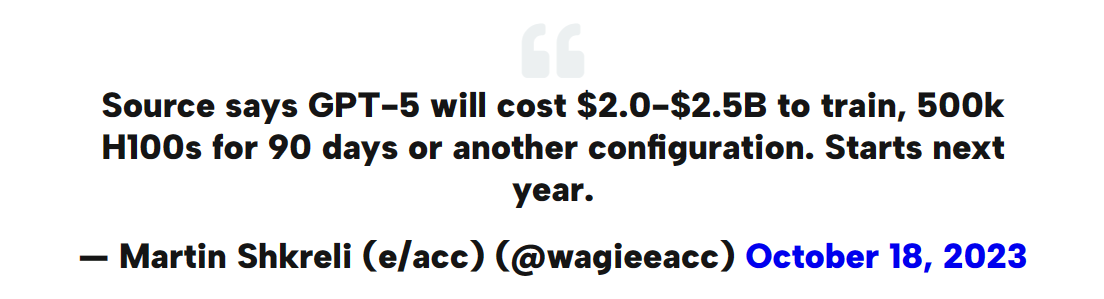

消息称GPT-5训练将耗资25亿美元并于明年开始

有消息称,GPT-5的训练需要耗资20亿至25亿美元。这次训练将持续90天,需要使用50万个H100s Tensor Core GPU,或者是其他配置。训练计划将于明年开始。

OpenAI正在积极改进GPT-4,增加了一些功能,例如具身化、代理功能、苏格拉底式推理、知识图谱、世界模型、多模态、规划、语义解释性、群体智慧、控制和有界性,以及一些更小的高价值任务。

关于H100/A100的生产规模,人们提出了疑问。这么多的GPU是否足够支持这样一项庞大的任务?预计到今年年底将生产约100万个H100s,明年预计将发货500万个。

关于成本的问题,有一个关于GPU的有效观点。将这些GPU的成本计入训练费用可能会产生误导,因为它们在训练过程结束后并不会过时。仅这些GPU的成本可能就高达200亿美元。

值得注意的是,芯片制造公司Sustainable Metal Cloud(SMC)目前每月最多可以生产15000台H100s,但他们已经将产能提高到每月约50000台。

就电力成本而言,它们只占总计算成本的一小部分。以600万千瓦时为例,大约相当于100万美元。

到明年收购50万个H100s看起来是一项具有挑战性的任务,即使有微软的支持。此外,如果训练过程确实像所暗示的那样计算密集,那么推理过程的成本也是一个问题。

就Nvidia在2023年的市场表现而言,有消息称其成功增长了两倍,超过了1万亿美元。这种增长主要归功于Nvidia芯片在人工智能应用中的广泛采用。然而,需要考虑到美国出口限制对高端人工智能芯片在中国市场销售的限制,这可能会影响制造和训练成本。

据Barron's的高级作家Tae Kim称,Nvidia每销售一台H100 GPU加速器就可以达到几乎千倍的利润百分比。这意味着Nvidia每台高性能计算加速器的市场价约为25,000至30,000美元,其中包括每个芯片和外围组件的成本约为3,320美元。成本分析尚不清楚,但据信是纯粹的制造成本问题。此外,还需要考虑到Nvidia的研发成本,因为研发像H100这样的芯片需要数千小时的专业工作。不过,Nvidia的人工智能加速产品已经销售到2024年,到2027年,人工智能加速器市场的价值预计将达到约1500亿美元。

该公司正在从其基础设施和产品组合中受益,但预算和机会成本可能会限制对其他领域的投资或降低研究和开发领域的风险。