通过检索增强双指令调优 (RA-DIT) 提高RAG有效性

介绍

大型语言模型(LLMs)通过访问相关的背景知识任务的外部数据来提高性能。然而,现有的方法要求在语言模型的预训练期间进行昂贵的修改,或在模型训练后集成数据存储。不幸的是,这两种策略都会导致性能不佳。

为了解决这个问题,Meta的人工智能研究团队提出了一种称为RA-DIT的方法:检索增强的双重指令调整,可以使任何LLM升级以包含检索特性。

在本文中,我们将探讨RA-DIT在建立数据集和对模型进行微调以实现更好的检索增强生成(RAG)性能方面的能力。

RA-DIT方法包括两个独立的微调步骤:

1. 更新预训练的语言模型以更好地利用检索到的信息。

2. 更新检索器以返回更相关的结果。

工作原理

RA-DIT方法分别对LLM和检索器进行微调。通过更新LLM,使其在给定检索增强指令的情况下最大化正确答案的概率,同时通过更新检索器,使其最小化文档在语义上与查询的相似度。

下面我们将详细介绍从生成微调数据集、针对更好的预测对语言模型进行微调,以及优化检索搜索过程的每个步骤。

微调数据集

微调数据集针对增强语言模型在生成预测过程中利用知识和提高上下文意识能力方面进行了定制。生成问答对、总结数据以及结合推理链思维可以在与模型集成时带来更好的结果。

在跟随我们的LamaIndex实现后,我们检索出top_k节点,从文档中生成Q/A对,然后扩充数据。我们通过QueryResponseDataset模块使用这些Q/A对,该模块返回一个(查询,响应)对作为微调数据集。而检索微调数据集则是基于Q/A对数据创建的。

语言模型微调

有了我们的微调数据集,我们可以优化LLM以实现两个主要的好处:适应LLM更好地利用相关的背景知识,并训练LLM即使在错误的检索块情况下也能产生准确的预测,使模型能够依赖自己的知识。

检索器微调

用LM-Supervised Retrieval (LSR)方法对检索器进行了精细调整。在这种方法中,LLM评估检索器所获取的信息。如果LLM发现信息与给定的查询不匹配,它会向检索器发送反馈。通过这个反馈,检索器调优其搜索过程,确保获取LLM可以有效使用的数据。这种合作提高了所提供答案的整体质量。

评估

为了评估所提出的方法,作者使用了特定的数据集和指标。让我们深入了解每个指标,以更好地了解实验结果。

指标

使用“完全匹配”(EM)指标来衡量模型预测与真实答案的相似程度。

数据集

该方法在两个不同的任务上进行了测试:

1. 知识密集型任务。

2. 常识推理。

让我们探索用于这两个任务的数据集。

知识密集型数据集

对于知识密集型任务,所选择的数据集主要关注模型获取、理解和传达深入和具体知识的能力。它们包含了关于事实、常识和复杂领域特定查询的问题;

使用的数据集包括MMLU、自然问题(NQ)、TriviaQA以及KILT基准中的一部分任务。

常识推理数据集

常识推理数据集挑战模型基于常识和日常场景进行推理和推断的能力。它们包含了通常不依赖深入领域知识而是依靠直观和通用世界理解的问题和情境。

所使用的数据集包括BoolQ、PIQA、SIQA、HellaSwag、WinoGrande、ARC-E、ARC-C、OBQA。

结果

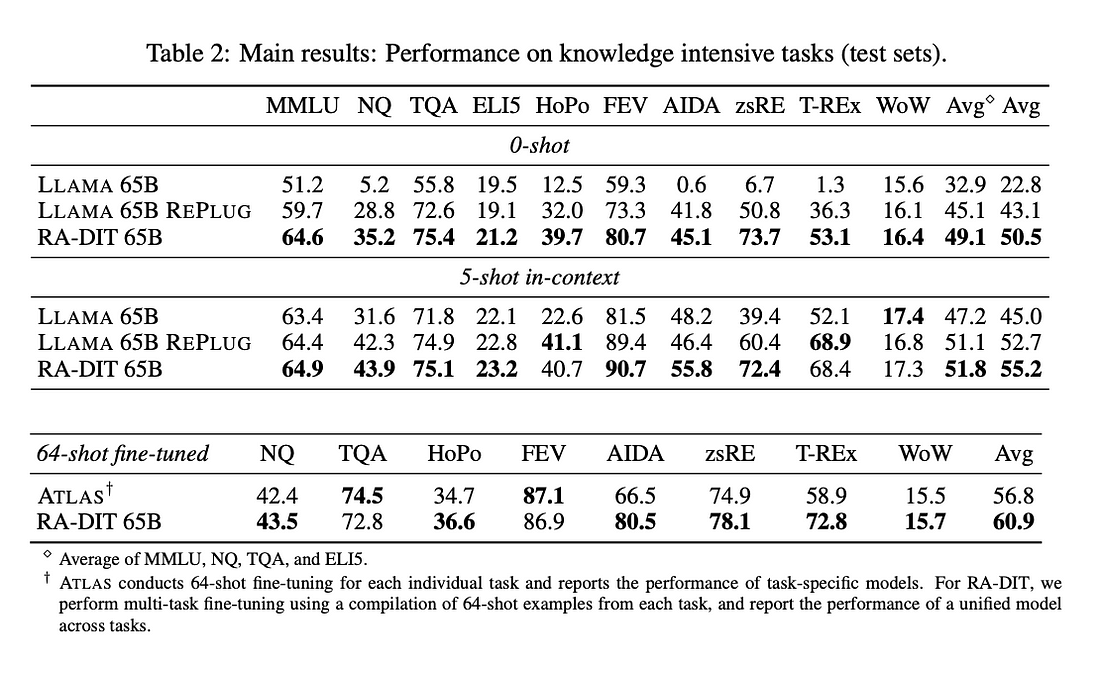

在对知识密集型任务(Table 2)和常识推理任务(Table 3)的模型性能进行比较分析时,考虑了三个模型:

LLAMA 65B

LLAMA 65B REPLUG (只有检索增强)

RA-DIT 65B

知识密集型任务

评估在0-shot、5-shot和64-shot的微调设置下进行。

0-shot分析:

RA-DIT 65B的平均EM得分为50.5,在所有任务中表现优秀。

它的表现超过了LLAMA 65B REPLUG (43.1平均)和明显超过了LLAMA 65B (32.9平均)。

5-shot分析:

RA-DIT 65B以55.2的平均EM得分保持领先。

LLAMA 65B REPLUG紧随其后,平均为52.7,而LLAMA 65B的平均得分为45.0。

在64-shot微调的独立评估中,分析了两个模型:ATLAS和RA-DIT 65B。

64-shot微调:

RA-DIT 65B在所有任务中平均表现为60.9,略优于ATLAS的平均得分56.8。

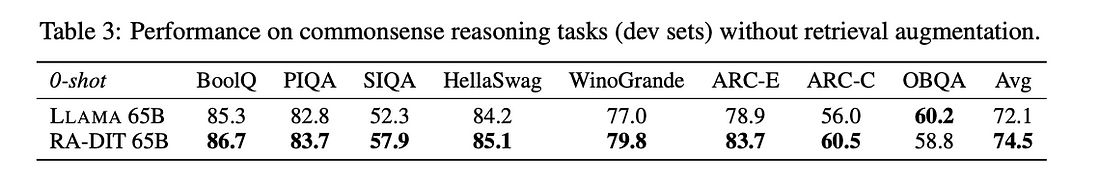

常识推理

为了评估检索增强指令调优对LLM参数化知识和推理能力的影响,RA-DIT 65B 进行了基准测试。

在没有检索增强的实验中,RA-DIT 在8个评估数据集中有7个显示出对基本LLAMA 65B模型的改进,这表明LLM组件的参数化知识和推理能力在一般情况下得到了保留。

总结起来,RA-DIT 65B在多种场景中一贯表现出色,超越了竞争对手,突出了其在知识密集型任务中的熟练程度和能力,同时也显示出了LLM的参数化知识和推理能力仍然得到了保留。

结论

RA-DIT方法提供了一种结构化的方法来提升大型语言模型利用外部数据的能力。通过对模型和检索器的双重微调,我们旨在提高回答的准确性和上下文感知能力。

LSR技术的引入促进了更高效的数据检索过程,确保生成的回答既相关又有根据。最终结果显示,RA-DIT超过了未调整的RALM方法,如REPLUG,展现出竞争力。