破坏工具采用AI图像抓取器

研究人员在芝加哥大学宣布开发了一种名为"Nightshade"的工具,该工具可以“毒害”被人工智能公司用于训练图像生成模型的图形。Nightshade通过操纵图像像素来改变训练期间的输出结果。在处理之前,这些改变是肉眼不可见的。

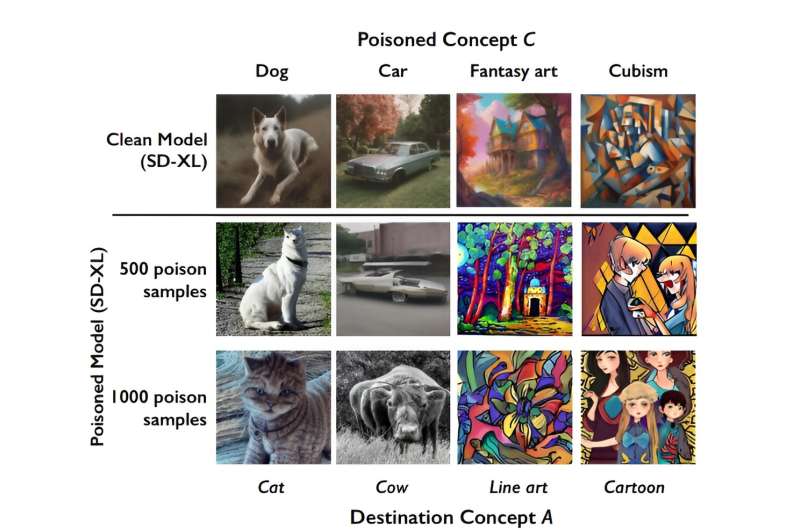

论文《文本到图像生成模型上的特定提示毒害攻击》的作者之一Ben Zhao表示,Nightshade可以操纵数据,使狗的图像在训练时转换为猫等。在其他情况下,汽车图像会被转换为汽车,帽子会变成蛋糕。这项工作已经发表在arXiv预印本服务器上。

Ben Zhao认为,适度数量的Nightshade攻击可以破坏文本到图像生成模型中的通用特征,有效地使其无法生成有意义的图像。

他将他的团队的创作称为“对抗那些忽视不爬取指令/不爬取指示的网络爬虫的内容创作者的最后防线”。

长期以来,艺术家们一直担心像谷歌、OpenAI、稳定AI和Meta这样的公司在收集数十亿张在线图像用于训练赚钱的图像生成工具时,未向创作者提供补偿。

荷兰人工智能监管欧洲公会的顾问Eva Toorenent说,这种做法“抽取了数百万艺术家的创造力”。

“这绝对令人恐惧,"她在最近的一次采访中说。

Ben Zhao的团队证明了尽管人们普遍认为破坏爬取操作需要上传大量修改后的图像,但他们只使用少于100个“毒害”样本就能实现破坏。他们通过使用特定提示的毒害攻击来实现这一点,这种攻击所需的样本数量远少于模型训练数据集。

Ben Zhao认为Nightshade不仅对个人艺术家有用,对大型公司如电影制片厂和游戏开发者也很有用。

“例如,迪士尼可能会将Nightshade应用到他们的‘灰姑娘' 的印刷图像上,同时与其他人协调 ‘人鱼' 的毒害概念。”Ben Zhao说道。

Nightshade还可以改变艺术风格。例如,要求以巴洛克风格创作的提示可能产生立体派风格的图像。

该工具出现在人们对人工智能公司侵占网络内容的反对声中。根据这些公司所说的公平使用规则,人们对谷歌和微软的OpenAI去年提起了诉讼,指控这些科技巨头未经授权使用版权材料来训练他们的人工智能系统。

原告律师Ryan Clarkson表示:“谷歌不拥有互联网,也不拥有我们的创作作品,也不拥有我们对个人、我们的家庭和孩子的图片或其他任何东西,只是因为我们在网上分享它。”如果被认定有罪,这些公司将面临数十亿美元的罚款。

谷歌寻求驳回诉讼,称在法庭文件中:“使用公开可用的信息进行学习不是偷窃,也不是侵犯隐私、转化、过失、不公平竞争或侵犯版权。”

根据Toorenent的说法,Nightshade "将使(人工智能公司)三思而行,因为他们有可能通过未经我们同意而取走我们的作品,从而破坏他们的整个模型。”