LlaVA:第一个开源GPT-4V替代品

最近OpenAI发布了GPT-4的新图像和音频处理功能。基本上,AI实验室宣布了一个名为GPT-4 Vision(GPT-4V)的新模型,允许用户对图像和音频输入指示GPT-4。 GPT-4V是多模态基础模型领域的一个有趣的发展。在GPT-4V发布几天后,我们已经有了第一个开源的替代品。威斯康辛大学麦迪逊分校和微软研究院的研究人员推出了大型语言和视觉助手(LLaVA),这是一种基于LLaMA的多模态LLM,可以处理图像和音频数据作为输入。

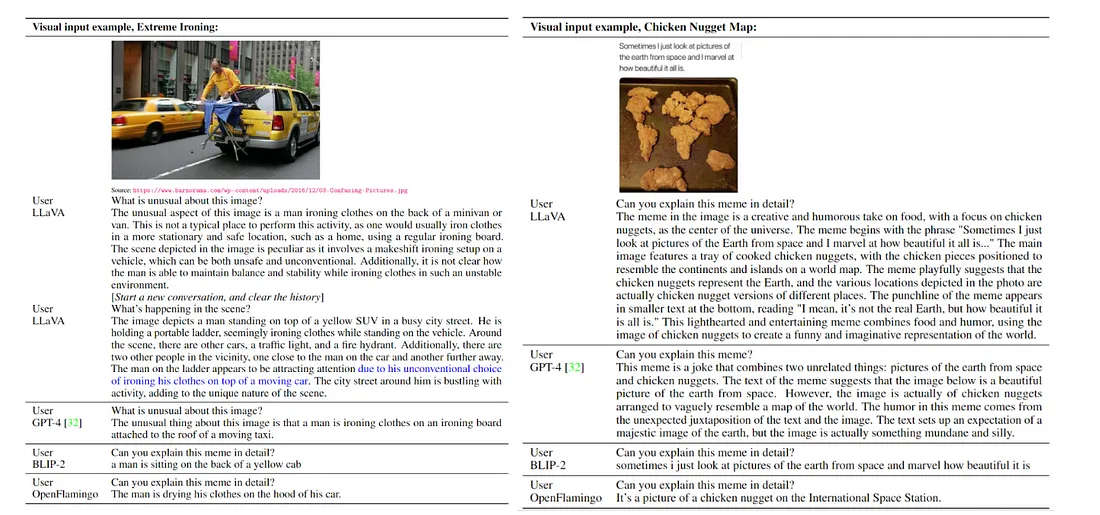

LLaVA是一个端到端训练的奇迹,无缝地连接了视觉编码器和LLM(大型语言模型),以提供全面的视觉和语言理解。与LLaVA的早期实验揭示了其在多模态聊天交互中的卓越能力,有时甚至在面对以前未见的图像和指示时展现出与备受期待的多模态GPT-4类似的行为。

在这个努力中取得的突破性进展之一是对视觉指令调整的探索。这标志着将指令调整的概念扩展到多模态AI领域的开创性努力,从而为通用的多功能视觉助手的开发奠定了基础。伴随LLaVA的发布的论文在以下方面对该领域做出了重大贡献:

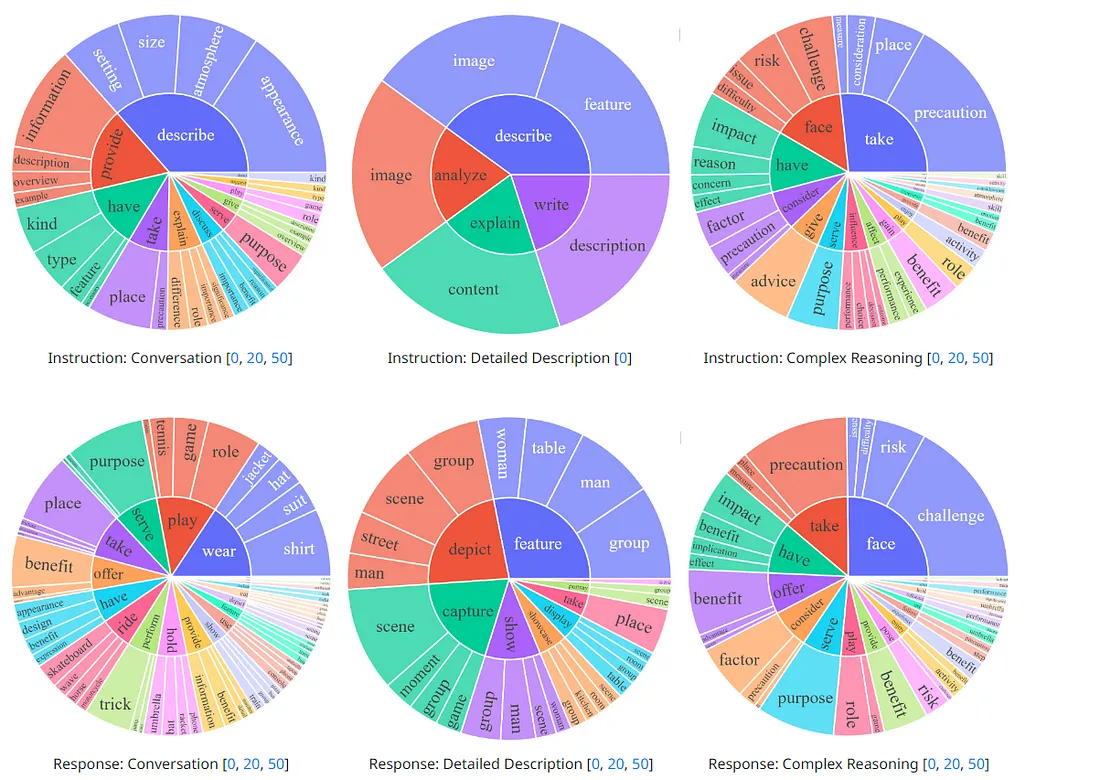

· 多模态指令跟随数据:在这个过程中面临的一个关键挑战是视觉语言指令跟随数据的稀缺性。为了解决这个问题,设计了一种新颖的数据改革方法和流水线。这种技术有效地将图像和文本对转化为所需的指令跟随格式,利用了ChatGPT/GPT-4的强大能力。

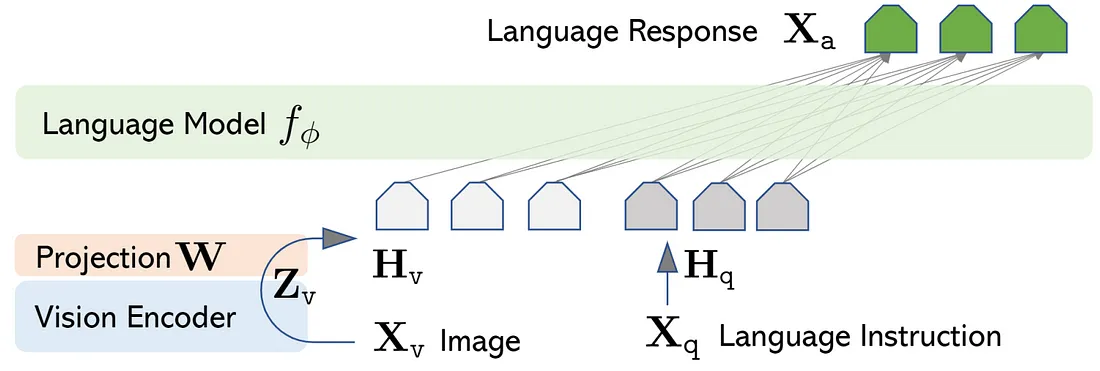

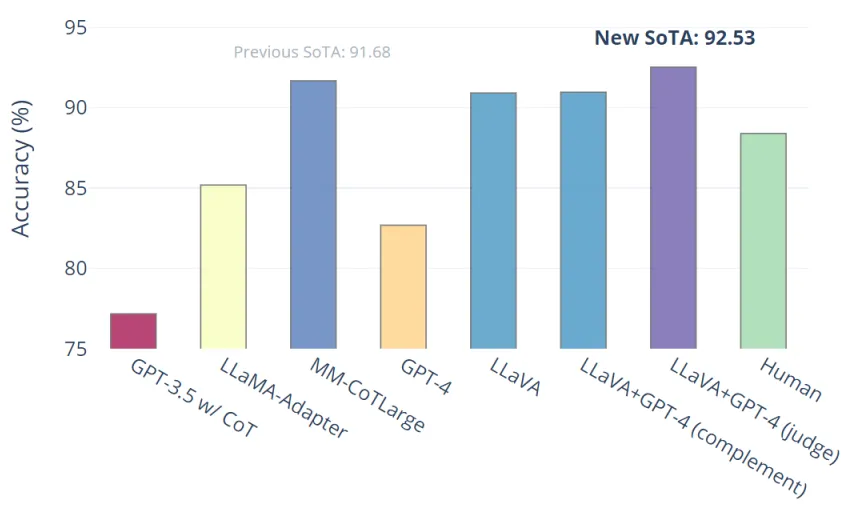

· 大型多模态模型:通过将来自CLIP的开放式视觉编码器与名为LLaMA的语言解码器相结合,将LLaVA变成了一种大型多模态模型(LMM)。这一壮举通过使用项目期间生成的视觉语言数据一起对这些组件进行微调来实现。广泛的实证研究验证了使用生成数据进行LMM指令调整的有效性,并提供了实用的洞察力,对开发多功能指令跟随视觉代理提供了指导。值得注意的是,与GPT-4相比,LLaVA在科学QA多模态推理数据集上取得了最先进的性能。

· 开源计划:为了促进合作和知识共享,LLaVA团队自豪地向公众发布了几个有价值的资产。

LLaVA的最大贡献可以说是它如何利用GPT-4生成经过指令调整的数据集。

使用GPT-4生成视觉指令数据

在多模态数据领域,社区目睹了大量公开可用资源的大量涌入,涵盖了从CC到LAION的广泛的图像和文本对。然而,当涉及到多模态指令跟随数据时,可用的资源仍然有限。这在一定程度上是因为涉及到依赖人工众包的费力且有些模糊的过程。得益于最近GPT模型在文本注释任务上的显著成功,提议出现了一个想法:让我们利用ChatGPT/GPT-4的强大能力来收集多模态指令跟随数据,利用现有图像对数据的丰富。

考虑一张图片Xv及其对应的标题Xc。它自然地将自己逐渐扩展为一组问题Xq,旨在指示一个AI助手描述图像的内容。通过启动GPT-4,我们策划了这样一组问题,正如附录中的表8所展示的那样。因此,将图像文本对扩展为它的指令跟随对应物的简单方法形成了:人类提出问题Xq Xv<STOP>nn,助手以Xc<STOP>nn作为回应。虽然这种直接扩展方法具有成本效益,但在指令和结果的多样性和深度方面仍然有些局限。

为了解决这个问题,这种方法转而利用以语言为重点的GPT-4或ChatGPT作为强大的教师。这些模型以文本作为输入,开始制作包含视觉内容的指令跟随数据。方法清晰:为了将图像转化为仅接受文本的GPT的视觉特征,使用符号表示。这些表示分为两类:

· 标题:这些标题作为文本描述,提供对视觉场景多样化的观点。

· 边界框:这些方便的框用于定位和界定场景中的对象。每个框不仅编码对象概念,还编码其空间位置。

· 通过这种创新方法,扩展多模态指令跟随数据的努力正在解锁多样性和深度的新维度,弥合了视觉内容和文本指令之间的差距。

LLaVA架构

LLaVA通过简单的投影矩阵无缝连接了经过预训练的CLIP ViT-L/14视觉编码器和强大的大型语言模型Vicuna。其卓越能力的实现过程分为两个阶段的指令调整过程:

阶段1:特征对齐的预训练

在这个初始阶段,重点是仅更新投影矩阵。这个更新是基于CC3M数据子集进行的,为进一步的改进奠定了基础。

阶段2:端到端微调

在这里,动力逐渐增长,因为投影矩阵和LLM都会进行更新,以满足两个不同的使用场景:

· 视觉对话:LLaVa通过我们精心设计的多模态指令遵循数据进行微调,旨在满足用户的日常需求。

· 科学问答:LLaVa通过一个专门针对科学领域的多模态推理数据集进行微调的旅程开始。

使用机器生成的指令遵循数据对大型语言模型(LLMs)进行指令调整的概念,无疑提升了语言领域的零迁移能力。然而,在多模态人工智能领域,它的应用仍然是相对未知的领域。

初步结果

与GPT-4相比,对LLaVA的初步评估结果显示出令人难以置信的成果。

这些实验揭示了LLaVa令人印象深刻的聊天能力,有时在面对未知的图像和指令时,其行为甚至与多模式GPT-4相似。在一个合成的多模式指令跟随数据集上,相对于GPT-4,LLaVa得到了令人瞩目的85.1%的相关分数。此外,在LLaVa和GPT-4在科学问答上进行微调后,它们合力达到了前所未有的最新准确性,达到了惊人的92.53%。

LLaVA代表着在多模式LLM世界中令人兴奋的一项重要发展,并且对于开放源代码基金会模式运动而言是一个重要的步骤。