标签识别中的数据泄露:批判性分析

介绍

在数据驱动的决策制定时代,从医疗到金融、从营销到研究,数据的收集、处理和分析过程在各个领域中起着至关重要的作用。数据分析的一个基本步骤是正确地识别数据集中的标签或类别。然而,这个看似简单的任务可能会面临诸多挑战,特别是在数据泄漏发生时。标签识别中的数据泄漏可能会带来深远的后果,影响数据分析的可靠性和完整性。本文探讨了数据泄漏在标签识别中的概念、其原因、后果以及缓解其影响的策略。

数据泄露在标签识别中的漏洞:批判性分析教会我们,在数据领域中,一个微小的泄露可能引发连锁反应的后果。小心处理数据,并让透明度成为你在分析海洋中的指南针。

了解数据泄露

数据泄露是指敏感信息或属性在数据集中被意外或未经授权地暴露。当涉及到标签识别时,数据泄露发生在模型训练过程中本应隐藏的信息被无意中透露,导致模型从本不应有访问权限的数据中学习。这可能导致误导性的结果和对模型性能的过高估计。

数据泄露的原因

标签识别中的数据泄露可能源于各种原因:

1. 不充分的数据划分:将数据集划分为训练集和测试集时,确保在训练期间标签始终对模型隐藏是至关重要的。未能正确地将数据进行分隔可能导致无意的数据泄露。

2. 特征引发的泄露:有时,用于模型训练的特征包含有关标签的信息。当特征源于标签本身或某些特征与标签之间存在强相关性时,这种情况可能发生。

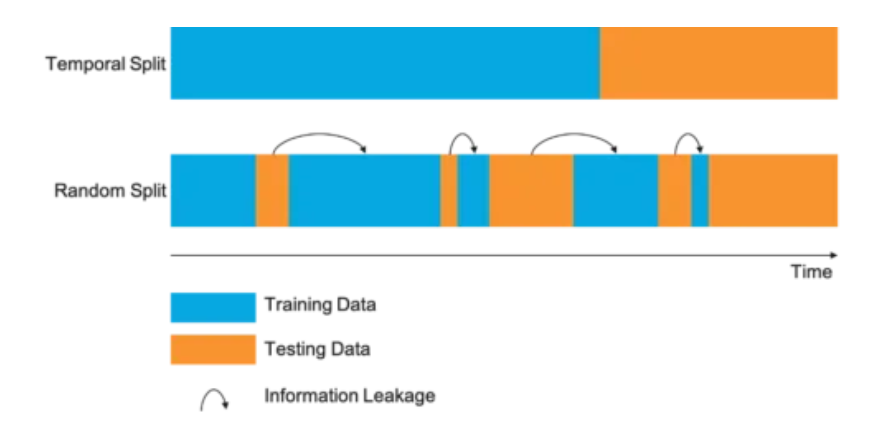

3. 时间相关性泄露:在时间序列数据中,如果使用未来的信息来预测过去的标签,就会发生数据泄露。例如,使用未来的股票价格来预测历史市场走势将引入数据泄露。

4. 外部数据:未正确隔离外部数据源并将其纳入训练过程中可能导致数据泄露,因为这些源可能包含模型不应访问的标签信息。

数据泄露的后果

标签识别中的数据泄露可能产生深远的后果:

1. 高估的模型性能:当模型无意中从标签中学到东西时,在训练期间它可能表现得异常出色,但在应用于新的、未知的数据时却无法推广。这种模型性能的过高估计可能导致误导性决策。

2. 降低模型的稳健性:受数据泄露影响的模型在实际情境中往往不够稳健,因为它们依赖于可能在新数据中不存在的模式。

3. 结果偏差:数据泄露可能导致模型中引入偏差,使其在某些涉及敏感信息的情况下,如贷款审批或医学诊断中做出错误预测。

4. 失去信任:数据泄露可能削弱人们对数据分析过程和使用的模型的信任,利益相关者可能会对结果的可靠性产生质疑。

减少数据泄露的措施

减少标签识别中的数据泄漏对确保数据分析的完整性至关重要。可以采取以下几种策略:

1. 仔细的数据划分:确保数据划分过程明确地将训练数据和测试数据分开,模型训练时标签应保持隐藏。

2. 特征选择:仔细审查特征,排除任何潜在的泄露,并根据需要删除或转换特征,以防止模型学习标签。

3. 交叉验证:采用交叉验证技术更准确地评估模型性能,并降低数据泄露的风险。

4. 定期审查数据源:定期审查数据来源,发现并消除潜在的泄露点,例如可能包含标签的外部数据。

5. 专家咨询:在复杂情况下,考虑引入领域专家,他们可以提供关于数据泄露可能性的见解,并协助防止其发生。

代码示例

创建一个完整的Python代码示例来说明数据泄露的数据集和图表可能是一项复杂的任务,因为它取决于具体的数据集和情景。然而,我可以为你提供使用合成数据和流行的scikit-learn库来简化说明数据泄露的例子。

import numpy as np

import matplotlib.pyplot as plt

from sklearn.datasets import make_classification

from sklearn.model_selection import train_test_split

from sklearn.linear_model import LogisticRegression

# Create a synthetic dataset

X, y = make_classification(n_samples=1000, n_features=2, n_informative=2, n_redundant=0, n_repeated=0, random_state=42)

# Introduce data leakage by using a feature directly related to the target variable

leakage_feature = y * 5 + np.random.normal(0, 1, len(y))

X_leak = np.column_stack((X, leakage_feature))

# Split the data into training and testing sets

X_train, X_test, y_train, y_test = train_test_split(X_leak, y, test_size=0.3, random_state=42)

# Train a logistic regression model

model = LogisticRegression()

model.fit(X_train, y_train)

# Evaluate the model on the testing set

test_accuracy = model.score(X_test, y_test)

# Visualize the data and model decision boundary

plt.figure(figsize=(12, 5))

# Plot the data points with color representing the true labels

plt.subplot(1, 2, 1)

plt.scatter(X[:, 0], X[:, 1], c=y, cmap=plt.cm.Paired)

plt.title("True Labels")

# Plot the data points with color representing the predicted labels

plt.subplot(1, 2, 2)

plt.scatter(X[:, 0], X[:, 1], c=model.predict(X_leak), cmap=plt.cm.Paired)

plt.title("Predicted Labels")

plt.show()

# Print accuracy results

print(f"Testing Accuracy: {test_accuracy:.2f}")

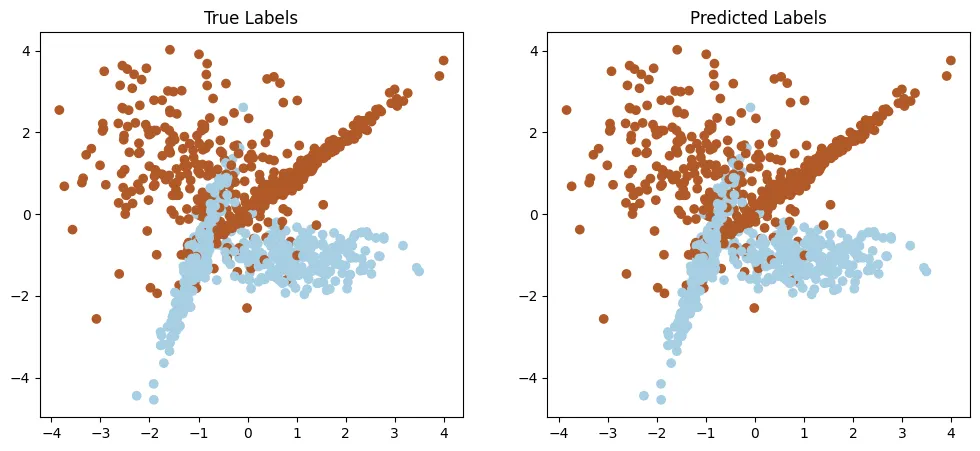

在这段代码中:

1. 我们使用scikit-learn的make_classification函数创建一个合成数据集。

2. 我们通过创建一个与目标变量直接相关的新特征(leakage_feature)引入了数据泄漏。

3. 我们将数据集分为训练集和测试集。

4. 我们在具有数据泄漏的数据集上训练逻辑回归模型。

5. 我们使用两个图表来可视化数据点和模型的决策边界。

6. 最后,我们打印出训练和测试的准确率。

Testing Accuracy: 1.00这个例子中的关键问题在于数据集中引入的泄漏特征直接依赖于目标变量'y',导致数据泄漏。由此,模型在训练中实现了人为高准确率,但在可视化中显示无法正确推广。

结论

在标签识别中,数据泄漏是一个重要的问题,可能损害数据分析的完整性。理解数据泄漏的原因、后果和缓解策略对数据科学家、机器学习从业者和决策者来说至关重要。通过实施谨慎的数据处理和模型训练方法,可以将与数据泄漏相关的风险降至最低,在数据分析和机器学习领域获得更可靠和准确的结果。